ワシントン大学の研究チームは、SAM2 に基づいた新しい視覚追跡モデル SAMURAI を発表し、複雑なシーンにおける視覚追跡、特に高速で移動する自己遮蔽物体の追跡の課題を克服することを目的としています。 SAMURAI は、一時的なモーション キューとモーションを認識したメモリ選択メカニズムを導入することで、オブジェクトのモーション予測機能とマスク選択の精度を大幅に向上させ、再トレーニングなしで堅牢で正確な追跡を実現し、複数のベンチマーク データ セットで優れたパフォーマンスを実現します。

最近、ワシントン大学の研究チームは、SAMURAI と呼ばれる新しい視覚追跡モデルをリリースしました。このモデルは、Segment Anything Model2 (SAM2) に基づいており、特に高速で移動するオブジェクトや自己遮蔽オブジェクトを扱う場合に、複雑なシーンでの視覚オブジェクト追跡で遭遇する課題を解決するように設計されています。

SAM2 は、オブジェクトのセグメンテーション タスクでは優れたパフォーマンスを発揮しますが、視覚的な追跡ではいくつかの制限があります。たとえば、混雑したシーンでは、固定ウィンドウの記憶では選択されたメモリの品質が考慮されず、ビデオ シーケンス全体にエラーが伝播する可能性があります。

この問題を解決するために、研究チームはSAMURAIを提案しました。SAMURAIは、時間的動きキューと動き知覚記憶選択メカニズムを導入することで、物体の動きの予測能力とマスク選択の精度を大幅に向上させます。この革新により、SAMURAI は再トレーニングや微調整を必要とせずに、堅牢かつ正確な追跡を実現できます。

リアルタイム操作の観点から、SAMURAI は強力なゼロショット パフォーマンスを実証しました。これは、モデルが特定のデータ セットでトレーニングされていなくても良好なパフォーマンスを発揮できることを意味します。

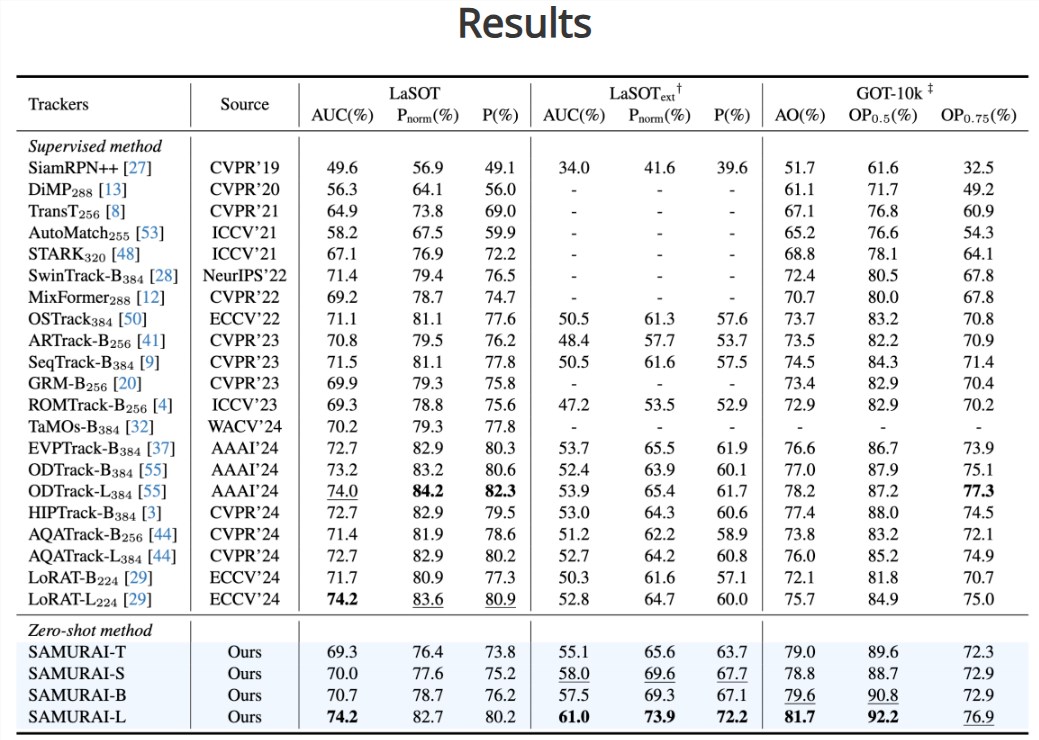

研究チームは評価を通じて、複数のベンチマーク データセットに対する SAMURAI の成功率と精度が大幅に向上していることを発見しました。 LaSOT-ext データセットでは、SAMURAI は 7.1% の AUC 増加を達成しましたが、GOT-10k データセットでは 3.5% の AO 増加を達成しました。さらに、完全に教師ありの手法と比較して、SAMURAI は LaSOT データセット上で同等の競争力を発揮し、複雑な追跡シナリオにおける堅牢性と幅広い応用可能性を実証しています。

研究チームは、SAMURAIの成功は、より複雑で動的な環境における視覚追跡技術の将来の応用の基礎を築くと述べた。彼らは、このイノベーションが視覚追跡分野の発展を促進し、リアルタイム アプリケーションのニーズを満たし、さまざまなスマート デバイスに強力な視覚認識機能を提供できることを期待しています。

プロジェクト入口: https://yangchris11.github.io/samurai/

ハイライト:

SAMURAI は、SAM2 モデルを革新的に改良したもので、複雑なシーンにおける視覚オブジェクト追跡機能の向上を目的としています。

動きを認識するメモリメカニズムを導入することで、SAMURAI はオブジェクトの動きを正確に予測し、マスクの選択を最適化し、エラーの伝播を回避できます。

複数のベンチマーク データセット上で、SAMURAI は強力なゼロショット パフォーマンスを示し、追跡の成功率と精度が大幅に向上しました。

SAMURAIモデルの登場は、複雑なシーンにおける視覚追跡技術の大きな進歩を示し、将来のスマートデバイスの視覚認識能力の向上を強力にサポートします。 。