Alibaba Cloud は、新しくアップグレードされた大規模言語モデル Qwen2.5-Turbo をリリースしました。そのコンテキスト長は 100 万トークンを超え、その処理能力は同様の製品をはるかに上回ります。これは長いテキストの処理能力が大幅に向上しており、ユーザーは三体の小説 10 冊または 30,000 行のコードに相当する処理を簡単に処理できるようになります。このモデルは複数のベンチマークテストで良好なパフォーマンスを示し、特に長文理解において GPT-4 を上回り、短文処理の精度を維持しながら極めて高い推論速度と極めて低コストを実現しました。

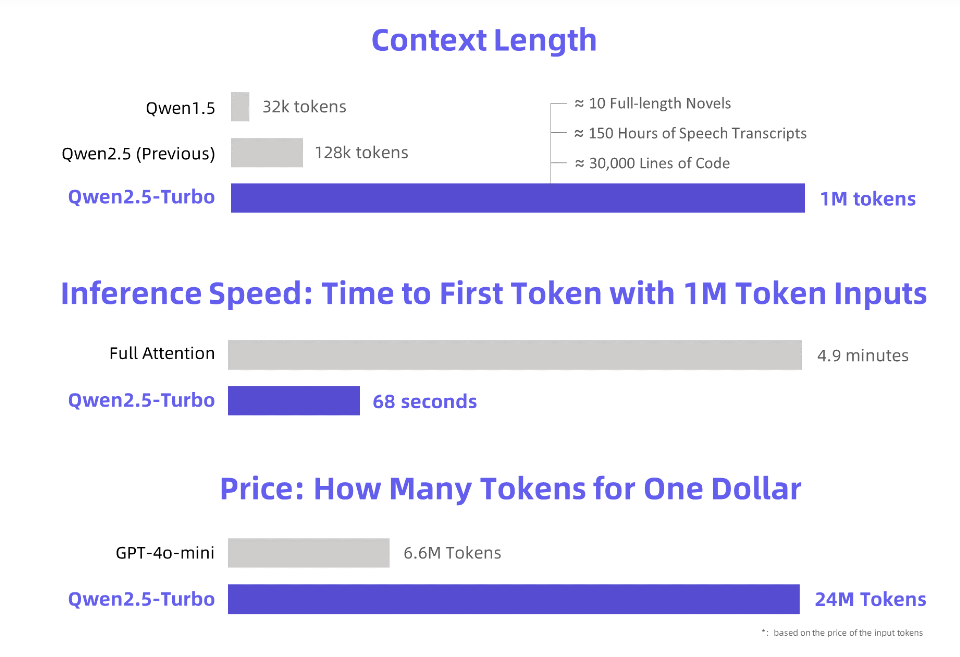

Alibaba Cloud は、新しくアップグレードされた Qwen2.5-Turbo 大規模言語モデルを発表します。そのコンテキスト長は驚くべき 100 万トークンを超えます。この概念は、「三体」小説 10 冊、音声文字起こし 150 時間、またはコード容量 30,000 行に相当します。今回は、「小説 10 冊を一気に読む」も夢ではありません。

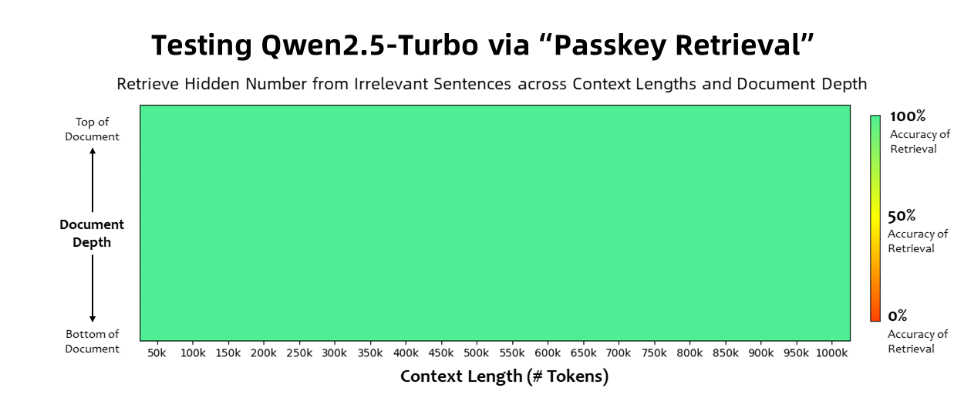

Qwen2.5-Turbo モデルは、パスキー取得タスクで 100% の精度を達成し、長文理解能力の点で GPT-4 などの同様のモデルを上回りました。このモデルは、RULER 長文ベンチマークで 93.1 という高スコアを達成しましたが、GPT-4 のスコアは 91.6 にとどまり、GLM4-9B-1M のスコアは 89.9 でした。

Qwen2.5-Turbo は超長文処理能力に加え、短文処理の精度も備えており、短文ベンチマークテストでは GPT-4o-mini や Qwen2.5-14B-Instruct と同等の性能を発揮します。モデル。

Qwen2.5-Turbo モデルでは、スパース アテンション メカニズムを採用することで、100 万トークンの最初のトークン処理時間が 4.9 分から 68 秒に短縮され、推論速度が 4.3 倍向上しました。

同時に、100万トークンの処理コストはわずか0.3元で、GPT-4o-miniと比較して、同じコストで3.6倍のコンテンツを処理できます。

Alibaba Cloud は、Qwen2.5-Turbo モデルの一連のデモンストレーションを準備し、小説の深い理解、コード支援、複数の論文の読解への応用を示しました。たとえば、ユーザーが 690,000 トークンを含む中国の小説「三体問題」三部作をアップロードした後、モデルは各小説のプロットを英語で要約することに成功しました。

ユーザーは、Alibaba Cloud Model Studio、HuggingFace Demo、ModelScope Demo の API サービスを通じて、Qwen2.5-Turbo モデルの強力な機能を体験できます。

Alibaba Cloudは、今後もモデルの最適化を継続して、長いシーケンスのタスクにおける人間の好みの調整を改善し、推論効率をさらに最適化し、計算時間を短縮し、より大規模で強力なロングコンテキストモデルの立ち上げを試みると述べた。

公式紹介: https://qwenlm.github.io/blog/qwen2.5-turbo/

オンラインデモ: https://huggingface.co/spaces/Qwen/Qwen2.5-Turbo-1M-Demo

API ドキュメント: https://help.aliyun.com/zh/model-studio/getting-started/first-api-call-to-qwen

Qwen2.5-Turboは、強力な長文処理能力と低コストにより、大規模言語モデルアプリケーションの新たな可能性を切り開き、今後の発展が期待されます。 詳細については、提供されているリンクをご覧ください。