大規模モデルのトレーニングのコストを削減することは、人工知能の分野で現在注目されている研究分野です。 Tencent Hunyuan チームが発表した最近の研究では、低ビット浮動小数点量子化トレーニングのスケール ルールについて徹底的に議論されており、大規模モデルの効率的なトレーニングのための新しいアイデアが提供されています。この研究では、多数の実験を通じて、モデルのサイズ、トレーニング データ量、定量化精度などの要因がトレーニング効果に与える影響を分析し、最終的に、さまざまな精度の下でトレーニング リソースを効果的に割り当てて、最高の結果。この研究は理論的に重要な意味を持つだけでなく、大規模モデルの実用化に貴重な指針を提供します。

今日、大規模言語モデル (LLM) の急速な発展に伴い、モデルのトレーニングと推論のコストが研究と応用の焦点になっています。最近、Tencent Hunyuan チームは、低ビット浮動小数点量子化トレーニングの「スケーリング則」、つまり浮動小数点量子化トレーニングのスケーリング則を深く調査した重要な研究を発表しました。この研究の核心は、モデルの精度を下げることでパフォーマンスを損なうことなく、コンピューティングとストレージのコストを大幅に削減する方法を探ることです。

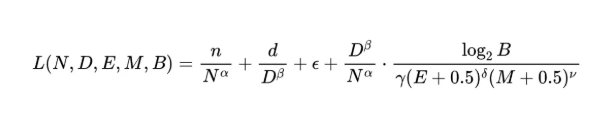

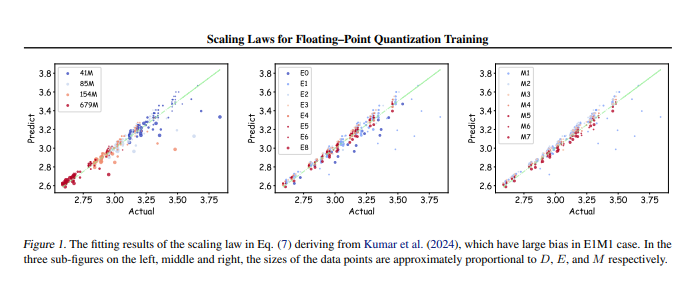

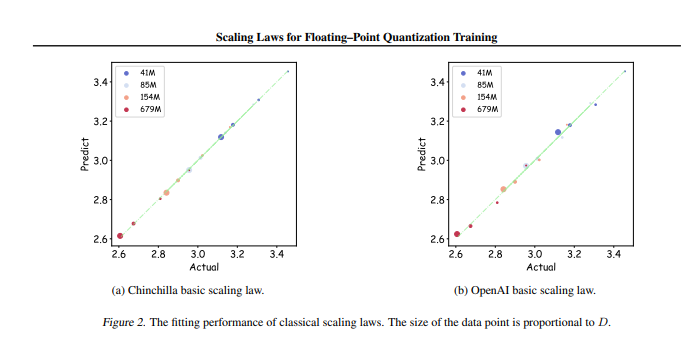

研究チームは、異なるパラメータサイズと精度で最大366セットの浮動小数点定量化トレーニングを実施し、モデルサイズ(N)、トレーニングデータ量(D)、指数ビット( E)、仮数ビット (M)、および量子化粒度 (B)。これらの実験を通じて、研究者らは統一されたスケーリング則を導き出し、最良のトレーニング効果を得るために異なる精度でトレーニング データとモデル パラメーターを効果的に構成する方法を明らかにしました。

最も重要なことは、任意の低精度浮動小数点定量化トレーニングでは「限界効果」が存在することが研究で指摘されているということです。つまり、特定の量のデータの下ではモデルのパフォーマンスが最適に達し、それを超えてしまうということです。この量のデータは効果が低下する可能性があります。さらに、この研究では、理論的に最も費用対効果の高い浮動小数点定量化トレーニング精度は 4 ~ 8 ビットであるべきであることも判明しました。これは、効率的な LLM の開発にとって重要な指針となります。

この研究は、浮動小数点の定量化トレーニングの分野におけるギャップを埋めるだけでなく、将来のハードウェア メーカーがさまざまな精度で浮動小数点コンピューティング機能を最適化するのに役立つ参考資料も提供します。最終的に、この研究は大規模モデルのトレーニングの実践に明確な方向性を提供し、限られたリソースでも効率的なトレーニング効果を確実に達成できるようにします。

論文アドレス: https://arxiv.org/pdf/2501.02423

つまり、Tencent Hunyuan チームによるこの研究は、大規模モデルのトレーニングのコストを削減するための効果的なソリューションを提供するものであり、発見されたスケール ルールと最適な精度範囲は、将来の大規模モデルの開発と応用に大きな影響を与えるでしょう。 この研究は、高性能かつ低コストの大規模モデルのトレーニングの方向性を示しており、注目と詳細な研究に値します。