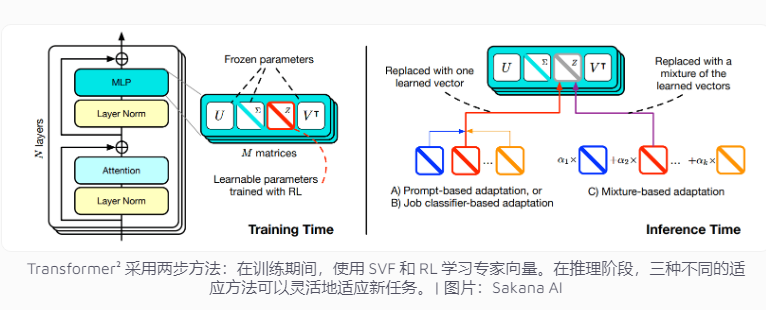

日本の企業、Sakana AI は最近、言語モデル タスクの適応性を向上させるために設計された革新的なテクノロジーである Transformer² をリリースしました。複数のタスクを一度に処理する必要がある従来の AI システムとは異なり、Transformer² はエキスパート ベクトルと特異値微調整 (SVF) テクノロジーを使用した 2 段階の学習を使用するため、ネットワーク全体を再トレーニングすることなく、新しいタスクに効率的に適応できます。これにより、リソースの消費が大幅に削減され、モデルの柔軟性と精度が向上します。このテクノロジーは、ネットワーク接続の重要性を制御するエキスパート ベクトルを学習することで数学的演算、プログラミング、論理的推論などの特定のタスクに焦点を当て、強化学習を組み合わせてモデルのパフォーマンスをさらに最適化します。

現在の人工知能システムは通常、1 回のトレーニングで複数のタスクを処理する必要がありますが、新しいタスクに直面すると予期せぬ課題に遭遇する傾向があり、その結果、モデルの適応性が制限されます。 Transformer² の設計コンセプトは、ネットワーク全体を再トレーニングすることなく、モデルが新しいタスクに柔軟に対応できるようにするエキスパート ベクトルおよび特異値微調整 (SVF) テクノロジーを使用して、この問題を目的としています。

従来のトレーニング方法では、ニューラル ネットワーク全体の重みを調整する必要がありますが、コストがかかるだけでなく、モデルが以前に学習した知識を「忘れる」可能性があります。対照的に、SVF 技術は、各ネットワーク接続の重要性を制御する専門ベクトルを学習することで、これらの問題を回避します。エキスパート ベクトルは、ネットワーク接続の重みマトリックスを調整することで、モデルが数学的演算、プログラミング、論理的推論などの特定のタスクに集中できるようにします。

このアプローチにより、モデルを新しいタスクに適応させるために必要なパラメーターの数が大幅に削減されます。たとえば、LoRA メソッドでは 682 万個のパラメータが必要ですが、SVF では 160,000 個のパラメータしか必要ありません。これにより、メモリと処理能力の消費が削減されるだけでなく、モデルが特定のタスクに集中している間に他の知識を忘れることも防止されます。最も重要なことは、これらの専門家ベクトルが効果的に連携して、多様なタスクに対するモデルの適応性を向上できることです。

適応性をさらに向上させるために、Transformer² には強化学習が導入されています。トレーニング プロセス中、モデルはタスクの解決策を提案し、フィードバックを取得することでエキスパート ベクトルを継続的に最適化し、それによって新しいタスクのパフォーマンスを向上させます。チームは、この専門知識を活用するために、適応キュー、タスク分類子、および少数ショット適応という 3 つの戦略を開発しました。特に、少数ショット適応戦略は、新しいタスクの例を分析し、エキスパート ベクトルを調整することにより、モデルの柔軟性と精度をさらに向上させます。

Transformer² は、複数のベンチマークで従来の手法である LoRA よりも優れたパフォーマンスを示します。数学的タスクでは、パフォーマンスが 16% 向上し、必要なパラメーターが大幅に減少しました。新しいタスクに直面したとき、Transformer² の精度は元のモデルより 4% 高くなりましたが、LoRA は期待された結果を達成できませんでした。

Transformer² は、複雑な数学的問題を解決するだけでなく、プログラミング機能と論理的推論機能を組み合わせて、クロスドメインの知識共有を実現します。たとえば、チームは、エキスパート ベクトルを転送することでより大きなモデルの知識を活用することで、より小さなモデルでもパフォーマンスを向上させることができることを発見しました。これにより、モデル間の知識共有の新たな可能性がもたらされます。

Transformer² はタスクへの適応性において大幅な進歩を遂げましたが、依然としていくつかの制限に直面しています。現在、SVF を使用してトレーニングされたエキスパート ベクトルは、事前トレーニングされたモデルの既存の機能にのみ依存することができ、完全に新しいスキルを追加することはできません。真の継続的な学習とは、モデルが新しいスキルを独自に学習できることを意味します。この目標を達成するにはまだ時間がかかります。 700 億を超えるパラメータを持つ大規模モデルにわたってこの手法をどのように拡張するかは、未解決の問題のままです。

全体として、Transformer² は継続学習の分野で大きな可能性を示しており、その効率的なリソース利用と大幅なパフォーマンスの向上は、将来の言語モデルの開発に新しい方向性をもたらします。 ただし、既存の制限を克服し、真の継続学習の目標を達成するには、テクノロジーを継続的に改善する必要があります。