ビデオ分析の分野では、長いビデオの理解が常に大きな課題でした。従来のモデルは長いビデオを処理する際に非効率であり、重要な情報を効果的に抽出することが困難でした。本稿では、HiCo と呼ばれる階層型ビデオ マークアップ圧縮技術と、この技術に基づいた「VideoChat-Flash」システムを紹介します。このシステムは、多段階学習を通じて「干し草の山の中の針」タスクを大幅に改善し、長時間ビデオの理解能力を向上させ、大幅な削減を実現します。コンピューティング要件。研究チームは、モデルのトレーニングと評価のために、30 万時間のビデオと 2 億語の注釈を含む大規模なデータセットを構築しました。

具体的には、HiCo は、長いビデオを短いセグメントに分割し、冗長な情報を圧縮することで計算の複雑さを軽減すると同時に、ユーザー クエリとのセマンティックな関連付けを活用して、処理されるタグの数をさらに削減します。 「VideoChat-Flash」は多段階の学習スキームを採用しており、最初は教師付き微調整に短いビデオを使用し、次に徐々に長いビデオトレーニングを導入し、最終的に混合長コーパスの包括的な理解を達成します。 さらに、改善された「干し草の山の中の針」タスクにより、コンテキストとマルチホップ ビデオ構成に対するモデルの理解が向上しました。

「VideoChat-Flash」では、長尺動画処理の具体的な実装において、短尺動画から長尺動画への多段階学習方式を採用しています。研究者らはまず、教師付き微調整に短いビデオとそれに対応する注釈を使用し、次にトレーニング用に徐々に長いビデオを導入し、最終的に混合長コーパスの包括的な理解を達成しました。この方法は、モデルの視覚認識能力を向上させるだけでなく、長時間のビデオ処理のための豊富なデータ サポートも提供します。研究チームは、30 万時間のビデオと 2 億語の注釈を含む巨大なデータ セットを構築しました。

さらに、マルチホップビデオ構成の研究では、改良された「干し草の山の中の針」タスクが提案されています。新しいベンチマークでは、モデルはビデオ内の単一のターゲット画像を見つける必要があるだけでなく、相互に関連する複数の画像シーケンスを理解する必要があるため、コンテキストを理解するモデルの能力が向上します。

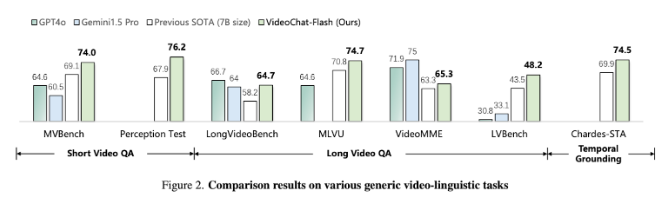

実験結果は、提案された方法が計算量を 2 桁削減し、特に短いビデオと長いビデオのベンチマーク テストで優れたパフォーマンスを示し、短いビデオ理解の新しい分野のリーダーとなることを示しています。同時に、このモデルは長時間ビデオの理解において既存のオープンソース モデルを上回り、強力な時間測位機能を示しています。

論文: https://arxiv.org/abs/2501.00574

ハイライト:

研究者らは、長時間のビデオ処理に必要な計算量を大幅に削減する階層型ビデオタグ圧縮技術 HiCo を提案しました。

「VideoChat-Flash」システムは多段階学習方式を採用し、短いビデオと長いビデオを組み合わせてトレーニングすることで、モデルの理解力を向上させます。

実験結果は、この方法が複数のベンチマーク テストで新しい性能基準に達し、長時間ビデオ処理の分野で先進的なモデルになることを示しています。

全体として、この研究は、長時間ビデオを効率的に理解するための新しいソリューションを提供し、計算効率とモデルのパフォーマンスに大きな進歩をもたらし、将来の長時間ビデオ分析アプリケーションの基礎を築きました。 研究結果は重要な理論的意義と実用的価値を持っています。