浙江大学とアリババ ダモ アカデミーは共同で、教育ビデオを使用して高品質のマルチモーダル教科書データ セットを構築するという画期的な研究を開始しました。この研究は、既存の大規模言語モデル (VLM) の事前トレーニング データの知識密度の低さと画像とテキストの相関性の弱さの問題を解決し、VLM のためにより良いトレーニング教材を提供し、教育リソースの使用を革新することを目的としています。研究チームは大量の教育ビデオを収集して処理し、最終的に複数の分野をカバーする総再生時間 22,000 時間を超える高品質のデータセットを構築し、教育分野における人工知能の応用に新たな可能性をもたらしました。

最近、浙江大学とアリババ大模学院は、教育ビデオを通じて高品質のマルチモーダル教科書を作成することを目的とした目を引く研究を共同発表した。この革新的な研究結果は、大規模言語モデル (VLM) のトレーニングに新しいアイデアを提供するだけでなく、教育リソースの利用方法を変える可能性があります。

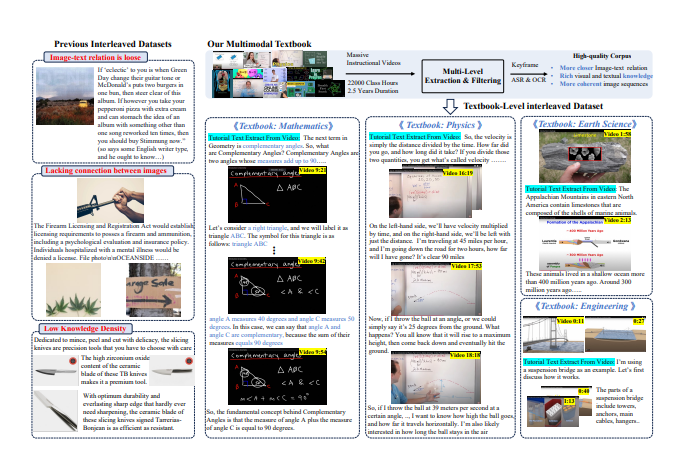

人工知能技術の急速な発展に伴い、VLM の事前トレーニング コーパスは主に画像とテキストのデータおよび画像とテキストが絡み合ったコーパスに依存しています。しかし、現在のデータのほとんどは Web ページからのものであり、テキストと画像の相関性は弱く、知識密度は比較的低いため、複雑な視覚的推論を効果的にサポートすることができません。

この課題に対処するために、研究チームはインターネット上の多数の教育ビデオから高品質の知識コーパスを抽出することにしました。 159,000 を超える教育ビデオを収集し、慎重なフィルタリングと処理を経て、最終的に数学、物理学、化学などの複数の主題をカバーする合計 22,000 時間以上の高品質ビデオ 75,000 を保持しました。

研究者らは、複雑な「ビデオから教科書へ」処理パイプラインを設計しました。まず、自動音声認識(ASR)技術を利用して動画内の説明内容をテキストに変換し、画像解析とテキストマッチングによりナレッジポイントとの関連性が高いクリップを選別します。最後に、これらの処理されたキーフレーム、OCR テキスト、転写されたテキストがインターリーブされて編成され、豊富なコンテンツと厳密な構造を備えたマルチモーダルな教科書が形成されます。

この研究の予備的な結果は、以前の Web 中心のデータセットと比較して、新しく生成された教科書データセットは知識密度と画像相関が大幅に向上し、VLM の学習により強固な基盤を提供することを示しています。さらに、この研究は学術コミュニティからの幅広い注目を集め、関連データセットはすぐに Hugging Face プラットフォームの人気リストのトップに上り詰め、わずか 2 週間で 7,000 以上ダウンロードされました。

この革新的な試みを通じて、研究者らは VLM の開発を促進するだけでなく、教育リソースの統合と応用における新たな可能性を切り開くことを望んでいます。

論文アドレス: https://arxiv.org/pdf/2501.00958

この研究結果は、人工知能の分野にとって非常に重要なだけでなく、将来の教育モデル改革に新たな方向性を与え、教育分野における人工知能技術の広範な応用の見通しを示しています。このデータセットのオープンソースは、世界中の研究者に貴重なリソースを提供し、学術コミュニティでの協力と交流を促進します。