視覚言語モデル (VLM) はマルチモーダル タスクで重要な役割を果たしますが、否定を理解する上で重大な欠点があります。既存のモデルでは、肯定的な文と否定的な文を区別することが難しいことが多く、医療診断やセキュリティ監視など、正確な意味の理解を必要とするアプリケーションでは特に問題となります。根本的な原因は、モデルが否定的なステートメントと肯定的なステートメントを混同する原因となるトレーニング前データのバイアスです。この記事では、VLM の否定を理解する能力が不十分であるという問題を解決することを目的とした、NegBench と呼ばれる新しいフレームワークを紹介します。

視覚言語モデル (VLM) は、画像検索、画像説明、医療診断などのマルチモーダル タスクにおいて重要な役割を果たします。これらのモデルの目標は、視覚データを言語データと調整して、より効率的な情報処理を可能にすることです。ただし、現在の VLM は、否定を理解する上で依然として大きな課題に直面しています。

否定は、「窓のない部屋」と「窓のある部屋」を区別するなど、多くのアプリケーションで重要です。 VLM は大幅に進歩しましたが、否定的なステートメントを処理すると、既存のモデルのパフォーマンスが大幅に低下します。この制限は、セキュリティ監視や医療などの高リスク分野では特に重要です。

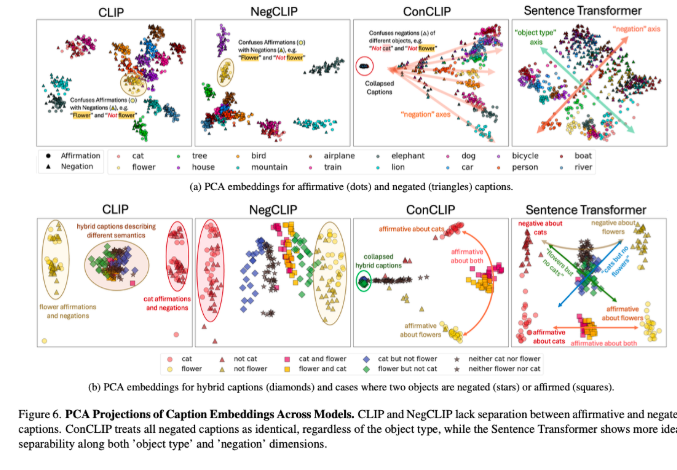

CLIP などの既存の VLM は、共有埋め込みスペースを使用して視覚的表現とテキスト表現を調整します。これらのモデルは、クロスモーダル検索や画像キャプションなどのタスクではうまく機能しますが、否定文を扱う場合は失敗します。この問題の根本は、主に肯定的な例で構成されるトレーニング前データのバイアスにあり、モデルが否定的なステートメントと肯定的なステートメントを同義語として扱う原因となります。したがって、CREPE や CC-Neg などの既存のベンチマークは、自然言語における否定の豊かさと深さを真に反映できない単純なテンプレートの例を採用しています。このため、VLM は、医療画像データベースの複雑な条件をクエリするなど、正確な言語理解アプリケーションを実行する際に大きな課題に直面することになります。

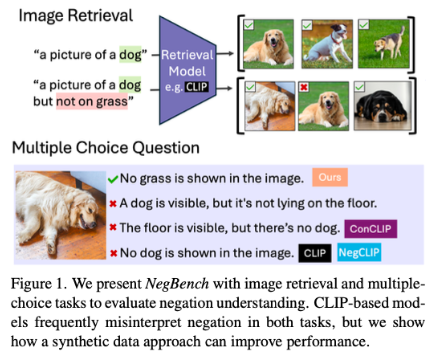

これらの問題に対処するために、MIT、Google DeepMind、およびオックスフォード大学の研究者は、VLM の否定を理解する能力を評価および改善するための NegBench フレームワークを提案しました。このフレームワークは、2 つの基本タスクを評価します。1 つは肯定的な説明と否定的な説明に基づいて画像を取得するモデルの能力をテストする検索と否定 (Retrieval-Neg)、もう 1 つは微妙な問題に関するモデルのパフォーマンスを評価する多肢選択質問と否定 (MCQ-Neg) です。理解。 NegBench は、CC12M-NegCap や CC12M-NegMCQ などの大規模な合成データセットを使用します。これらには、モデルのトレーニングと評価を向上させるための豊富なネガティブ シナリオをカバーする何百万ものタイトルが含まれています。

NegBench は、実際のデータセットと合成データセットを組み合わせることで、既存のモデルの制限を効果的に克服し、モデルのパフォーマンスと汎化機能を大幅に向上させます。微調整されたモデルでは、検索タスクと理解タスクの両方で大幅な改善が見られ、特に否定的なクエリを処理する場合に、モデルの再現率が 10% 増加しました。多肢選択タスクでは、精度が 40% も向上し、微妙な肯定的な見出しと否定的な見出しを区別する能力が大幅に向上したことがわかりました。

NegBench の提案は、否定の理解における VLM の重要なギャップを埋め、より強力な人工知能システムを構築するための道を開きます。これは、医療診断やセマンティック コンテンツ検索などの重要な分野で特に重要です。

論文: https://arxiv.org/abs/2501.09425

コード: https://github.com/m1k2zoo/negbench

ハイライト:

研究者らは、否定を理解する際の視覚言語モデルの欠点が主にトレーニング データのバイアスに起因していることを明らかにしました。

NegBench フレームワークは、豊富な否定例を導入することにより、検索および理解タスクにおけるモデルのパフォーマンスを大幅に向上させます。

微調整されたモデルが否定的なクエリを処理すると、精度と再現率が大幅に向上し、人工知能システムの進歩が促進されます。

NegBench フレームワークの出現は、否定を理解する際の視覚言語モデルの問題に対する効果的な解決策を提供します。これは、モデルのパフォーマンスを向上させ、人工知能の開発を促進する上で非常に重要であり、さらなる研究と応用に値します。