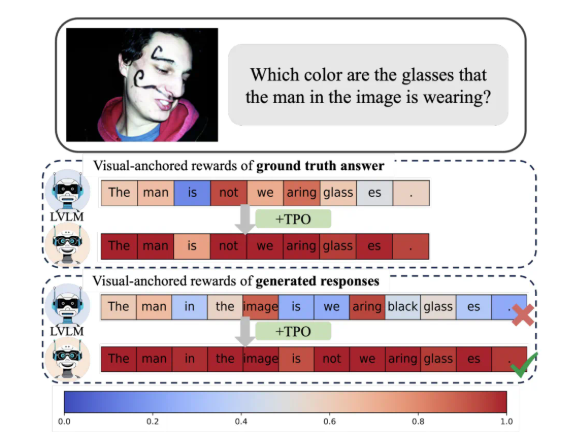

ビジュアル ラージ モデル (LVLM) は、画像理解の分野で大きな進歩を遂げてきましたが、「錯視現象」がその開発のボトルネックとなっています。この問題に対処するために、Taotian Group Future Life Laboratory チームは、自己調整された視覚的アンカリング情報依存メカニズムを導入することでモデルの視覚的影響を効果的に改善する「トークン優先最適化」(TPO) と呼ばれる新しい方法を提案しました。幻覚の可能性。 TPO の中核は、トークン レベルの報酬シグナルの生成を自動化し、面倒な手動アノテーションを回避し、視覚情報への依存を反映して各トークンに報酬を割り当て、モデルのパフォーマンスを向上させることです。

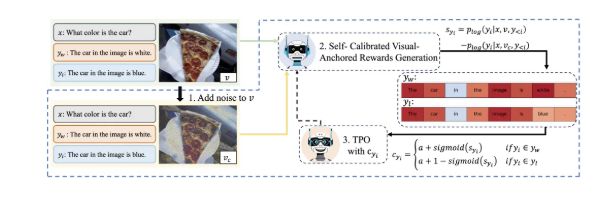

TPO の最大の革新は、自動化されたトークンレベルの報酬シグナルを実装していることです。この方法では、嗜好データ内の視覚的に固定されたトークンを自動的に識別し、面倒な手動によるきめ細かい注釈を回避しながら、トレーニング プロセス中の視覚情報への依存性を反映した報酬を各トークンに割り当てることができます。この自己調整された視覚的に固定された報酬信号は、モデルの視覚情報への依存を最適化するように設計されており、それによって幻覚の発生を効果的に軽減します。

調査によると、TPO を使用したモデルは、複数の評価ベンチマークにおいて、特により複雑なタスクにおいて、モデルによって生成される回答が言語モデルの事前知識ではなく画像情報にますます依存する場合に、従来の方法よりも大幅に優れていることが示されています。この進歩により、モデルの理解が深まるだけでなく、さらなる研究のための重要な理論的基盤も提供されます。

さらに、研究チームはTPOのさまざまなパラメータ設定でアブレーション実験も実施し、最適化されたノイズ追加ステップと報酬分配戦略がモデルのパフォーマンスをさらに向上できることを発見しました。この発見は間違いなく、大規模な視覚モデルの将来の研究と応用の方向性を示しています。

つまり、Taotian のこの革新的な成果は、マルチモーダル アライメント テクノロジーの新しいアイデアを提供し、生活と消費の分野での AI テクノロジーの徹底的な応用を促進します。

TPO 法の適用により、大規模なビジュアル モデルの「錯覚」問題が効果的に解決され、モデルの信頼性と精度が向上し、将来の大規模なビジュアル モデルの開発に新しい方向性が提供されます。このアプリケーションは、実生活における人工知能の応用に対する新たな方向性を示しており、重要な理論的意義と応用価値を備えています。この研究成果は、マルチモーダル技術の開発に新たな力をもたらします。