Mistral がリリースした最新のオープンソース コーディング モデルである Codestral 25.01 は、パフォーマンスが大幅に向上し、前世代の 2 倍の速度になりました。 Codestral のアップグレード バージョンとして、Codestral 25.01 は、その低遅延および高周波数動作特性を継承し、エンタープライズ レベルのアプリケーション向けに最適化されており、コード修正、テスト生成、中間充填などのタスクをサポートします。 Python コーディング テストでの優れたパフォーマンス、特に HumanEval テストでの 86.6% という高スコアは、多くの同様の製品を上回り、現在のヘビーウェイト コーディング モデルのリーダーとなっています。

オリジナルの Codestral と同様に、Codestral 25.01 は依然として低遅延および高頻度の操作に焦点を当てており、コード修正、テスト生成、および中間充填タスクをサポートしています。ミストラル氏によると、このバージョンは、より多くのデータとモデルの常駐を必要とする企業に特に適しているという。ベンチマーク テストでは、Codestral25.01 が Python コーディング テストで予想を上回るパフォーマンスを示し、HumanEval テスト スコアが 86.6% で、以前のバージョンである Codellama70B 命令および DeepSeek Coder33B 命令をはるかに上回っています。

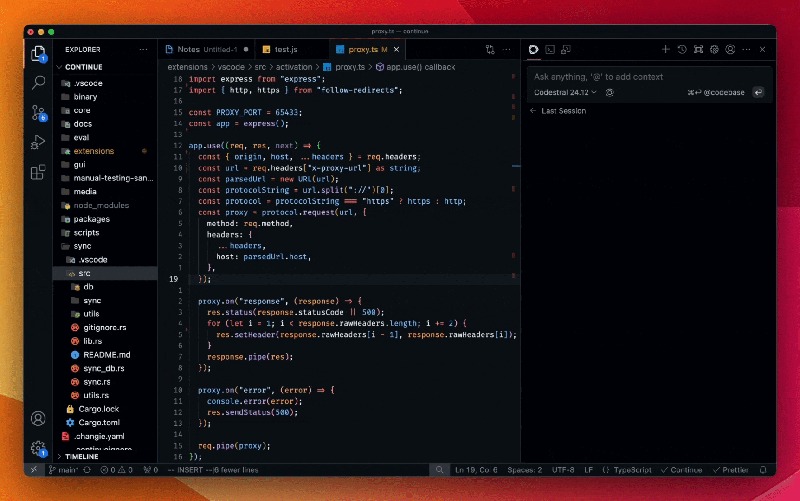

開発者は、Mistral IDE プラグインおよびローカル デプロイメント ツール Continue を通じてモデルにアクセスできます。さらに、Mistral は、Google Vertex AI および Mistral la Plateforme を通じて API へのアクセスも提供します。このモデルは現在、Azure AI Foundry でプレビュー版として利用可能ですが、間もなく Amazon Bedrock プラットフォームでも利用できるようになる予定です。

昨年のリリース以来、Mistral の Codestral は、コードに重点を置いたオープンソース モデルのリーダーとなっています。 Codestral の最初のバージョンは、最大 80 言語をサポートする 22B パラメータ モデルで、多くの同様の製品よりも優れたコーディング パフォーマンスを備えています。その直後、Mistral は、より長いコード文字列を処理し、より多くの入力要件に対応できる、Mamba アーキテクチャに基づくコード生成モデルである Codestral-Mamba を発表しました。

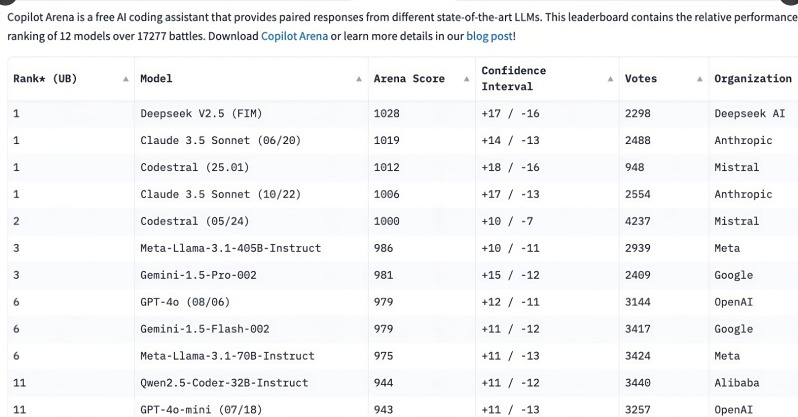

Codestral 25.01 のリリースは開発者から広く注目を集め、リリースからわずか数時間で C o パイロット アリーナ ランキングのトップにランクされました。この傾向は、特にコーディング タスクの分野では、特化されたコーディング モデルが開発者にとって急速に第一の選択肢になりつつあることを示しており、多機能の一般的なモデルと比較して、焦点を絞ったコーディング モデルの必要性がますます明らかになってきています。

OpenAI の o3 や Anthropic の Claude などの汎用モデルもエンコードできますが、特別に最適化されたエンコード モデルの方がパフォーマンスが向上する傾向があります。過去 1 年間で、アリババの Qwen2.5-Coder や中国の DeepSeek Coder など、複数の企業がコーディング専用モデルをリリースしました。後者は GPT-4Turbo を超える最初のモデルとなりました。さらに、Microsoft は、専門家混合モデル (MOE) に基づいて、コーディングだけでなく数学的問題も解決できる GRIN-MoE を立ち上げました。

開発者は汎用モデルを選択するか専用モデルを選択するかをまだ議論していますが、コーディング モデルの急速な台頭により、効率的で正確なコーディング ツールに対する大きなニーズが明らかになりました。 Codestral25.01 は、コーディング タスク用に特別に訓練されているという利点があるため、間違いなくコーディングの将来に重要な役割を果たします。

Codestral25.01 のリリースは、プロフェッショナルなコーディング モデルの分野で新たな一歩を踏み出しました。その優れたパフォーマンスと便利なアクセスにより、開発者はより効率的なコーディング体験を実現し、ソフトウェア開発分野における人工知能のさらなる開発を促進します。将来的には、より多くの同様のプロフェッショナル モデルが登場し、開発者により多くの選択肢が提供されることを期待しています。