この記事では、MicrosoftがTongji Universityと協力して開発されたLLM2CLIPメソッドを紹介します。これは、クリップモデルの視覚エンコーダーパフォーマンスを改善し、長く複雑なテキストの説明を処理する際の制限を解決することを目的としています。 LLM2Clipは、大規模な言語モデル(LLM)を統合し、「タイトルコントラスト微調整」テクノロジーを導入することにより、画像とテキストを一致させるモデルの能力を大幅に向上させます。複数のデータセットでのこのメソッドの実験結果は、画像からテキスト、テキストから画像への検索タスク、特に長くて短いテキスト検索タスクで、従来のクリップモデルとEVAモデルを上回り、強力な言語処理を示すことを示しています。能力。

今日の科学技術分野では、クリップ(コントラスト言語イメージの事前トレーニング)は、重要なマルチモーダル基本モデルです。大規模な画像テキストペアのコントラスト学習損失を使用して、視覚とテキストの信号を共有機能空間に組み合わせます。

検索者として、Clipは、ゼロショット分類、検出、セグメンテーション、画像テキスト取得などのさまざまなタスクをサポートできます。一方、特徴抽出器として、画像の理解、ビデオ理解、テキストから画像やビデオ生成など、ほぼすべてのクロスモーダル表現タスクを支配します。クリップの強力なのは、詳細なテキストの説明を含む大規模なネットワークデータに関するトレーニングのおかげで、画像を自然言語に接続して人間の知識を捉える能力です。

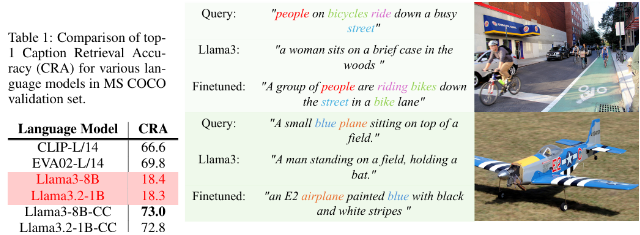

ただし、Clipには、長く複雑なテキストの説明を処理する際に特定の制限があります。この問題を克服するために、MicrosoftとTongji Universityの研究者は、LLM2CLIPメソッドを提案し、大規模な言語モデル(LLM)を統合することにより視覚表現学習を強化することを目指しています。このメソッドは、元のクリップテキストエンコーダーを大胆に置き換え、LLMSの豊富な知識を使用して、クリップの視覚エンコーダーパフォーマンスを改善します。この研究では、LLMSをクリップに直接統合するとパフォーマンスの劣化が生じることがわかったため、この課題に対処する必要があります。

LLM2CLIPメソッドは、「タイトルコントラストの微調整」テクノロジーを導入することにより、画像タイトルを分離するLLMの能力を大幅に改善し、パフォーマンスの大幅な改善を達成します。

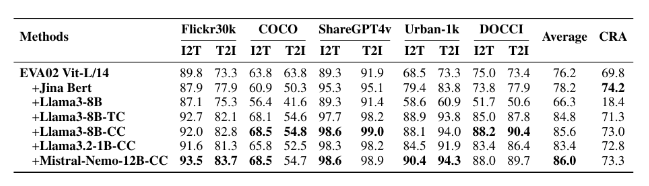

研究者は、小さなCC-3M、中CC-3M、CC-12M、大型CC-3M、CC-12M、YFCC-15M、Recaption-1Bなど、微調整実験に異なるサイズのデータセットを使用しました。結果は、LLM2Clipを使用して訓練されたモデルが、画像からテキストへのテキストからテキスト間検索タスクで、従来のクリップモデルやEVAモデルよりも優れたパフォーマンスを発揮することを示しています。

マルチモーダルトレーニングをLLAVA 1.5などのモデルと組み合わせることにより、LLM2CLIPはほとんどすべてのベンチマークでうまく機能しました。特に、長くて短いテキスト検索タスクを扱う場合、以前のEVA02モデルのパフォーマンスを16.5%改善しました。この革新的なアプローチは、クリップを単純に英語データの処理から強力な言語モデルに変換するだけでなく、クリップトレーニングに関する将来の研究の基礎を築きます。

モデル:https://huggingface.co/collections/microsoft/llm2clip-672323a266173cfa40b32d4c

コード:https://github.com/microsoft/llm2clip/

論文:https://arxiv.org/abs/2411.04997

ポイント:

LLM2Clipは、MicrosoftおよびTongji UniversityがTongji Universityと協力して提案した革新的なアプローチであり、Clipのテキストエンコーダーを置き換えることで視覚エンコーダーのパフォーマンスを向上させることを目指しています。

この方法は、既存の最先端モデルを上回る「タイトルコントラストの微調整」技術を介して、画像とテキストを一致させるモデルの能力を大幅に向上させます。

複数のデータセットでのLLM2Clipの実験は、長いテキストおよび短いテキスト検索タスクで従来のモデルよりも優れたパフォーマンスを発揮し、言語間モデルの開発を促進することを示しています。

要するに、LLM2CLIPメソッドは、クリップモデルの改善のための新しいアイデアを提供します。関連するリソースリンクは、読者が学び、研究するのに便利です。