IflytekのIflytekのマルチモーダル相互作用モデルの発売は、人工知能の分野での新しいマイルストーンをマークします。このモデルは、過去の単一の音声相互作用の制限を突破し、音声、視覚、デジタルの人間の相互作用機能のワンクリックシームレスな統合を実現し、ユーザーがより鮮明で、より現実的で、より便利なインタラクティブなエクスペリエンスをもたらします。その超人類のデジタルヒューマンテクノロジーは、音声コンテンツを正確に一致させて表現とアクションを生成し、超人道的相互作用をサポートし、指示に従ってサウンドパラメーターを調整し、パーソナライズされたサービスを提供します。マルチモーダルの視覚相互作用関数は、モデルに「世界を理解し、すべてを認識する」能力を与え、環境情報を正確に認識し、より適切な応答を行う能力を与えます。

Iflytekのマルチモーダル相互作用モデルの発売は、Multi-Modal Interaction TechnologyにおけるIflytekの主要な位置を反映するだけでなく、人工知能アプリケーションの将来の開発方向性に関する新しいアイデアも提供します。複数のインタラクション方法を統合することにより、このモデルはユーザーのニーズをよりよく理解し、より正確でより豊富なサービスを提供できます。また、オープンSDKは、マルチモーダル人工知能技術の普及と応用を促進する可能性を開発者に提供します。将来的には、このモデルに基づいてより革新的なアプリケーションが期待でき、人々の生活効率と経験の質をさらに向上させることができます。

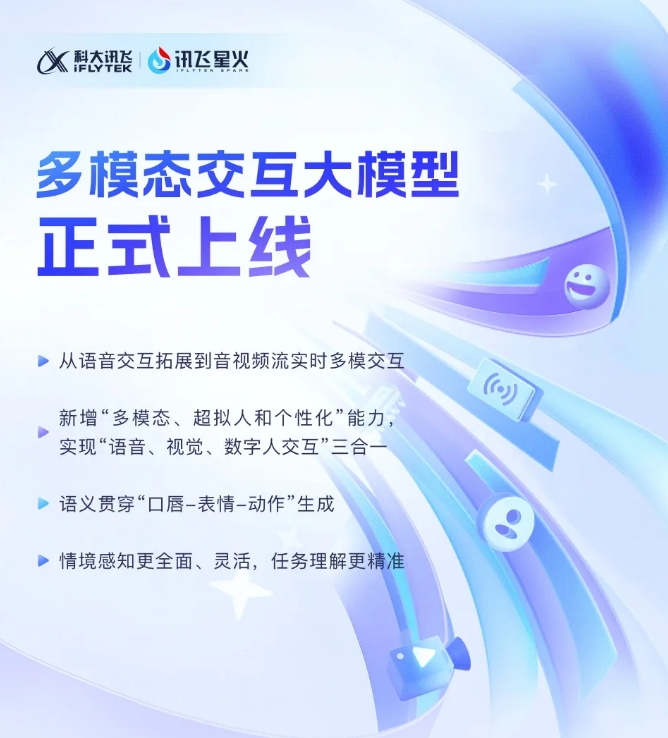

Iflytekは最近、Iflytekマルチモーダル相互作用モデルの最新の開発が正式に稼働したことを発表しました。この技術的ブレークスルーは、単一の音声インタラクションテクノロジーから、オーディオおよびビデオストリームのリアルタイムマルチモーダルインタラクションの新しい段階へのIflytekの拡張の新しい段階を示しています。新しいモデルは、音声、視覚、デジタルの人間の相互作用関数を統合し、ユーザーは3つのクリックコールのシームレスな組み合わせを実現できます。

Iflytek Multimodal Interactionモデルの発売により、このテクノロジーは、デジタルヒトの胴体と手足の動きと音声の内容を正確に一致させ、AIの鮮やかなものを大幅に改善することができます。本物。テキスト、スピーチ、表現を統合することにより、新しいモデルはクロスモーダルのセマンティックの一貫性を実現し、感情的な表現をより現実的で一貫性のあるものにします。

さらに、Iflytek Sparkは、統一されたニューラルネットワークを使用して音声から音声へのエンドツーエンドモデリングを直接実現し、応答速度をより速く滑らかにするために、超人類の超高速相互作用テクノロジーをサポートしています。このテクノロジーは、感情的な変化を鋭く認識し、指示に従って音のリズム、サイズ、性格を自由に調整し、よりパーソナライズされたインタラクティブな体験を提供します。

マルチモーダルの視覚的相互作用に関しては、Iflytek Sparkは「世界を理解」し、「すべてを認識する」ことができ、特定の背景シーン、ロジスティクスステータス、その他の情報を完全に認識し、タスクの理解をより正確にします。音声、ジェスチャー、行動、感情などのさまざまな情報を統合することにより、モデルは適切な応答を行い、ユーザーにより豊かで正確なインタラクティブなエクスペリエンスを提供できます。

マルチモーダルインタラクションビッグモデルSDK:https://www.xfyun.cn/solutions/multimodel

要するに、Iflytekマルチモーダルインタラクションモデルは、人工知能技術が開発の新しい段階に入っていることを示しています。 Iflytek Sparkを楽しみにして、将来、より多くの驚きがもたらされます。