Sakana AIは、高価な微調整なしで推論プロセス中に新しいタスクを動的に学習および適応するユニークな2段階の動的重量調整メカニズムを使用する革新的な適応言語モデルTransformer²を発売します。これは、大規模な言語モデル(LLM)テクノロジーの主要なブレークスルーであり、LLMの適用方法を変更して、より効率的でパーソナライズされ、実用的にすることが期待されています。従来の微調整方法と比較して、Transformer²は、特異値分解(SVD)と特異値の微調整(SVF)技術を通じてモデル重量の主要なコンポーネントを選択的に調整し、リアルタイムでパフォーマンスを最適化し、時間をかける再訓練を避けます。テストの結果は、変圧器が複数のタスクでLORAモデルよりも優れており、パラメーターが少なく、強力な知識転送能力も示していることを示しています。

Transformer²のコアイノベーションは、独自の2段階の動的重量調整メカニズムにあります。まず、受信ユーザーの要求を分析し、タスク要件を理解します。モデル重量の主要なコンポーネントを選択的に調整することにより、Transformer²により、時間のかかる再訓練なしにパフォーマンスのリアルタイム最適化が可能になります。これは、トレーニング後にパラメーターを静的に保つか、少数のパラメーターのみを変更するために低ランク適応(LORA)などの方法を使用する必要がある従来の微調整方法とは対照的です。

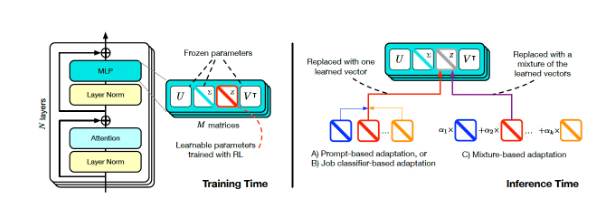

トランススクエアトレーニングと推論(出典:ARXIV)

動的調整を実現するために、研究者は単一値の微調整(SVF)メソッドを採用しました。トレーニング中、SVFはモデルのSVDコンポーネントからZベクターと呼ばれるスキル表現のセットを学習します。推論するとき、Transformer²は、プロンプトを分析し、対応するZベクターを構成して各プロンプトに合わせた応答を実現することにより、必要なスキルを決定します。

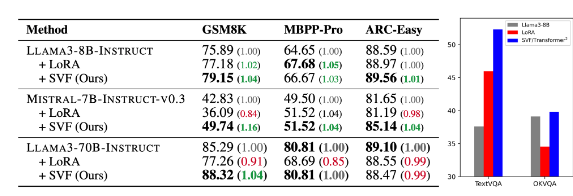

テスト結果は、変圧器²が数学、コーディング、推論、視覚的な質問や回答などのさまざまなタスクでLORAモデルよりも優れており、パラメーターが少ないことを示しています。さらに注目に値するのは、モデルにも知識転送能力があること、つまり、あるモデルから学習したZベクターを別のモデルに適用できるため、広範なアプリケーションの可能性を示していることです。

基礎モデルとLORA(出典:ARXIV)とのトランス2乗(表のSVF)の比較

Sakana AIは、GitHubページでTransformer²コンポーネントのトレーニングコードをリリースし、他の研究者や開発者のための扉を開きました。

企業がLLMの適用を調査し続けるにつれて、推論カスタマイズテクノロジーは徐々に主流の傾向になりつつあります。 Transformer²は、GoogleのTitansなどの他のテクノロジーとともに、LLMの使用方法を変えており、ユーザーは再訓練なしに特定のニーズにモデルを動的に調整できるようにしています。この技術の進歩により、LLMはより広範な分野でより有用で実用的になります。

Sakana AIの研究者は、Transformer²は静的な人工知能とライフインテリジェンスの間の橋を代表しており、効率的でパーソナライズされ、完全に統合されたAIツールの基礎を築いていると述べました。

Transformer²のオープンソースリリースは、LLMテクノロジーの開発と応用を大幅に促進し、より効率的でパーソナライズされた人工知能システムを構築するための新しい方向性を提供します。動的に学習し、新しいタスクに適応する能力により、さまざまな分野で大きなアプリケーションの可能性があり、将来の開発を楽しみにしています。