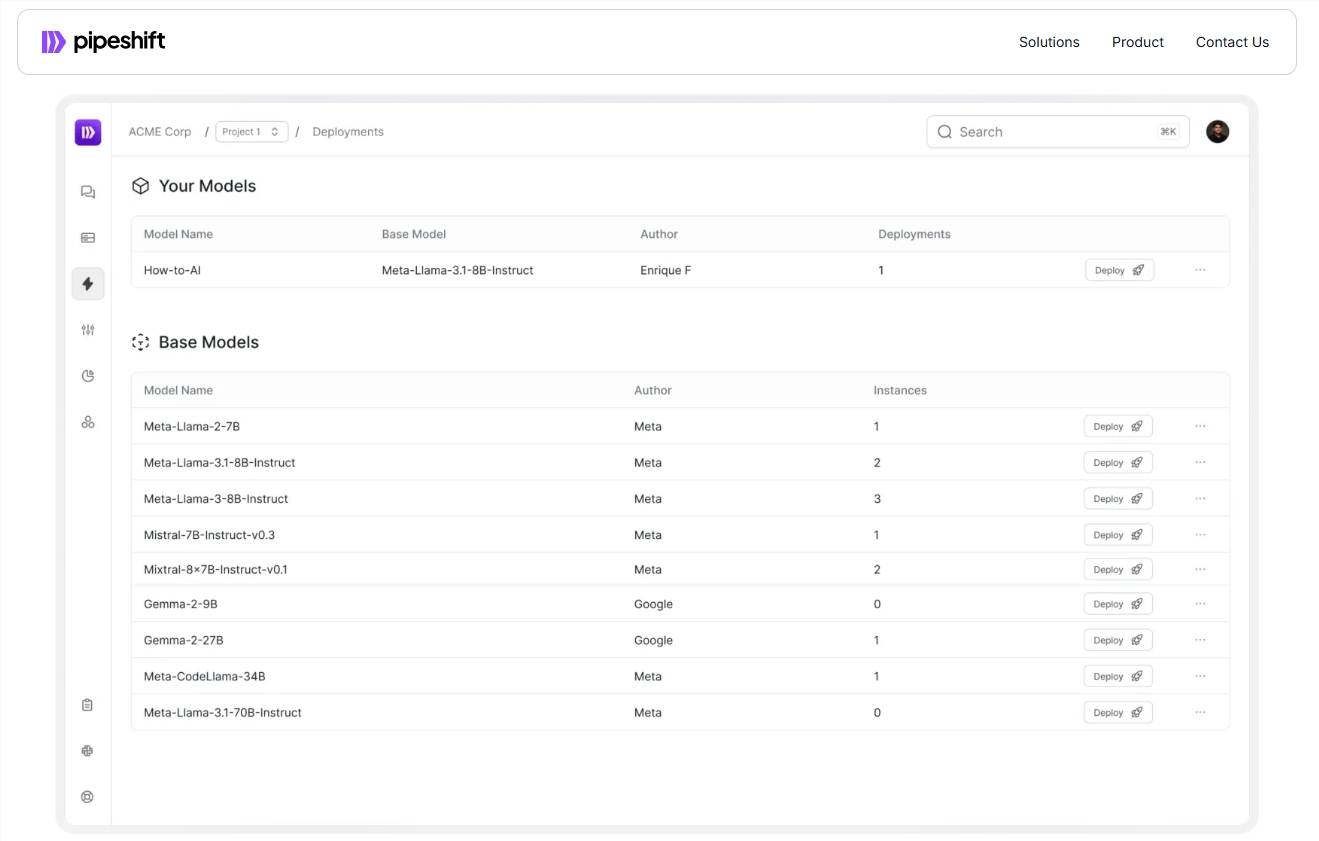

Startup Pipeshiftは、企業がオープンソースの生成AIモデルをより効率的にトレーニング、展開、拡張するのに役立つように設計された新しいエンドツーエンドプラットフォームを立ち上げました。このプラットフォームは、さまざまなクラウド環境とオンプレミスGPUと互換性があり、推論の速度を大幅に改善し、コストを削減し、企業による複数のモデル間の効率的な切り替えの問題を解決します。モジュラー推論エンジンマジックフレームワークを採用しています。これにより、異なる推論コンポーネントの柔軟な組み合わせが可能になり、退屈なエンジニアリング作業なしで推論パフォーマンスを最適化できます。 これは間違いなく、AIモデルの展開と管理に課題に直面している企業にとって大きな利点です。

最近、Startup Pipeshiftは、エンタープライズがオープンソースの生成AIモデルをより効率的にトレーニング、展開、拡張するのを支援するように設計された新しいエンドツーエンドプラットフォームを立ち上げました。このプラットフォームは、クラウド環境やオンプレミスGPUで実行されるだけでなく、推論速度を大幅に改善し、コストを削減します。

AIテクノロジーの急速な発展により、多くの企業は、複数のモデルを効率的に切り替える方法の課題に直面しています。従来、チームは、コンピューティングリソースの取得、モデルトレーニング、微調整、および生産レベルの展開などの複数のリンクを含む複雑なMLOPSシステムを構築する必要があります。インフラストラクチャ管理に。

Pipeshiftの共同設立者兼CEOであるArko Chattopadhyayは、柔軟なモジュール式推論エンジンの開発には長年の経験が必要であり、Pipeshiftのソリューションはモジュール式推論エンジンでこのプロセスを簡素化するように設計されていることに気付きました。このプラットフォームは、MAGIC(GPU Inference Cluster Modular Architecture)と呼ばれるフレームワークを採用しています。これにより、チームは特定のワークロード要件に応じて異なる推論コンポーネントを柔軟に組み合わせることができ、それにより、面倒なエンジニアリングを必要とせずに推論パフォーマンスを最適化できます。

たとえば、Pipeshiftプラットフォームを使用した後、Fortune 500の小売会社は、元々1つのGPUインスタンスに実行するために4つの独立したGPUインスタンスを必要とした4つのモデルを統合します。このようにして、同社は推論速度が5倍の増加を達成しただけでなく、インフラストラクチャコストを60%削減しました。この成果により、企業は急速に成長している市場で競争力を維持することができます。

Pipeshiftは、30社との年間ライセンス契約に到達し、チームが将来データセットを構築および拡大するのを支援するツールを開始する予定です。これにより、実験およびデータの準備プロセスがさらに加速し、顧客の生産性が向上します。

公式入り口:https://pipeshift.com/

ポイント:

Pipeshiftのモジュラー推論エンジンは、AI推論のGPU使用量を大幅に削減し、コストを最大60%削減できます。

マジックフレームワークを通じて、企業は推論コンポーネントを迅速に組み合わせ、推論速度を向上させ、エンジニアリングの負担を軽減できます。

Pipeshiftはいくつかの企業と提携しており、将来、より多くのツールを発売して、企業がAIワークロードをより効率的に管理できるようにします。

Pipeshiftプラットフォームは、効率的で柔軟性があり、費用対効果の高い特性を備えているため、AIモデルの展開と管理を簡素化するための効果的なソリューションを企業に提供します。その将来の開発と新しいツールの立ち上げも、楽しみにしています。