Hugging Faceは、サイズが小さく、携帯電話などの小さなデバイスで実行できる見事な軽量の視覚言語モデルSmolvlmをリリースしましたが、そのパフォーマンスは300倍のIDEFICS80Bモデルを超えています。この画期的な進捗状況は、より広くて低コストの展開時代に向けてAIアプリケーションの進歩を示し、企業に多くのコンピューティングコストを節約し、処理効率を向上させます。 Smolvlmの出現は、中小企業やスタートアップがより低いコストで複雑なコンピュータービジョンアプリケーションを迅速に開発するための前例のない機会を提供します。

抱きしめる顔は、驚くべきAIモデル-Smolvlmを発売しました。この視覚言語モデルは、携帯電話などの小さなデバイスで実行し、大規模なデータセンターからのサポートを必要とする前任者を上回るのに十分なほど小さいです。

SmolVLM-256MモデルのGPUメモリ要件は1GB未満ですが、そのパフォーマンスは前身のIDEFICS80Bモデルを超えており、そのサイズよりも300倍大きく、実際のAI展開の大きな進歩を示しています。

Hugging Faceの機械学習研究エンジニアであるAndres Malafiottiによると、Smolvlmモデルは、市場に導入されている間、企業に大幅なコンピューティングコスト削減をもたらしています。 「私たちが以前にリリースしたIDEFICS80Bは、2023年8月に最初のオープンソースビデオ言語モデルでしたが、Smolvlmの発売により、Malafiotiは300倍の削減を達成しました。」

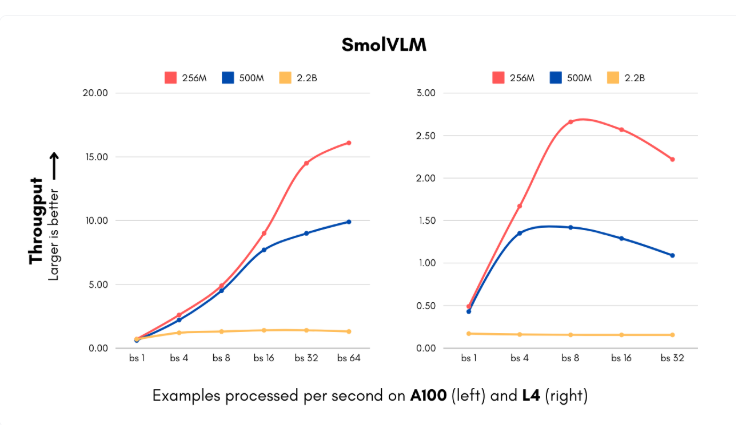

SMOLVLMモデルの発売は、企業がAIシステムの実装において高いコンピューティングコストに直面している重要な瞬間と一致します。新しいモデルには、256mと500mの2つのパラメータースケールが含まれているため、以前は考えられなかった速度で画像と視覚コンテンツを処理できます。最小バージョンは1秒あたり最大16インスタンスを処理でき、15GBのメモリのみを必要とするため、大量の視覚データを処理する必要がある企業に特に適しています。月に100万枚の写真を処理する中規模企業の場合、これはかなりの年間計算コスト削減を意味します。

さらに、IBMは、256mモデルをドキュメント処理ソフトウェアドキュングに統合するために、Faceを抱きしめることとのパートナーシップにも到達しています。 IBMには豊富なコンピューティングリソースがありますが、より小さなモデルを使用すると、数百万のファイルを低コストで処理するのが効率的になります。

抱きしめるフェイスチームは、視覚処理と言語コンポーネントの技術革新を通じてパフォーマンスを失うことなく、モデルサイズをうまく縮小しました。元の400mパラメータービジュアルエンコーダーを93mパラメーターバージョンに置き換え、より積極的なトークン圧縮技術を実装しました。これらの革新により、中小企業やスタートアップは短期間で複雑なコンピュータービジョン製品を発売することができ、インフラストラクチャのコストは大幅に削減されます。

Smolvlmのトレーニングデータセットには1億7000万のトレーニングの例が含まれており、その半分はドキュメント処理と画像注釈に使用されています。これらの開発は、コストを削減するだけでなく、企業に新しいアプリケーションの可能性をもたらし、視覚検索の能力を前例のないレベルに増やします。

顔を抱きしめることによるこの進歩は、モデルのサイズと能力の関係についての伝統的な認識に挑戦します。 Smolvlmは、小規模で効率的なアーキテクチャも優れたパフォーマンスを達成できることを証明しています。

モデル:https://huggingface.co/blog/smolervlm

ポイント:

顔を抱きしめることで起動されたSmolvlmモデルは、携帯電話で実行でき、IDEFICS80Bモデルの300倍以上のパフォーマンスがあります。

SMOLVLMモデルは、企業がコンピューティングコストを大幅に削減するのに役立ち、1秒あたり16インスタンスの処理速度を処理します。

このモデルの技術革新により、中小企業やスタートアップは短時間で複雑なコンピュータービジョン製品を立ち上げることができます。

Smolvlmの出現は、AIアプリケーションがより一般的になることを示しており、中小企業と個々の開発者は、より多くの分野で人工知能の革新と開発を促進するために強力なAIテクノロジーを簡単に利用できることを示しています。その軽量で高性能の特性は、間違いなく人工知能モデルの理解を変え、AIテクノロジーの将来の開発方向のための新しい道を指摘します。