Salesforce AI Researchチームは、成長するビデオデータを効率的に処理することを目指して、最新のマルチモーダル言語モデルであるBlip-3-Videoをリリースしました。従来のビデオ理解モデルは、革新的なタイミングエンコーダーを介してビデオ情報を16〜32の視覚マーカーに圧縮し、高精度を維持しながらコンピューティング効率を大幅に改善します。この動きは、長いビデオを扱う問題を解決し、自律運転やエンターテイメントなどの業界により強力なビデオ理解機能を提供します。

最近、Salesforce AI Researchチームは、新しいマルチモーダル言語モデルであるBlip-3-Videoを立ち上げました。ビデオコンテンツの急速な増加に伴い、ビデオデータを効率的に処理する方法が緊急の問題になりました。このモデルの出現は、ビデオ理解の効率と有効性を改善するように設計されており、自律的な運転からエンターテイメントまでの業界に適しています。

従来のビデオ理解モデルは、多くの場合、フレームごとにビデオフレームを処理し、大量の視覚情報を生成します。このプロセスは、多くのコンピューティングリソースを消費するだけでなく、長いビデオを処理する能力も大幅に制限します。ビデオデータの量が増え続けるにつれて、このアプローチはますます非効率的になるため、コンピューティングの負担を軽減しながらビデオの重要な情報をキャプチャするソリューションを見つけることが重要です。

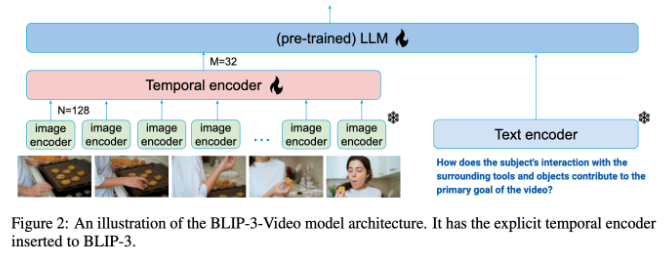

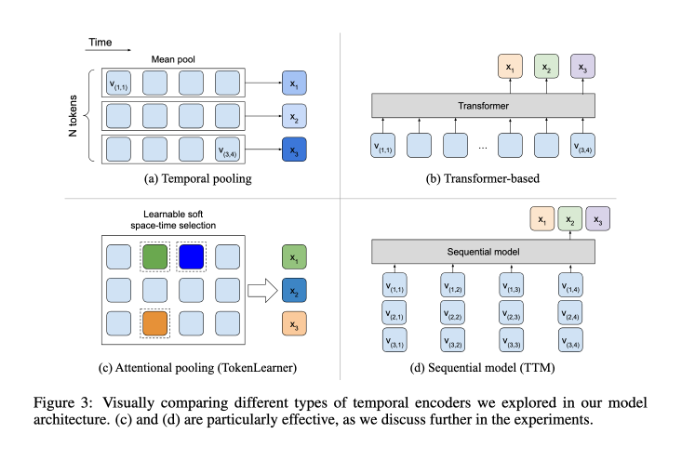

この点で、Blip-3-Videoは非常にうまく機能しました。 「タイムシーケンスエンコーダー」を導入することにより、モデルはビデオで必要な視覚情報の量を16〜32の視覚マーカーに縮小しました。この革新的な設計により、コンピューティング効率が大幅に向上し、モデルが低コストで複雑なビデオタスクを完了することができます。このタイミングエンコーダーは、各フレームから最も重要な情報を抽出し、コンパクトな視覚マーカーに統合する学習可能な空間的注意プールメカニズムを使用します。

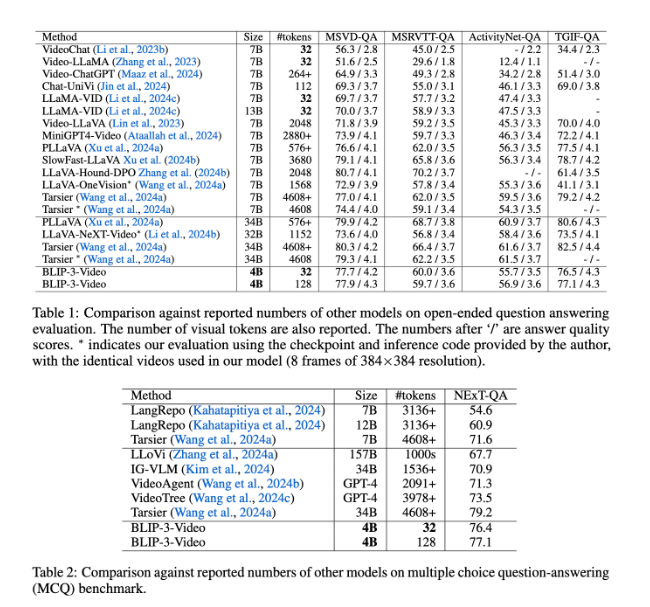

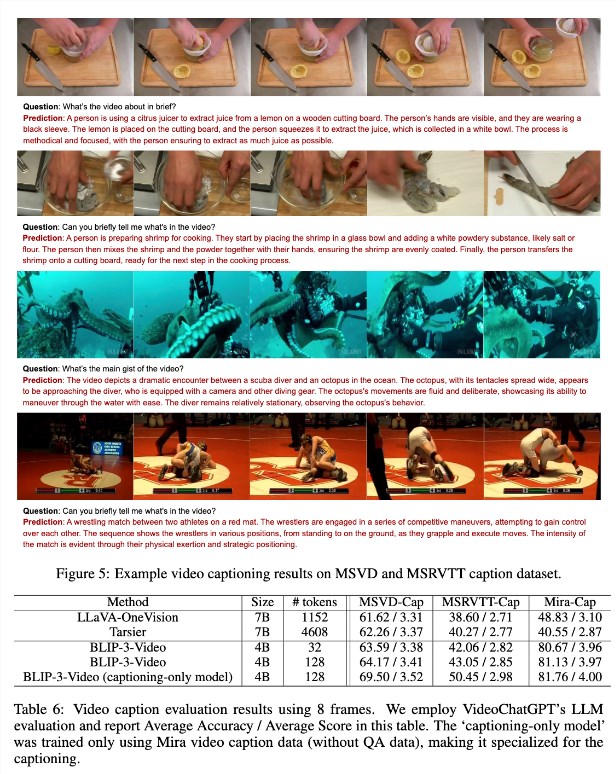

Blip-3-Videoも非常にうまく機能しました。他の大規模なモデルとの比較を通じて、この調査では、モデルにはビデオQ&Aタスクの同等のトップモデルの精度があることがわかりました。たとえば、TARSIER-34Bモデルでは、8フレームのビデオを処理するために4608マークが必要ですが、Blip-3-Videoは77.7%MSVD-QAベンチマークスコアを達成するために32マークしか必要ありません。これは、BLIP-3ビデオが高性能を維持しながらリソースの消費を大幅に削減することを示しています。

さらに、複数選択の質問と回答のタスクにおけるBLIP-3-Videoのパフォーマンスは過小評価されるべきではありません。次のQAデータセットでは、モデルは77.1%の高いスコアを達成しましたが、TGIF-QAデータセットでは77.1%の精度率も達成されました。これらすべてのデータは、複雑なビデオの問題を扱う際のBLIP-3ビデオの効率を示しています。

Blip-3-Videoは、革新的なタイミングエンコーダーを通じてビデオ処理の分野で新しい可能性を開きます。このモデルの発売は、ビデオ理解の効率を改善するだけでなく、将来のビデオアプリケーションの可能性を提供します。

プロジェクトの入り口:https://www.salesforceairesearch.com/opensource/xgen-mm-vid/index.html

キーポイント:

- **新しいモデルリリース**:Salesforce AI Researchは、ビデオ処理に焦点を当てたマルチモーダル言語モデルであるBlip-3-Videoを立ち上げます。

- **効率的な処理**:タイミングエンコーダーを使用すると、必要な視覚マークの数が大幅に削減され、コンピューティング効率が大幅に向上します。

- **優れたパフォーマンス**:ビデオQ&Aタスクの優れたパフォーマンスは、リソースの消費を削減しながら高精度を維持します。

要するに、Blip-3-Videoは、効率的な処理能力と優れたパフォーマンスにより、ビデオ理解の分野に大きな進歩をもたらしました。アプリケーションの見通しは広範です。 このモデルのオープンソースは、さらなる研究と応用のための優れた基盤も提供します。