人工知能の分野では、大規模な言語モデル(LLM)の効果的な評価が重要です。ただし、従来の評価方法は、多くの場合、実用的なアプリケーションのニーズを満たすことが難しいと感じています。この問題に対処するために、Hugging FaceはLightevalと呼ばれる軽量AI評価スイートを発売しました。 Lightevalは、企業や研究者がLLMをより簡単かつ効果的に評価し、モデルの正確性を確保し、ビジネス目標に準拠することを目的としています。複数のデバイスとカスタム評価プロセスをサポートし、他の抱擁フェイスツールとシームレスに統合して、AI開発の完全なプロセスを提供します。

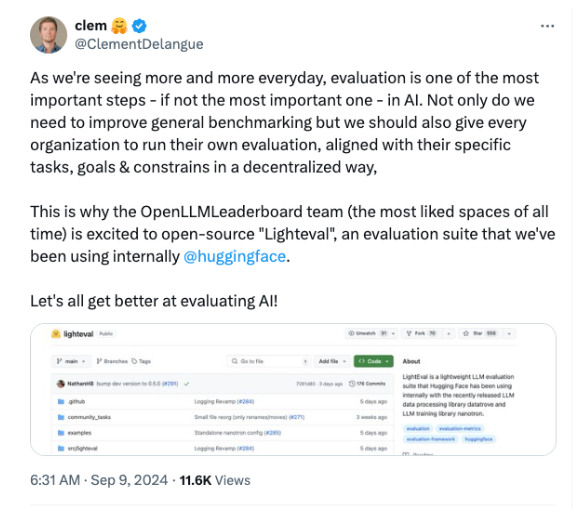

最近、Hugging Faceは、企業や研究者が大規模な言語モデル(LLMS)をよりよく評価できるように設計された軽量AI評価スイートであるLightevalと呼ばれる新しいツールを立ち上げました。

AIテクノロジーがさまざまな業界でより重要になるにつれて、これらのモデルを効果的に評価して、その正確性を確保し、ビジネス目標に準拠することが特に重要です。

一般的に、AIモデルの評価はしばしば過小評価されています。私たちはしばしばモデルの作成とトレーニングに焦点を当てますが、モデルを評価する方法も同様に重要です。厳密かつコンテキスト固有の評価がなければ、AIシステムは、ビジネス目標に不正確、偏見、または矛盾する可能性があります。

したがって、Face CEOClémentDelangueは、評価が最終的なチェックポイントであるだけでなく、AIモデルが期待を満たすことを保証するための基礎でもあることをソーシャルメディアに強調しました。

今日、AIは研究研究所やテクノロジー企業に限定されなくなり、金融、ヘルスケア、小売などの多くの業界がAIテクノロジーを積極的に採用しています。ただし、標準化されたベンチマークが実際のアプリケーションの複雑さをキャプチャできないことが多いため、多くの企業がモデルを評価するときに課題に直面することがよくあります。 Lightevalはこの問題を解決するために生まれ、ユーザーはニーズに基づいてカスタマイズされた評価を実施できます。

この評価ツールは、Datatrove、Datatrove、Nanotronのモデルトレーニングライブラリなど、Faceの既存のツールの範囲をシームレスに統合して、完全なAI開発プロセスを提供します。

Lightevalは、CPU、GPU、TPUを含むさまざまなデバイスの評価をサポートし、さまざまなハードウェア環境に適応し、企業のニーズを満たしています。

Lightevalの発売は、AIの評価がますます注目を集めているときに来ます。モデルの複雑さが増すにつれて、従来の評価手法は徐々に不cru的になります。 Faceのオープンソース戦略を抱き締めることで、企業は独自の評価を実行でき、モデルが生産に就く前に倫理的およびビジネス基準を満たすことができます。

さらに、LightEvalは使いやすく、技術的なスキルが低いユーザーにも使用できます。ユーザーは、さまざまな人気のあるベンチマークでモデルを評価したり、独自のカスタムタスクを定義することもできます。さらに、LightEvalでは、ユーザーは、重み、パイプラインの並列性など、モデル評価の構成を指定することもでき、ユニークな評価プロセスを必要とする企業に強力なサポートを提供します。

プロジェクトの入り口:https://github.com/huggingface/lighteval

キーポイント:

抱きしめる顔は、評価の透明性とカスタマイズを向上させるために設計された軽量AI評価スイートであるLightevalを発売します。

Lightevalは、既存のツールとシームレスに統合して、多種デバイス評価をサポートして、さまざまなハードウェア環境のニーズに適応します。

このオープンソースツールにより、企業は自分自身を評価し、モデルがビジネスと倫理基準を満たすことを保証します。

Lightevalのオープンソースと使いやすさにより、企業や研究者がLLMを評価するための強力なツールとなり、AIテクノロジーのより安全で信頼性の高い開発の促進に役立ちます。 カスタム評価プロセスとマルチデバイスサポートを通じて、LightEvalはさまざまなシナリオで評価のニーズを満たし、AIアプリケーションの実装にしっかりと保証を提供します。