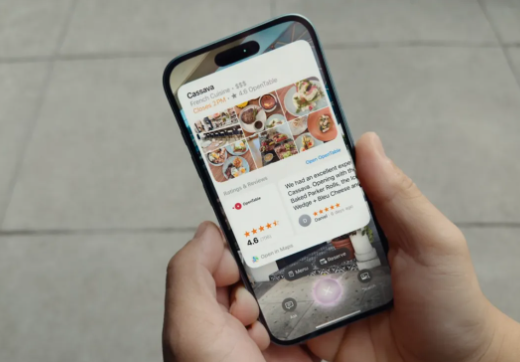

Appleは、iPhone 16の発売で非常に期待されるAI駆動の視覚インテリジェンス機能を発売しました。これにより、iPhoneのカメラ機能が新しいレベルになります。 IPHONEにGoogleレンズと同様の視覚的な検索機能を提供します。ユーザーは、レストランの標識を特定したり、場所やレビューを見つけたりするなど、写真を撮るだけで関連情報を取得できます。この革新的な機能により、情報収集プロセスが大幅に簡素化され、ユーザーがより便利でよりスマートなモバイルエクスペリエンスをもたらします。

iPhone 16 Launch Conferenceが開催されたばかりのAppleでは、新しいiPhone、Airpods、Apple Watch Series 10を披露するだけでなく、AI搭載のVisual Intelligence機能も初めて発売しました。この新機能は、Googleレンズと同様のiPhoneカメラを提供し、よりスマートな写真体験を可能にします。

Appleの視覚インテリジェンス機能により、ユーザーはシングルやレストランサインなどの写真を撮ることで周囲のオブジェクトをキャプチャでき、iPhoneのAIテクノロジーを使用して、より関連性の高い情報を検索して提供できます。ユーザーは、カメラをオンにして認識したいアイテムの写真を撮るだけで、iPhoneは情報をすばやく処理してフィードバックします。

さらに、Appleは特にデータプライバシーも強調しました。ユーザー撮影データは、Appleのプライベートクラウドコンピューティングに保存され、セキュリティを確保します。ただし、ユーザーが必要な場合は、当事者のサービスと統合することもできます。たとえば、ユーザーはキャプチャされたコンテンツをGoogleに直接検索することを選択できます。

さらに興味深いのは、AppleがChatGPTの統合も導入したことです。ユーザーは、ChATGPTがカメラによってキャプチャされた画像データを処理できるようにし、詳細情報と提案をさらに取得できます。これらのすべてでは、ユーザーが自分のニーズに応じて対応する権限を有効にするかどうかを選択する必要があります。

iPhone 16とiPhone 16Plusは、それぞれ799ドルと899ドルの価格で予約注文を受け入れ始めましたが、視覚インテリジェンス機能はすぐに利用できないことに言及する価値があります。 Appleは、これらのAI機能が来月ベータ版で徐々に発売されると述べ、今後数か月以内にさらに機能が追加されると述べました。

キーポイント:

Appleの視覚インテリジェンス機能により、iPhoneカメラはGoogleレンズのような視覚検索を実行できます。

ユーザーデータは、プライバシーとセキュリティを確保するために、Appleのプライベートクラウドコンピューティングに保存されます。

将来的には、CHATGPTなどのサードパーティアプリケーションと統合して、より多くの情報を取得することもできます。

全体として、Appleの視覚インテリジェンス機能はiPhoneカメラへの主要なアップグレードであり、ユーザーが周囲の世界と対話する方法を変えます。機能はまだテスト段階にありますが、その可能性は無制限であり、将来の開発とより多くの機能の発売を楽しみにしています。