アレン人工知能研究所(AI2)は最近、70億パラメーターを持つスパースハイブリッドエキスパート(MOE)モデルである新しい大規模な言語モデルOlmoeをリリースしましたが、各入力マークは10億パラメーターのみを使用しているため、推論数が大幅に減少します。コストとメモリの要件。 Olmoeには、ユニバーサルバージョンのOlmoe-1B-7Bと、ベンチマークで他の大きなモデルを実行する微調整バージョンのバージョンがあります。 AI2は、MOEモデルの分野で特に貴重であり、学術研究に貴重なリソースを提供するOlmoeの完全なオープンソースを強調しています。

Olmoeは、70億パラメーターを備えたスパースハイブリッドエキスパート(MOE)アーキテクチャを採用していますが、入力タグごとに使用されているパラメーターは10億のみです。 2つのバージョンには、一般的なOlmoe-1B-7Bと命令チューニングされたOlmoe-1B-7B-Instructがあります。

閉じたソースである他のほとんどのハイブリッドエキスパートモデルとは異なり、AI2はOlmoeが完全にオープンソースであることを強調しています。彼らは論文で「ほとんどのMOEモデルは閉鎖です:モデルの重みを開示するものもありますが、多くの学術研究者がこれらのモデルにアクセスすることは不可能になります。

AI2の研究科学者であるネイサン・ランバートは、ソーシャルメディアで、Olmoeが政策決定に役立つと述べました。彼はまた、Olmoeモデルのリリースは、AI2のオープンソースモデルの開発とそのパフォーマンスをクローズドモデルに匹敵するという目標の一部であると述べました。

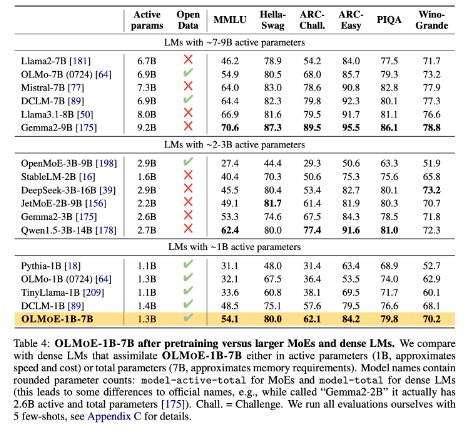

モデルビルディングに関しては、AI2は64人の小規模な専門家を微細なルーティングに使用し、実行時にそのうち8人のみをアクティブにすることを決定しました。実験は、Olmoeがパフォーマンスの他のモデルに匹敵するが、推論コストとメモリストレージが大幅に減少していることを示しています。 Olmoeは、AI2の前にオープンソースモデルOlmo1.7-7bにも構築され、4096タグ付きコンテキストウィンドウをサポートしています。 Olmoeのトレーニングデータは、Common Crawl、Dolma CC、Wikipediaなどを含む複数のソースからのものです。

ベンチマークでは、Olmoe-1B-7Bは、同様のパラメーターを持つモデルと比較して多くの既存モデルを上回り、Llama2-13B-chatやdeepseekmoe-16bなどのより大きなモデルを上回ります。

AI2の目標の1つは、ハイブリッドエキスパートアーキテクチャなど、より完全にオープンソースAIモデルを研究者に提供することです。多くの開発者はMOEアーキテクチャを使用していますが、AI2は他のほとんどのAIモデルが十分に開かれていないと考えています。

Huggingface:https://huggingface.co/collections/allenai/olmoe-66cf678c047657a30cd3da

紙の入り口:https://arxiv.org/abs/2409.02060

キーポイント:

-AI2がリリースした新しいオープンソースモデルOlmoeは、パフォーマンスとコストの面で競争力があります。

-Olmoeは、推論コストとメモリの要件を効果的に削減できるスパースハイブリッドエキスパートアーキテクチャを採用しています。

-AI2は、学術研究開発を促進する完全にオープンソースのAIモデルを提供することに取り組んでいます。

要するに、Olmoeのオープンソースリリースは、大規模な言語モデルの分野での主要な進歩です。 AI2の動きは、オープンソースAIの開発に対する確固たるコミットメントを反映しており、将来のより同様の貢献を楽しみにしています。