プリンストン大学とイェール大学の研究者は、大規模な言語モデル(LLM)の推論能力に関する詳細な研究を実施し、関連するレポートをリリースしました。この調査では、シフトパスワードをテストタスクとしてクラックし、分析のために3つのLLMS GPT-4、Claude3、およびLLAMA3.1を選択し、COT推論の背後にあるメカニズムを明らかにすることを目指しています。調査によると、LLMのCOT推論は単純な象徴的な論理的推論ではなく、複数の要因の複雑な相互作用の結果であり、LLMの推論能力を理解するための新しい視点を提供します。

プリンストンとイェール大学の研究者は最近、Big Language Model(LLM)で「リンクチェーン(COT)」の推論能力に関するレポートを発表し、COTの推論の謎を明らかにします。それは論理ルールのみに基づいた象徴的な推論ではなく、メモリ、確率、ノイズの推論を組み合わせます。

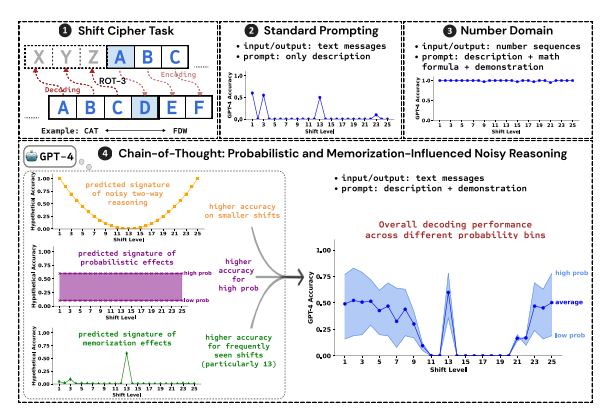

研究者は、3つのLLMS、GPT-4、CLAUDE3、およびLLAMA3.1のパフォーマンスを分析するために、テストタスクとしてシフトパスワードのクラックを使用しました。シフトパスワードは単純なエンコード方法であり、各文字は、アルファベットで固定数字で前進する文字に置き換えられます。たとえば、アルファベットを3桁前に移動し、「cat」は「FDW」になります。

研究結果は、COT推論の有効性に影響を与える3つの重要な要因が次のことを示しています。

確率:LLMは、推論が低い確率で回答を指している場合でも、より高い確率で出力を生成する傾向があります。たとえば、推論ステップが「Staz」を指しているが、「Stay」がより一般的な単語である場合、LLMは「それ自体を修正」し、「滞在」を出力する可能性があります。

メモリ:LLMは、トレーニング前に大量のテキストデータを覚えています。これは、COT推論の精度に影響します。たとえば、ROT-13は最も一般的なシフトパスワードであり、LLMは他のタイプのシフトパスワードよりもROT-13の精度が大幅に高くなっています。

ノイズ推論:LLMの推論プロセスは完全に正確ではありませんが、ある程度のノイズがあります。シフトパスワードの変位が増加すると、デコードに必要な中間ステップも増加し、ノイズ推論の影響がより明白になり、LLMの精度が低下します。

研究者はまた、LLMのCOT推論が自己条件に依存していることを発見しました。つまり、LLMはその後の推論ステップのコンテキストとしてテキストを明示的に生成する必要があります。 LLMがテキストを出力せずに「静かに考える」ように指示されている場合、その推論能力は大幅に低下します。 さらに、デモンストレーションステップの有効性は、デモンストレーションステップにエラーがある場合でも、LLMのCOT推論効果が依然として安定している可能性があります。

この研究は、LLMのCOT推論は完全な象徴的な推論ではなく、メモリ、確率、ノイズ推論などの複数の要因を組み合わせていることを示しています。 LLMは、COTの推論のプロセスにおけるメモリマスターの特性を示すだけでなく、確率マスターのスタイルも示しています。この研究は、LLMの推論能力をより深く理解し、より強力なAIシステムの将来の開発に関する貴重な洞察を提供するのに役立ちます。

紙の住所:https://arxiv.org/pdf/2407.01687

要約すると、この研究は大規模な言語モデルの推論メカニズムを理解することにとって非常に重要であり、その調査結果は、将来のLLMの推論能力を改善し、より強力なAIシステムを開発するための貴重な参照を提供します。 この研究では、LLMの推論に対する確率、記憶、ノイズなどの要因の影響を強調し、AIの分野の研究者に新しい方向性を提供します。