高品質の長いビデオを効率的に生成することは、コンピュータービジョンの分野で常に大きな課題でした。 Meta AIの研究者は、既存の拡散トランスモデル(DIT)の遅い推論に応じて、Adacacheと呼ばれるトレーニングなしの加速方法を提案しました。 Adacacheはビデオコンテンツの違いを巧みに利用し、各ビデオのキャッシュ戦略をカスタマイズし、ビデオモーションコンテンツに基づいてコンピューティングリソースを動的に割り当てるモーション正規化スキームを導入し、それにより、発電の品質を確保しながら推論速度を大幅に改善します。

高品質で時間のかかるビデオを生成するには、特に長い時間の間、多くのコンピューティングリソースが必要です。最新の拡散変圧器モデル(DIT)はビデオ生成に大きな進歩を遂げていますが、この課題は、より大きなモデルへの依存とより複雑な注意メカニズムのために、より遅い推論によって悪化しています。この問題を解決するために、Meta AIの研究者は、ビデオDITを加速するためにAdacacheと呼ばれるトレーニングなしの方法を提案しました。

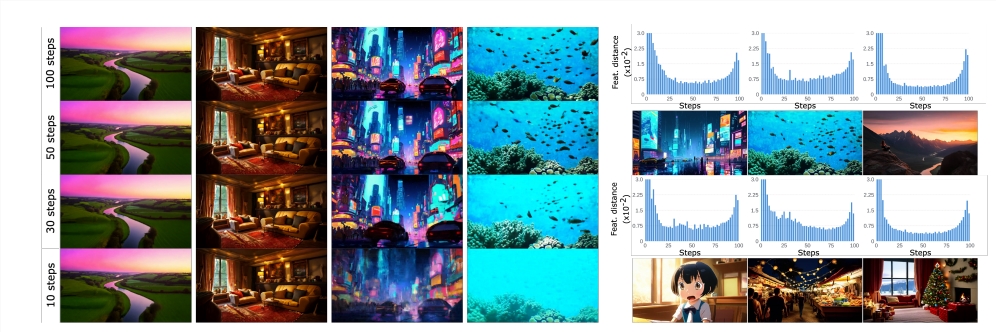

Adacacheの中心的なアイデアは、「すべてのビデオが同じではない」という事実に基づいています。つまり、一部のビデオでは、合理的な品質を達成するために他のビデオよりも少ない除去手順が必要です。 これに基づいて、この方法は拡散プロセス中に計算結果をキャッシュするだけでなく、各ビデオ生成のカスタマイズされたキャッシュ戦略を設計し、それによって品質とレイテンシのトレードオフを最大化します。

研究者はさらに、モーションコンテンツに基づいてコンピューティングリソースの割り当てを制御するためにAdacacheのビデオ情報を使用するMotion Remulization(MoreG)スキームを導入しました。 高周波テクスチャと大量のモーションコンテンツを含むビデオシーケンスは、合理的な品質を実現するためにより多くの拡散ステップが必要であるため、Moregはコンピューティングリソースをより適切に割り当てることができます。

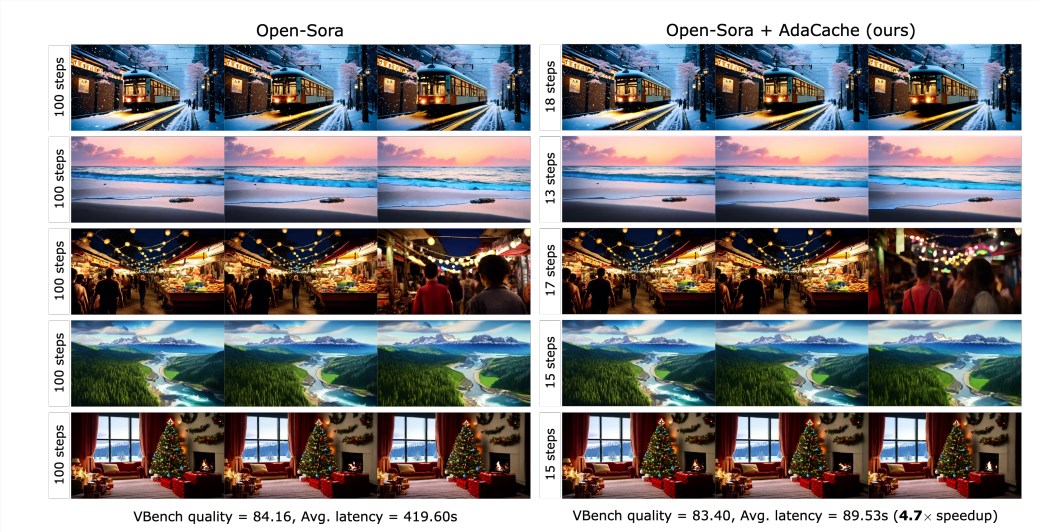

実験結果は、Adacacheが生成品質を犠牲にすることなく、推論速度を大幅に改善できることを示しています(たとえば、オープンソラ720p -2Sビデオ生成では最大4.7倍高速)。 さらに、Adacacheには優れた一般化機能があり、オープンソラ、オープンソラプラン、ラテなどのさまざまなビデオDITモデルに適用できます。 adacacheは、Δ-dit、T-gate、pabなどの他のトレーニングフリーの加速方法と比較して、速度と品質の両方に大きな利点があります。

ユーザーの調査によると、ユーザーは他の方法と比較してadacache生成ビデオを好み、品質がベンチマークモデルに匹敵すると考えています。 この研究は、adacacheの有効性を確認し、効率的なビデオ生成の分野に重要な貢献をしています。 Meta AIは、Adacacheが広く使用され、忠実度の長いビデオ生成の普及を促進できると考えています。

論文:https://arxiv.org/abs/2411.02397

プロジェクトホームページ:

https://adacache-dit.github.io/

Github:

https://github.com/adacache-dit/adacache

要するに、Adacacheは効率的なビデオ生成加速法として、高忠実度の長いビデオの生成に新しい可能性を提供し、その大幅なパフォーマンス改善と優れたユーザーエクスペリエンスにより、将来のアプリケーションで幅広い見通しがあります。メタAIによるこの研究は、効率的なビデオ生成の分野で重要なブレークスルーをもたらしました。