最近、研究チームはHellomemeと呼ばれるExpression Migration Frameworkを公開しました。これは、ある人の表現を非常に高い忠実度で別の人の画像に移行できます。ユニークなネットワーク構造と革新的なアニメーションモジュールを通じて、Hellomemeはビデオ生成のために滑らかさと高い画質の完璧なバランスを達成し、Arkit Face Blendshapesをサポートし、ユーザーがキャラクターの表現をうまく制御できます。さらに、ホットスワップアダプター設計により、SD1.5モデルとの互換性が保証され、作成の可能性が拡大し、ビデオの生成効率が大幅に向上します。この記事では、Hellomemeフレームワークの他の方法とコア機能、技術的機能、および比較を詳細に紹介します。

最近、研究チームはHellomemeというフレームワークをリリースしました。これは、写真のある人の表現を別の写真のキャラクターのイメージに移行できます。

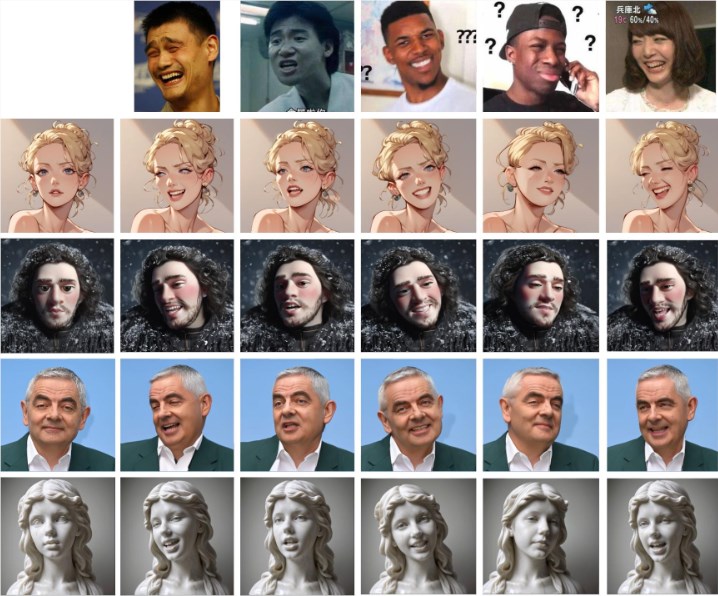

次の図に示すように、式画像(最初の行)を指定すると、他の写真の式の詳細を文字に転送できます。

Hellomemeのコアは、そのユニークなネットワーク構造です。フレームは、駆動ビデオから各フレームの機能を抽出し、これらの機能をHMControlmoduleに入力することができます。このような処理により、研究者はスムーズなビデオ画像を生成できます。ただし、最初に生成されたビデオでは、フレーム間でちらつき、全体的な視聴体験に影響を与える問題があります。この問題に対処するために、チームはAnimatediffモジュールを導入しました。これは、ビデオの継続性を大幅に改善するイノベーションであるが、ある程度の写真の忠実度を減らしたイノベーションです。

この矛盾に対応して、研究者はアニメーションモジュールをさらに最適化および調整し、最終的にはビデオの継続性を改善しながら高い画質を達成しました。

さらに、Hellomemeフレームワークは、表情編集を強力にサポートしています。 Arkit Face Blendshapesをバインドすることにより、ユーザーは生成されたビデオでキャラクターの表情を簡単に制御できます。この柔軟性により、作成者は必要に応じて特定の感情と表現を備えたビデオを生成し、ビデオコンテンツの表現力を大幅に豊かにすることができます。

技術的な互換性の観点から、HellomemeはSD1.5に基づいてホットスワップアダプター設計を採用しています。この設計の最大の利点は、T2I(テキストからイメージ)モデルの一般化能力に影響を与えないことであり、SD1.5で開発された様式化されたモデルがHellomemeとシームレスに統合できるようにすることです。これにより、さまざまな作品の可能性が高まります。

研究チームは、HMReferenceModuleの導入により、ビデオを生成するときに忠実度の条件が大幅に改善されることを発見しました。つまり、高品質のビデオを生成しながらサンプリングステップを削減できることを意味します。この発見は、生成効率を改善するだけでなく、リアルタイムのビデオ生成のための新しいドアを開きます。

他の方法との比較の影響は、次のとおりです。

プロジェクトの入り口:https://songkey.github.io/hellomeme/

https://github.com/hellovision/comfyui_hellomeme

キーポイント:

Hellomemeは、独自のネットワーク構造とアニメーションモジュールを通じて、ビデオ生成の流encyさと画質の二重の改善を達成します。

このフレームワークは、Arkit Face Blendshapesをサポートし、ユーザーがキャラクターの表情を柔軟に制御し、ビデオコンテンツのパフォーマンスを豊かにすることができます。

ホットスワップアダプター設計により、SD1.5に基づいた他のモデルとの互換性が保証され、作成の柔軟性が向上します。

効率的な表現移行能力、スムーズなビデオ生成効果、強力な互換性により、Hellomemeフレームワークはビデオ作成の新しい可能性を提供し、映画やテレビの制作、アニメーションの特殊効果、その他の分野で重要な役割を果たすことが期待されています。また、そのオープンソース機能により、より多くの開発者が参加し、テクノロジーのさらなる開発と改善を共同で促進することができます。