Meta Fair Labは最近、「Sparsh」と呼ばれる画期的なマルチモーダルの指先の触覚認識テクノロジーをリリースしました。 SPARSHモデルは、自己監督の学習を使用して、460,000を超える触覚画像を事前訓練し、データの手動ラベル付けなしに一般的な触覚表現を学習し、人間に似たロボットの触覚認識能力を実現します。さまざまな視覚的触覚センサーと互換性があり、特にデータが制限されている場合、力の推定やスライド検出などの複数のタスクでうまく機能します。そのパフォーマンスは従来のモデルのパフォーマンスをはるかに超えています。

SPARSHモデルは、トレーニング前に460,000を超える触覚画像を使用して、自己監視学習を採用し、データの手動ラベル付けなしに一般的な触覚表現を学習します。

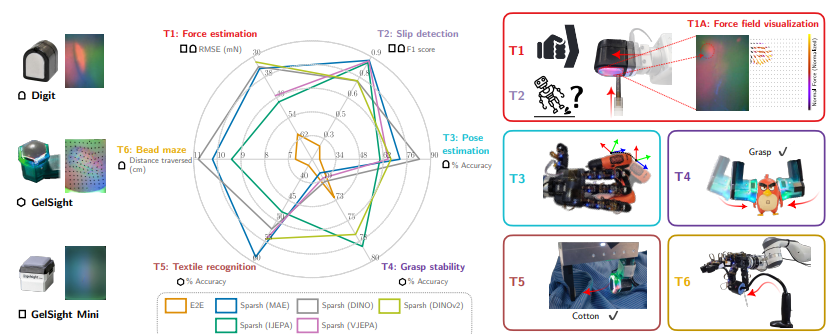

このモデルは、Digit、Gelsish2017、Gelsish Miniなどのさまざまな種類の視覚的触覚センサーをサポートすることができ、力の推定、スライド検出、ポーズ推定、グラブの安定性の予測、ファブリックの識別などの触覚認識タスクのロボット性能を大幅に向上させることができます。等 研究者はまた、Tacbenchと呼ばれる標準化されたベンチマークプラットフォームを構築して、さまざまなタスクでさまざまな触覚センサーとモデルのパフォーマンスを評価しました。

テスト結果は、特にデータボリュームが制限されており、そのパフォーマンスが従来のタスク固有およびセンサー固有のモデルをはるかに超えている場合、Tacbenchの6つのタスクすべてでSPARSHモデルがうまく機能することを示しています。 たとえば、力の推定およびスライド検出タスクでは、SPARSHモデルは、注釈データの1%のみが使用されていても、満足のいく結果を達成できます。 これは、Sparshがロボットがオブジェクトの物理的特性をよりよく理解し、より洗練された操作を実行するのに役立つことを意味します。

SPARSHモデルのリリースは、AI触覚の知覚の分野での大きなブレークスルーを示しています。 将来的には、より多くのデータの蓄積とモデルのさらなる最適化により、Sparshはロボットが物理的な世界と対話する方法を完全に変え、より広い範囲のフィールドでのロボット工学の適用を促進することが期待されています。

紙の住所:

https://scontent-sjc3-1.xx.fbcdn.net/v/t39.2365-6/464969941_11076333400780143_7479102347328147009_N.PDF? _nc_ohc = y8ui1hew3bqq7knvgfe-epu&_nc_zt = 14&_nc_ht = scontent-sjc3-1。 xx&_nc_gid = aeafsuzziasvwpfmqseozqu&oh = 00_ayamqxgq0atcysdxzwb0zt8bgskogymj13c9f3ytvtkmsg&oe = 672deeee4

Sparshテクノロジーの出現は、ロボットの触覚認識技術が新しいマイルストーンに到達したことを示しています。洗練された操作とヒューマンコンピューターの相互作用におけるその可能性は非常に大きく、その将来のアプリケーションの見通しは楽しみにしています。