大規模な言語モデル(LLM)のトレーニングと最適化は、人工知能の分野における重要な課題です。人間の価値に準拠する効率的なトレーニング方法とモデル出力が重要です。補強学習と人間のフィードバック(RLHF)は、主流のLLMトレーニング方法ですが、効率とスケーラビリティの改善の余地があります。この目的のために、Bytedance Doubao Big Model Teamは、HybridFlowと呼ばれるRLHFフレームワークを開き、これらの問題を解決し、LLMトレーニングに新しい可能性をもたらすことを目指しています。革新的な設計により、このフレームワークはLLMトレーニングの効率と柔軟性を向上させます。

GPTやLLAMAなどの大きなモデル(LLM)は、人工知能の分野で革命を起こしましたが、これらの巨大なモデルを効率的に訓練し、人間の価値観に沿って作る方法は困難な問題です。

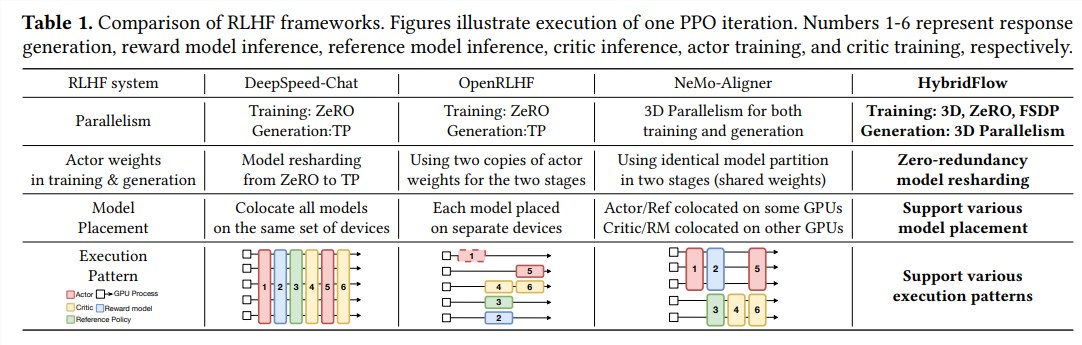

強化学習と人間のフィードバック(RLHF)は、近年重要なLLMトレーニング方法として広く使用されていますが、従来のRLHFフレームワークには柔軟性、効率、スケーラビリティに制限があります。

これらの問題を解決するために、Doubao Big ModelチームのオープンソースHybridFlowと呼ばれるRLHFフレームワークをオープンソースにし、LLMトレーニングに新しい可能性をもたらしました。

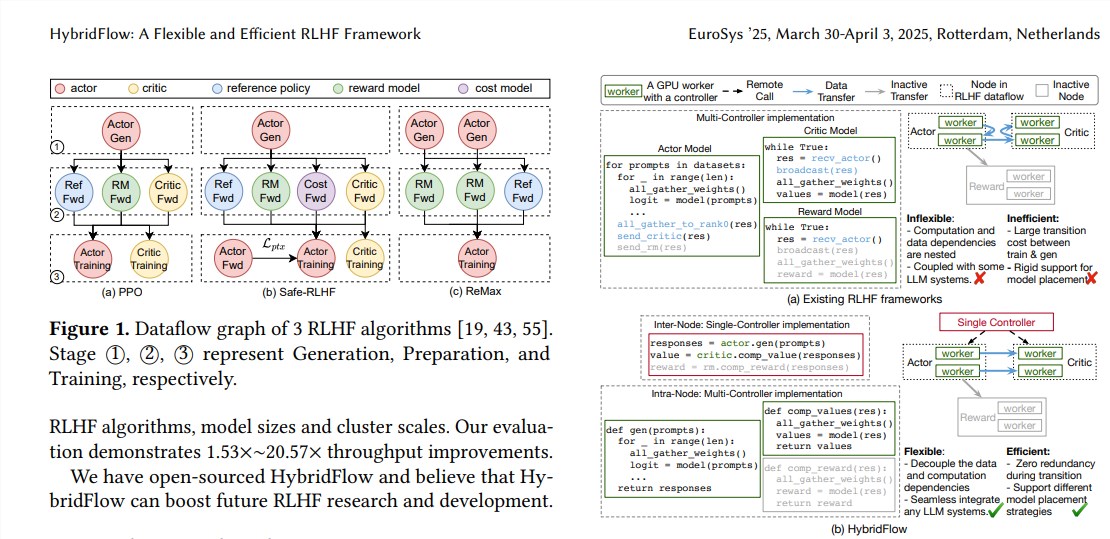

RLHFは通常、3つの段階で構成されています。

まず、アクターモデルは入力プロンプトに基づいてテキストを生成します。

最後に、これらの評価結果を使用して、アクターモデルをトレーニングして、人間の好みに沿ったテキストを生成します。従来のRLHFフレームワークは通常、単一のコントローラーを使用してデータストリーム全体を管理しますが、これは分散コンピューティングを必要とするLLMにとって非効率的です。

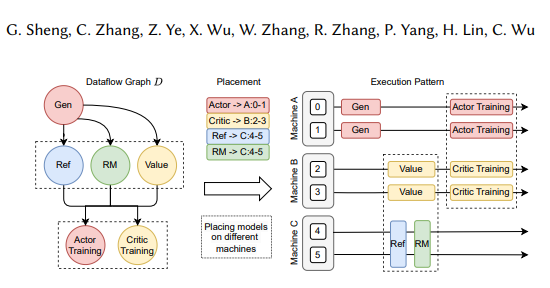

ハイブリッドフローフレームワークは、シングルとマルチコントローラーモードを革新的に組み合わせて、階層的なAPI設計を介して複雑なコンピューティングとデータ依存関係を分離し、RLHFデータストリームの柔軟な表現と効率的な実行を可能にします。

ハイブリッドフローの利点は、主に次の3つの側面に反映されています。

さまざまなRLHFアルゴリズムとモデルの柔軟なサポート:HybridFlowは、PPO、Remax、Safe-RLHFなどのさまざまなRLHFアルゴリズムを簡単に実装および拡張できるモジュラーAPIを提供します。

効率的なモデル重量の再編成:3Dハイブリデンエンジンコンポーネントは、アクターモデルをサポートして、トレーニング段階と生成段階でモデルの重量を効率的に再編成し、メモリ冗長性と通信オーバーヘッドを最小限に抑えます。

自動モデルの展開と並列ポリシーの選択:自動マッピングコンポーネントは、モデルの負荷とデータの依存関係に基づいてモデルを異なるデバイスに自動的にマッピングし、最適な並列ポリシーを選択し、モデルの展開プロセスを簡素化し、トレーニング効率を改善できます。

実験結果は、さまざまなRLHFアルゴリズムを最大20.57回実行すると、ハイブリッドフローのスループットが大幅に増加することを示しています。 HybridFlowのオープンソースは、RLHFの研究開発に強力なツールを提供し、将来のLLMテクノロジーの開発を促進します。

紙の住所:https://arxiv.org/pdf/2409.19256

ハイブリッドフローフレームワークのオープンソースは、LLMトレーニングプロセスを改善するための効果的な方法を提供します。将来のLLM研究でより大きな役割を果たしているハイブリッドフローを楽しみにしています。