Openaiは、大規模な言語モデルの事実上の正確性を評価することを目指して、新しいベンチマークSimpleQAをリリースしました。 AIテクノロジーの急速な発展に伴い、モデル出力の信頼性が重要であり、「幻想」現象(一見信頼できるが実際には間違った情報のモデル生成)がますます深刻な課題になります。 SimpleQAの出現は、この問題を解決するための新しい方法と標準を提供します。

最近、OpenaiはSimpleQAと呼ばれる新しいベンチマークをリリースして、言語モデルの事実上の正確性を評価しました。

大規模な言語モデルの急速な発展により、生成されたコンテンツの正確性が多くの課題に直面すること、特にいわゆる「幻想」現象に直面します。モデルは、自信を持っているが実際に間違っている、または検証できない情報を生成します。この状況は、情報を取得するためにAIに依存する人々のコンテキストで特に重要になっています。

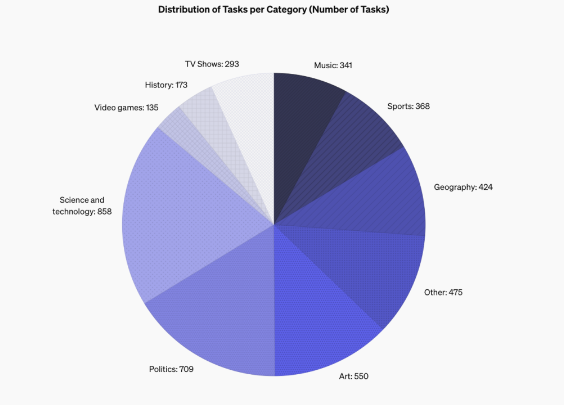

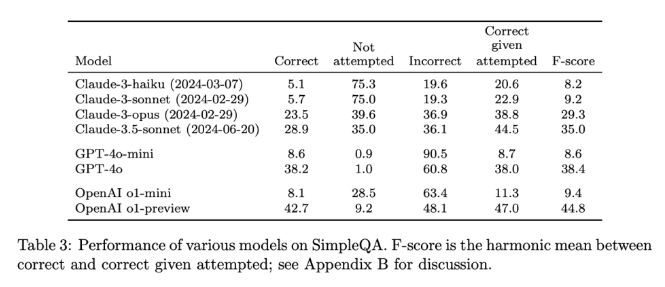

SimpleQAの設計機能は、モデルの回答が正しいかどうかを評価するのが簡単になるため、しばしばしばしば強固な答えを持つ短い明確な質問に焦点を合わせていることです。他のベンチマークとは異なり、SimpleQAの問題は、GPT-4などの最先端のモデルでさえ課題に直面できるように慎重に設計されています。このベンチマークには、歴史、科学、技術、アート、エンターテイメントなどの複数の分野をカバーする4326の質問が含まれており、モデルの精度とキャリブレーション機能の評価に特に重点を置いています。

SimpleQAのデザインは、いくつかの重要な原則に従います。まず、各質問には、2人の独立したAIトレーナーによって決定された参照回答があり、答えの正しさを確保します。

第二に、質問の設定はあいまいさを回避し、各質問は単純で明確な答えで答えることができるため、評価は比較的簡単になります。さらに、SimpleQAはChatGPT分類器を評価に使用し、答えを「正しい」、「エラー」、または「試行なし」として明示的にマークします。

SimpleQAのもう1つの利点は、多様な問題をカバーし、モデルの過剰な専門化を防ぎ、包括的な評価を保証することです。このデータセットは、質問と回答が短いため、簡単に使用できます。テストは速く実行され、結果はほとんど変わりません。さらに、SimpleQAは情報の長期的な相関も考慮しているため、情報の変化によって引き起こされる影響を回避し、「常緑」ベンチマークにします。

SimpleQAのリリースは、AIに生成された情報の信頼性を促進するための重要なステップです。使いやすいベンチマークを提供するだけでなく、研究者と開発者にも高い基準を設定し、言語を生成するだけでなく、本物で正確であるモデルを作成することを奨励します。 Open Sourceを通じて、SimpleQAはAIコミュニティに、言語モデルの事実上の正確性を改善して、将来のAIシステムが有益で信頼できることを保証する貴重なツールを提供します。

プロジェクトの入り口:https://github.com/openai/simple-evals

詳細:https://openai.com/index/introducing-simpleqa/

キーポイント:

SimpleQAは、OpenAIによって開始された新しいベンチマークであり、言語モデルの事実上の正確性の評価に焦点を当てています。

ベンチマークは、包括的な評価を確保するために、複数の領域をカバーする4326の短い質問で明確な質問で構成されています。

SimpleQAは、研究者が正確なコンテンツを生成する際の言語モデルの能力を特定し、改善するのに役立ちます。

要約すると、SimpleQAは、大規模な言語モデルの精度を評価するための信頼できるツールを提供し、そのオープン性と使いやすさは、AIフィールドをより本物の信頼できる方向に向けて駆り立てます。より信頼性が高く信頼できるAIシステムの誕生を促進するために、SimpleQAを楽しみにしています。