Rakuten Groupは、日本の人工知能の開発を促進することを目指して、最初の日本の大手言語モデル(LLM)Rakuten AI2.0およびSmall Language Model(SLM)Rakuten AI2.0miniをリリースしました。 Rakuten AI2.0は、ハイブリッドエキスパート(MOE)アーキテクチャを採用しており、70億個のパラメーターを備えた8つの専門家モデルを提供しています。 Rakuten AI2.0miniは、15億パラメーターを備えたコンパクトモデルであり、費用対効果とアプリケーションの容易さを考慮して、エッジデバイスの展開用に設計されています。どちらのモデルもオープンソースであり、さまざまなテキスト生成タスクをサポートするために、微調整および優先最適化バージョンを提供します。

Rakuten Groupは、Rakuten AI2.0およびRakuten AI2.0 Miniという名前の最初の日本の大手言語モデル(LLM)と小言語モデル(SLM)の発売を発表しました。

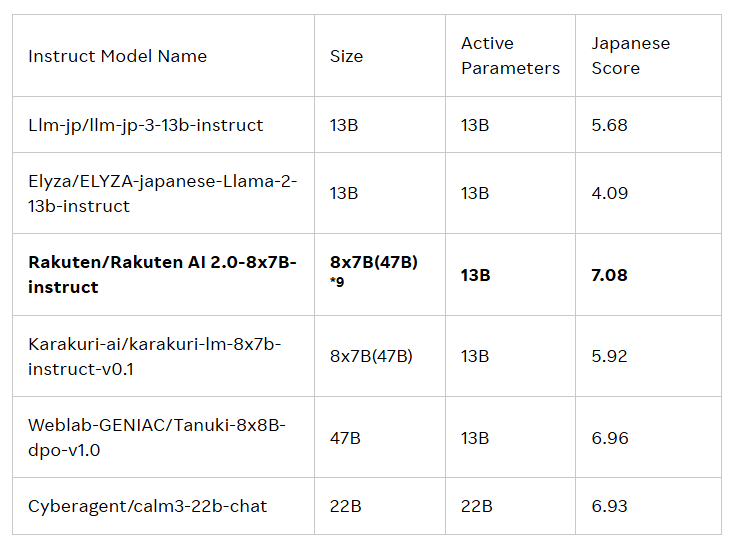

これら2つのモデルのリリースは、日本で人工知能(AI)の開発を促進することを目的としています。 Rakuten AI2.0は、ハイブリッドエキスパート(MOE)アーキテクチャに基づいており、70億パラメーターを持つ8つのモデルで構成される8x7Bモデルであり、それぞれが専門家として機能します。入力トークンが処理されるたびに、システムは2人の最も関連性の高い専門家に送信し、ルーターはそれを選択する責任があります。これらの専門家とルーターは、大量の高品質の日本と英語のバイリンガルデータを通じて常に一緒にトレーニングしています。

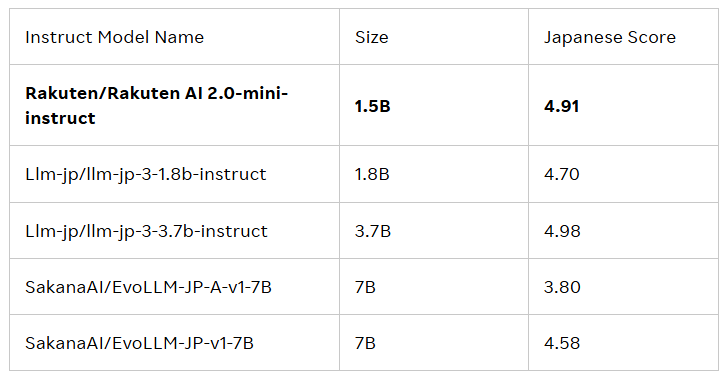

Rakuten AI2.0miniは、パラメーター量が15億の新しい密度の高いモデルで、費用対効果の高いエッジデバイスの展開用に設計され、特定のアプリケーションシナリオに適しています。また、便利なソリューションを提供することを目的として、日本と英国の混合データについても訓練されています。どちらのモデルも微調整され、好まれており、AIアプリケーションの開発において企業や専門家をサポートするための基本的なモデルと指導モデルをリリースしています。

すべてのモデルは、Rakuten GroupのFace Faceの公式ライブラリで入手できるApache2.0ライセンス契約の下にあります。さらに、これらのモデルは、さらなる開発とアプリケーションを促進する他のモデルの基礎としても機能します。

Rakuten GroupのAIチーフおよびデータ責任者であるCai Tingは、次のように述べています。企業は、インテリジェントな意思決定を行い、価値の実現を加速し、オープンモデルを通じて、日本のAIの発展を加速し、すべての日本企業が構築、実験、成長を奨励し、Win-Win協力コミュニティを促進することを望んでいます。 。」

公式ブログ:https://global.rakuten.com/corp/news/press/2025/0212_02.html

キーポイント:

Rakuten Groupは、Rakuten AI2.0およびRakuten AI2.0 Miniと呼ばれる最初の日本の大手言語モデル(LLM)およびSmall Language Model(SLM)を開始します。

Rakuten AI2.0は、ハイブリッドの専門家アーキテクチャに基づいており、日本と英語のバイリンガルデータを効率的に処理することを約束する70億パラメーターを持つ8つのエキスパートモデルがあります。

すべてのモデルは、公式のRakuten Hugging Face Libraryで利用でき、さまざまなテキスト生成タスクに適しており、他のモデルの基礎として機能します。

要するに、Rakuten AI2.0とRakuten AI2.0miniの発売は、そのオープンソースモデルの分野における日本のもう1つの重要な進歩をマークします。将来のアプリケーションと影響に。