北京ジョートン大学と中国科学技術大学の共同研究の下で、Doubao Big Modelチームの公式アカウントによると、Doubao Big Modelチームが提案する「Videworld」ビデオ生成実験モデルが最近正式に開設されました。

このモデルの最大のハイライトは、従来の言語モデルに依存していないが、視覚情報だけに基づいて世界を認識して理解できることです。この画期的な研究は、彼のTEDスピーチで言及されている「幼い子供は言語に頼らずに現実の世界を理解できる」というLi Feifei教授の概念に触発されました。

「VideWorld」は、大量のビデオデータを分析および処理することにより、複雑な推論、計画、意思決定機能を実現します。研究チームの実験は、モデルが300mパラメーターのみで重要な結果を達成したことを示しました。言語データやタグデータに依存する既存のモデルとは異なり、VideWorldは、特に折り紙や蝶ネクタイなどの複雑なタスクで、より直感的な学習方法を提供できる複雑なタスクで、独立して知識を学ぶことができます。

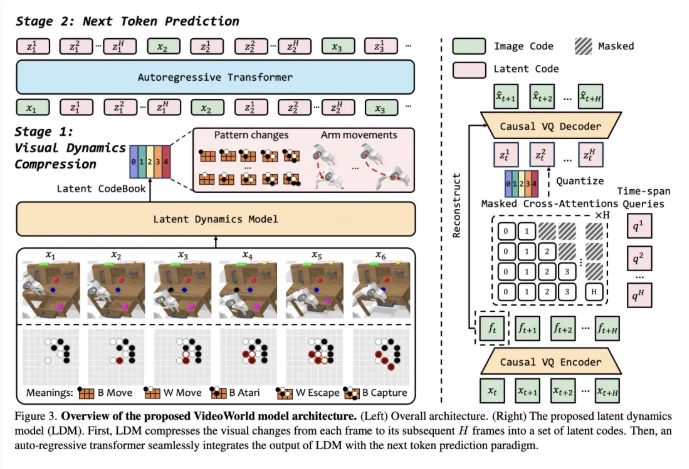

このモデルの有効性を検証するために、研究チームは2つの実験環境を確立しました:戦闘とロボットシミュレーション制御。非常に戦略的なゲームとして、GOはモデルのルール学習と推論能力を効果的に評価できますが、ロボットタスクでは、制御と計画におけるモデルのパフォーマンスを調べます。トレーニング段階では、モデルは、大量のビデオデモデータを視聴することにより、将来の写真を予測する能力を徐々に確立します。

ビデオ学習の効率を向上させるために、チームはビデオフレーム間で視覚的な変化を圧縮して重要な情報を抽出するように設計された潜在的な動的モデル(LDM)を導入しました。この方法は、冗長な情報を削減するだけでなく、複雑な知識のモデルの学習効率を高めます。このイノベーションを通じて、VideoworldはGOおよびロボットタスクの優れた能力を示し、プロの5段階GOのレベルにさえ到達します。

紙のリンク:https://arxiv.org/abs/2501.09781

コードリンク:https://github.com/bytedance/videoworld

プロジェクトホームページ:https://maverickren.github.io/videoworld.github.io

キーポイント:

「videworld」モデルは、視覚情報だけに基づいて知識学習を実現でき、言語モデルに依存しません。

このモデルは、GOおよびロボットシミュレーションタスクの優れた推論と計画機能を示しています。

プロジェクトコードとモデルはオープンソースであり、あらゆる人生の人々が経験と交換に参加することを歓迎します。