Meta AIの研究者と学術パートナーは、特殊なトレーニングなしで画像、ビデオ、オーディオを処理するための大規模な言語モデルを教える革新的なシステム(マルチモーダル反復LLMソルバー)を開発しました。 MILSは、大量のデータトレーニングではなく、言語モデルの自然な問題解決能力に依存しており、独自の利点を示しています。

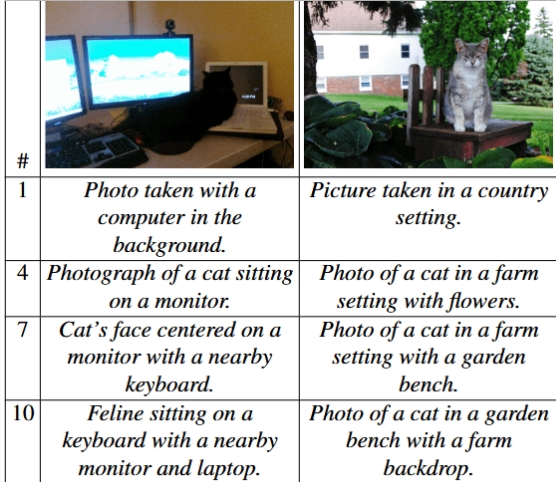

MILSは、2つのAIモデルをペアリングしてタスクソリューションを実行することで機能します。1つは「ジェネレーター」であり、タスクソリューションを提案する責任があり、もう1つは生成されたソリューションの有効性を評価するために使用されます。得点者が提供するフィードバックは、ジェネレーターが満足のいく結果に達するまで答えを継続的に最適化するのに役立ちます。たとえば、画像の説明タスクでは、MILSは画像の説明を徐々に改良することができ、それにより異なるレベルで画像の詳細を正確に説明できます。

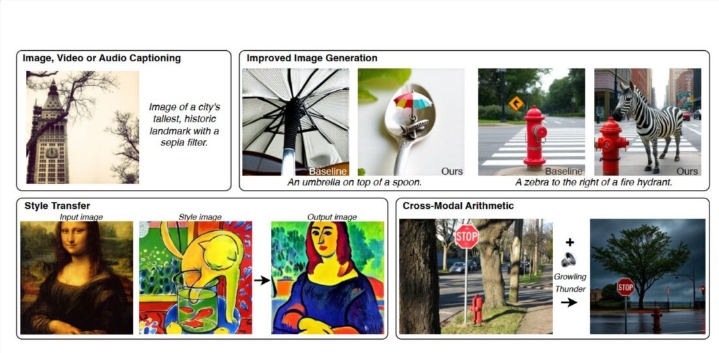

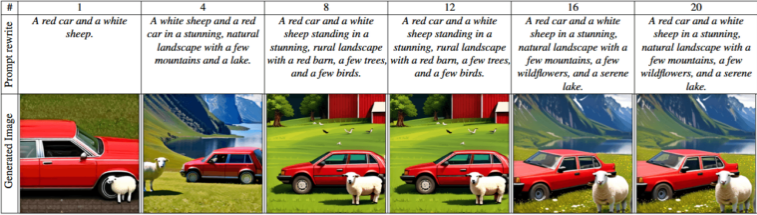

MILSは、画像の説明で特にうまく機能します。 Llama-3.1-8Bモデルをジェネレーターとして、クリップモデルを得点者として使用することにより、MILSは現在の主要な方法に匹敵する画像記述を作成できますが、クリップは画像の説明タスク用に特別にトレーニングされていません。さらに、MILSは、テキストプロンプトを微調整することでテキストから画像の生成機能を強化し、AIに生成されたプロンプトと画像処理ツールを組み合わせて、スタイル変換などの画像編集タスクを処理できます。

画像の説明の精度は、ジェネレーターとスコアラーの間のステップ数とともに増加します。 |写真:Ashutoshなど。

Milsの機能は画像に限定されず、ビデオフィールドやオーディオフィールドにも拡張されます。 MSR-VTTビデオデータセットを使用してテストすると、MILSはビデオコンテンツの説明で既存のモデルよりも優れています。 MILSは操作中にモデルパラメーターを変更しないため、さまざまなタイプのデータを読み取り可能なテキストに変換でき、画像やオーディオなどの複数のソースからの情報のマージと変換を目的の形式にサポートし、マルチモーダル情報が収束したアプリケーションを新しいものにします可能性。

テストでは、より大きな発電機とスコアリングモデルを使用すると、より正確な結果が得られ、潜在的なソリューションの数を増やすとパフォーマンスが大幅に改善されることが示されています。また、研究者は、より大きな言語モデルに拡張すると、結果の品質が向上するだけでなく、パフォーマンスが大幅に向上することを発見しました。

風景は、より正確な詳細とより自然な要素を備えた、単純な基本的な説明から複雑な景観表現に進化します。 |写真:Ashutoshなど。

MILSが採用したこの革新的な戦略は、よりスマートな推論能力に対する人工知能の分野の現在の傾向に沿っています。メタチームはまた、MILSが3Dデータ処理などの分野で将来的に大きな可能性を示し、マルチモーダルAIの開発をさらに促進する可能性があると述べました。

OpenaiのGPT-4およびMetaのLlama 3.2、MistralのPixtral、DeepseekのJanus Proなどのオープンソースの代替品の急速な発展により、これらの新たなマルチモーダルAIシステムは、日常生活への適用を加速しています人工知能の開発。