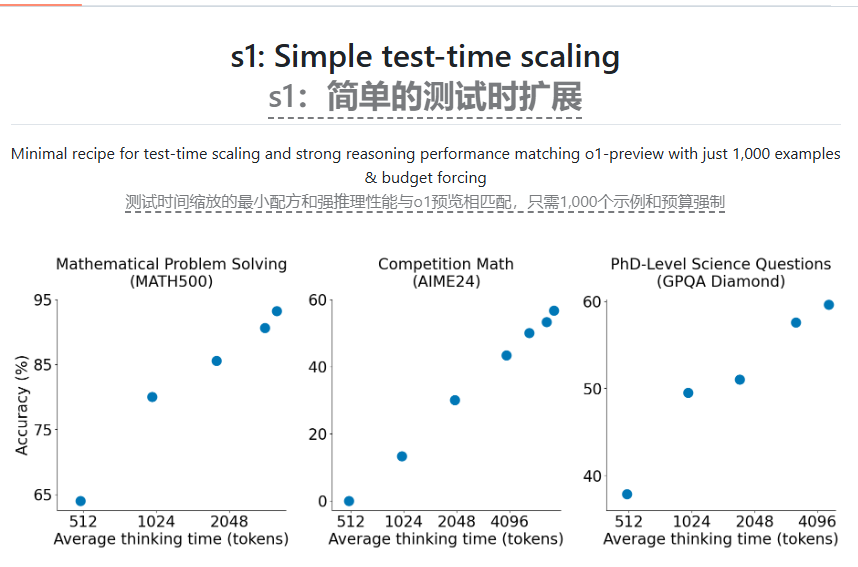

最近、スタンフォード大学とワシントン大学の研究者は、S1と呼ばれるAI推論モデルの訓練に成功しました。数学およびプログラミング能力テストにおけるモデルのパフォーマンスは、OpenaiのO1モデルおよびDeepseekのR1モデルに匹敵します。この結果は、AIモデルの商業化に関する新たな思考を引き起こし、大規模なAI研究所の間でも懸念を引き起こしました。

研究チームは、蒸留技術を通じて既製の基本モデルから必要な推論機能を抽出し、GoogleのGemini2.0 Flash Thinking Experimental Modelを使用して訓練されました。このプロセスは安価であるだけでなく、迅速なトレーニングでもあります。

それにもかかわらず、大規模なAIラボは、低コストの複製モデルの現象に不満を抱いています。 Meta、Google、Microsoftは、今後2年間に数千億ドルを投資して、次世代のAIモデルを訓練して市場での地位を統合する予定です。

S1の研究結果は、比較的小さなデータセットと監視された微調整方法を通じて強力な推論パフォーマンスを達成する可能性を示しています。これは、将来のAI研究の新しい方向性も提供します。

論文:https://arxiv.org/pdf/2501.19393

コード:https://github.com/simplescaling/s1

キーポイント:

S1モデルのトレーニングコストは50米ドル未満であり、そのパフォーマンスは最高の推論モデルのパフォーマンスに匹敵します。

蒸留技術を通じて、研究チームは既製モデルから推論能力を抽出し、トレーニングプロセスは高速で効率的です。

大規模なAIラボは、低コストの複製モデルの状況について懸念を表明しており、投資は将来のAIインフラストラクチャに焦点を当てます。