人工知能技術の急速な発展に伴い、ビジョンとテキストデータの統合が重要な課題となっています。従来のモデルには、構造化された視覚ドキュメントを扱う際に多くの制限があり、自動コンテンツの抽出と理解に影響します。 IBMによる最近リリースされたGranite-Vision-3.1-2Bは、この問題を解決するために設計された視覚的な言語モデルです。

人工知能技術の継続的な開発により、視覚とテキストデータの統合が複雑な課題になりました。従来のモデルは、テーブル、チャート、インフォグラフィック、イラストなどの構造化された視覚文書を正確に解析することがよくあります。この需要に直面して、IBMは最近、ドキュメントの理解のために設計された小さな視覚言語モデルであるGranite-vision-3.1-2Bをリリースしました。

Granite-Vision-3.1-2Bは、テーブル、チャート、イラストなど、さまざまな視覚形式からコンテンツを抽出できます。このモデルは、さまざまなドキュメント関連のタスクを処理できるパブリックソースや合成ソースなどのデータソースを使用して、慎重に選択されたデータセットでトレーニングされています。 Graniteの大規模な言語モデルの改善されたバージョンとして、画像とテキストの2つのモダリティを統合して、モデルの解釈能力を改善し、さまざまな実用的なアプリケーションシナリオに適しています。

モデルは3つの重要なコンポーネントで構成されています。1つ目は、視覚的なエンコーダーを使用して視覚データを効率的に処理およびエンコードします。テキスト情報を使用した視覚情報。最後に、Granite-3.1-2B-Instructに基づく大きな言語モデルは、複雑で巨大な入力を処理できるコンテキスト長です。

トレーニング中、Granite-Vision-3.1-2BはLlavaを描き、多層エンコーダーの特性と、任意の速度で密度の高いグリッド解像度を組み合わせます。これらの改善により、詳細な視覚コンテンツを理解するモデルの能力が向上し、テーブルとチャートの分析、光学文字認識(OCR)の実行、ドキュメントベースのクエリの回答など、視覚ドキュメントタスクをより正確に実行できます。

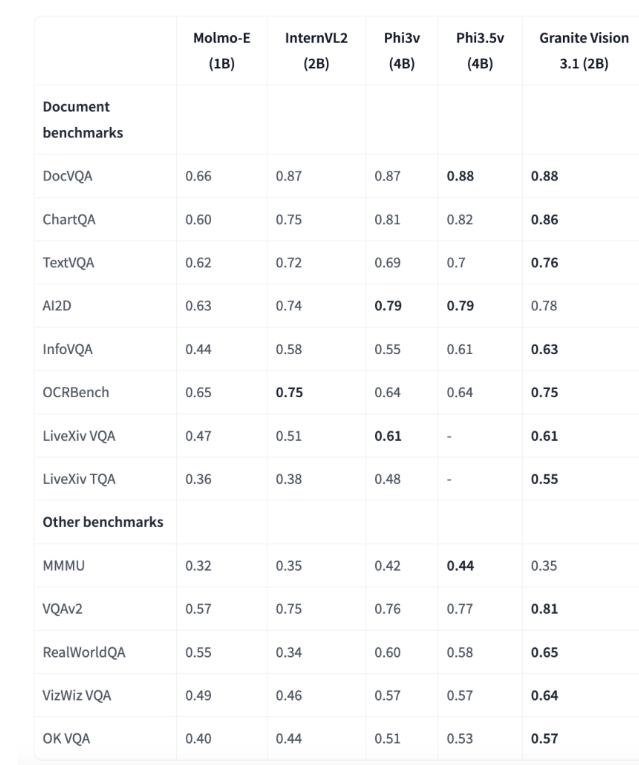

評価の結果は、Granite-Vision-3.1-2Bが複数のベンチマーク、特に文書の理解でうまく機能していることを示しています。 Chartqaベンチマークでは、モデルは0.86を採点し、1B-4B範囲のパラメーターを使用して他のモデルを上回りました。 TextVQAベンチマークでは、スコアは0.76であり、画像に組み込まれたテキスト情報を解析して回答する強力な能力を示しています。これらの結果は、エンタープライズアプリケーションでの正確な視覚およびテキストデータ処理のモデルの可能性を強調しています。

IBMのGranite-Vision-3.1-2Bは、視覚言語モデルの重要な進歩を表し、バランスの取れた視覚文書理解ソリューションを提供します。そのアーキテクチャおよびトレーニング方法により、複雑な視覚とテキストデータを解析および分析することができます。トランスとVLLMのネイティブサポートのおかげで、このモデルはさまざまなユースケースに適合させることができ、Colab T4などのクラウド環境に展開でき、研究者や専門家にAI駆動型のドキュメント処理機能を強化するための実用的なツールを提供します。

モデル:https://huggingface.co/ibm-granite/granite-vision-3.1-2b-preview

キーポイント:

Granite-Vision-3.1-2Bは、IBMによるドキュメント理解のために特別に設計された小さな視覚言語モデルであり、複数の視覚形式でコンテンツ抽出を処理できます。

このモデルは、視覚エンコーダー、視覚言語コネクタ、大規模な言語モデルの3つの部分で構成されており、複雑な入力の理解が向上します。

複数のベンチマーク、特にドキュメントの理解の分野で優れており、エンタープライズアプリケーションの強力な可能性を示しています。

IBMのGranite-Vision-3.1-2Bは、視覚データとテキストデータを統合する能力を向上させるだけでなく、企業に強力なドキュメント処理ツールを提供し、実際のアプリケーションにおけるAIテクノロジーの大きな可能性を実証します。