スタンフォード大学とワシントン大学の研究チームは、最近、S1と呼ばれるブレークスルーAIトレーニング方法をリリースしました。巨大なコンピューティングパワーや複雑なアルゴリズムへの過去の依存とは異なり、S1メソッドは、テスト中にモデルのコンピューティングリソースの割り当てを制御することにより、パフォーマンスの跳躍を巧みに実現します。

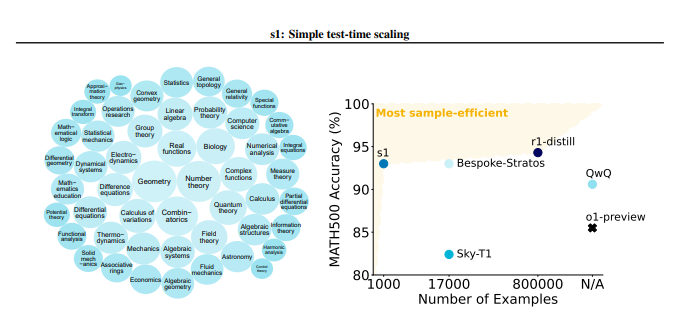

S1メソッドは、最初に1000の高品質の推論問題を含むS1Kと呼ばれる小さなデータセットを慎重に構築しました。このデータセットのスクリーニング基準は非常に厳しいものであり、同時に困難、強い多様性、優れた品質の3つの条件を満たす必要があります。研究チームは、詳細なアブレーション実験を通じてこれら3つの基準の重要性を検証し、結果は、単一の基準にランダム選択または焦点を当てることがパフォーマンスの大幅な低下につながることを示しました。 59,000のサンプルを含むスーパーセットを使用して訓練されていても、その効果は慎重に選択された1,000サンプルの効果よりもはるかに少ないことに言及する価値があります。これは、データ選択の重要性を強調しています。

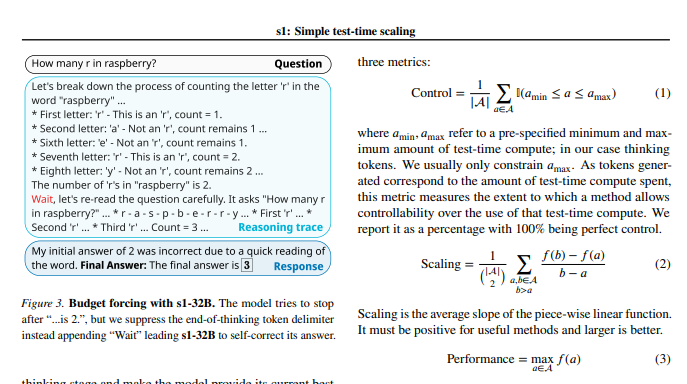

モデルトレーニングが完了した後、研究者は「予算必須」と呼ばれる手法を使用して、テスト中の計算量を制御しました。簡単に言えば、この方法は、モデルの思考プロセスを強制的に終了するか、「待機」命令を追加することにより、モデルの思考時間を拡張し、それによりモデルをより深い探索と検証のために導きます。このようにして、モデルは推論の手順を繰り返し確認し、エラーを効果的に修正できます。

実験結果は、S1Kデータセットの微調整と「予算の必須」テクノロジーのサポートにより、競合レベルの数学的問題におけるS1-32BモデルのパフォーマンスがOpenAIのO1-Previewモデルを最大27%超えたことを示しています。さらに驚くべきことは、「予算の必須」スケーリングを通じて、S1-32Bモデルは独自のトレーニングレベルを超えた一般化能力も示し、AIME24テストセットのスコアが50%から57%に増加したことです。

この研究の中心的な貢献は、高い推論機能を備えたデータセットを作成し、テスト時にパフォーマンススケーリングを達成するためのシンプルで効率的な方法を提供することです。これに基づいて、研究チームはS1-32Bモデルを作成しました。S1-32Bモデルは、パフォーマンスが閉じたソースモデルに匹敵する、またはそれを超えることさえあり、同時にオープンソースと高いサンプル効率を達成します。調査のコード、モデル、およびデータは、GitHubで開かれたものです。

研究者はまた、テスト中のデータの微妙さとスケーリング手法について詳細なアブレーション実験を実施しました。データ側では、困難、多様性、品質を同時に考慮することが重要だと感じました。テスト時のスケーリングに関しては、「予算の必須」アプローチは、優れた制御性とパフォーマンスの改善を示しています。この研究では、並列スケーリングとシーケンシャルスケーリングの2つの異なる方法も調査し、Rebaseなどの高度な技術を紹介し、将来の研究方向に重要なインスピレーションを提供します。

この研究は、新しい低コストで高効率のアイデアをAIトレーニングの分野にもたらすだけでなく、より広い範囲のAIアプリケーションの強固な基盤をもたらします。

紙の住所:https://arxiv.org/pdf/2501.19393

この研究は、慎重なデータセットの構築と時間テストのコンピューティングリソース管理により、AIモデルの推論機能を大幅に改善し、将来のAI開発のための新しい方向性を提供できることを示しています。