近年、大規模な言語モデルの急速な発展により、推論強化モデルは、複雑なタスクの処理能力を改善しながら、幻覚率に関する広範な議論も引き起こしました。 Vectaraの機械学習チームは最近、DeepSeekシリーズモデルの詳細な研究を実施し、幻覚率の観点から推論を強化するモデルの有意差を明らかにしました。

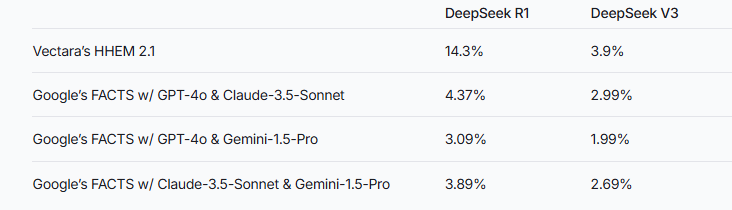

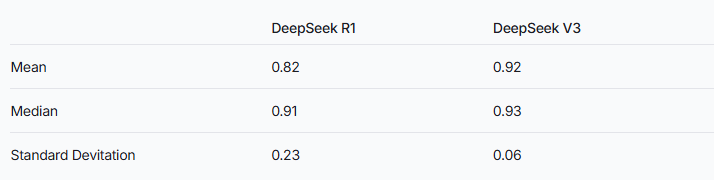

最近、Vectaraの機械学習チームは、DeepSeekシリーズの2つのモデルで詳細な幻覚テストを実施しました。 V3。これは、DeepSeek-R1が推論を増強するプロセス中に、元の情報とより不正確または矛盾することを示唆しています。この結果は、推論が強化された大手言語モデル(LLM)の幻覚率に関する広範な議論を引き起こします。

画像ソースノート:画像はAIによって生成され、画像認定サービスプロバイダーMidjourney

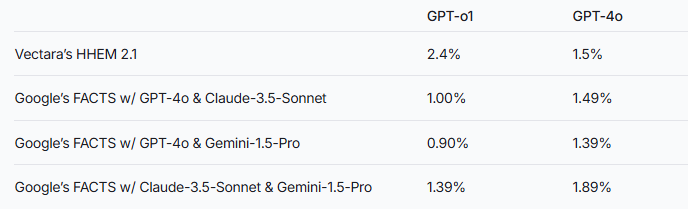

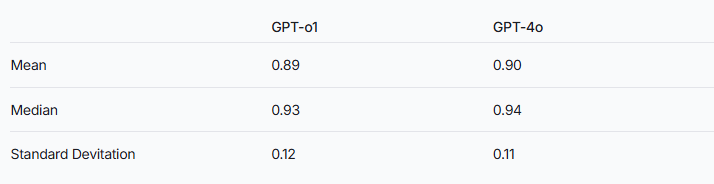

研究チームは、推論の増強モデルは、通常の大手言語モデルよりも幻覚を起こしやすい可能性があることを指摘しました。この現象は、DeepSeekシリーズと他の推論強化モデルと比較することで特に顕著です。 GPTシリーズを例にとると、推論が強化されたGPT-O1とGPT-4Oの通常のバージョンとの幻覚率の違いもこの推測を検証します。

これら2つのモデルのパフォーマンスを評価するために、研究者はVectaraのHHEMモデルとGoogleの事実方法を使用して判断を下しました。特殊な幻覚検出ツールとして、HHEMはDeepSeek-R1の幻覚速度の増加をキャプチャする際に高い感度を示しますが、この点ではFactsモデルのパフォーマンスは比較的不十分です。これは、HHEMが標準としてLLMよりも効果的である可能性があることを思い出させます。

Deepseek-R1は、推論における優れたパフォーマンスにもかかわらず、幻覚率が高いことを伴うことは注目に値します。これは、推論強化モデルを処理するために必要な複雑なロジックに関連している可能性があります。モデル推論の複雑さが増すと、生成されたコンテンツの精度が代わりに影響を受ける可能性があります。また、研究チームは、Deepseekがトレーニング段階で幻覚を減らすことにもっと集中できる場合、推論能力と精度の間の良いバランスをとることが可能である可能性があることを強調しました。

推論が強化されたモデルは一般により高い幻覚を示しますが、これは他の点で利点がないことを意味するものではありません。 DeepSeekシリーズでは、モデル全体のパフォーマンスを改善するために、その後の研究と最適化において幻覚を解決する必要があります。

参照:https://www.vectara.com/blog/deepseek-r1-hallucinates-more-than-deepseek-v3

大規模な言語モデルの継続的な進化により、推論能力を改善しながら幻覚率を低下させる方法は、将来の研究の重要な方向になります。 DeepSeekシリーズのテスト結果は、モデルのパフォーマンスをさらに最適化するために業界を促進するための貴重な参照を提供します。