人工知能技術の急速な発展により、言語モデルは複数の分野でますます広く使用されています。しかし、新しいOpenaiの研究では、これらのモデルは、事実上の質問に答える際に期待をはるかに下回り、AIの知識を獲得する能力の再考を引き起こしたことが明らかになりました。

OpenAIによる最近の研究は、人工知能技術の急速な発展にもかかわらず、現在の最も先進的な言語モデルは、事実の質問に答える際にはるかに低い成功率を持っていることを示しています。

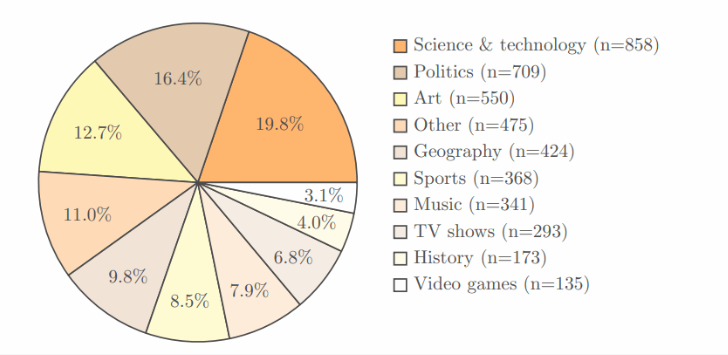

この調査では、科学、政治、芸術などの複数の分野をカバーする4,326のエリアを含むOpenai独自のSimpleQAベンチマークテストを採用し、それぞれの質問には明確で正しい答えがあります。

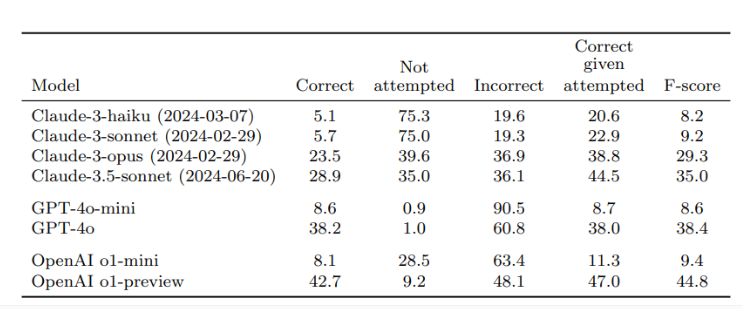

2人の独立したレビュアーによる検証の後、結果は、OpenAIの最良のモデルであるO1-Previewの精度率はわずか42.7%であり、GPT-4Oはわずかに低く、わずか38.2%であることを示しました。小さいGPT-4O-MINIに関しては、精度はわずか8.6%です。対照的に、AnthropicのClaudeモデルはより悪化し、Claude-3.5-Sonnetの精度率はわずか28.9%でした。

この研究の鍵は、AIのパフォーマンスをテストするだけでなく、知識習得の観点からAIモデルの限界を誰もが実現させるためのテストの設計です。研究者は、これらのモデルを使用する場合、ユーザーは知識源に完全に依存するのではなく、情報処理ツールと見なす必要があると強調しています。より正確な回答を得るには、組み込みの知識だけに依存するのではなく、AIに信頼できるデータを提供することが最善です。

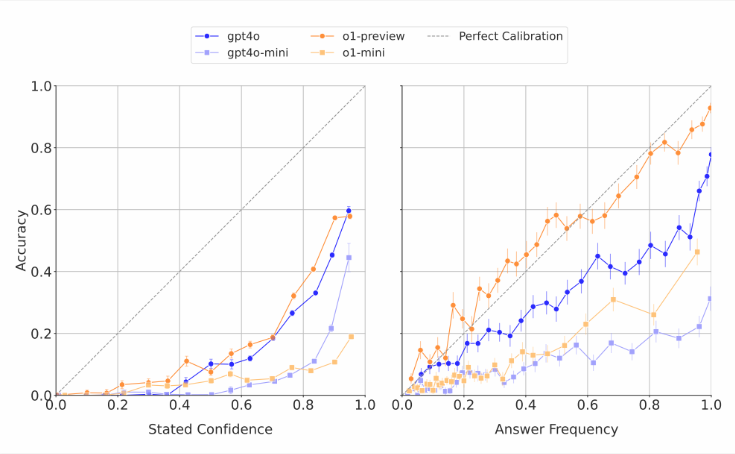

AIモデルがしばしば独自の能力を推定することは注目に値します。研究者は、これらのモデルが彼らの応答に自信を獲得するように求められたとき、彼らは通常、誇張された精度スコアを与えることを発見しました。同じ質問に繰り返し回答するテストでは、モデルが同じ答えを複数回与えたとしても、実際の成功率は自己評価の精度よりも低くなっています。これは、言語モデルに対する不条理な答えをしばしば生み出すが、自信があるように見える外部の世界の批判と一致しています。

研究者は、現在のAIシステムの事実上の正確性に明確なギャップがあり、緊急に改善が必要であると考えています。同時に、彼らはまた、開かれた質問をしました。短い事実の質問に答える際のAIのパフォーマンスが、より長くより複雑な答えを扱うときにそれがどのように機能するかを予測できるかどうか。より信頼性の高い言語モデルの開発をサポートするために、OpenaiはGitHubでSimpleQAベンチマークに関するデータを公開しています。

キーポイント:

OpenAIの調査によると、最先端の言語モデルは、事実上の質問に答える際に成功率が低く、最大成功率はわずか42.7%です。

これらのAIモデルは、しばしば能力を過大評価しており、自信のスコアは一般的に誇張されています。

Openaiは、より信頼性の高い言語モデルの調査を支援するために、SimpleQAベンチマークを公開しました。

この研究は、AIテクノロジーの大幅な進歩にもかかわらず、その制限は実際のアプリケーションで慎重に扱われ、技術の改善を促進し続ける必要があることを思い出させます。