人工知能の分野での最新の研究は、大規模な言語モデル(LLM)と人間の脳構造の驚くべき類似性を明らかにしています。 LLMの活性化空間の詳細な分析を通じて、MITの科学者は、その内部構造が人間の脳のミクロ、メソ、マクロレベルと有意な対応を持っていることを発見しました。この発見は、AIがどのように機能するかを理解するための新しい視点を提供するだけでなく、よりスマートなAIシステムの将来の発展のための基盤を置いています。

AIは実際に「あなたの脳を成長させ始めました」!

この研究では、スパースオートエンコーダーテクノロジーを使用して、LLMの活性化空間の詳細な分析を実施し、3つのレベルの構造特性を発見しました。

まず、顕微鏡レベルで、研究者は「結晶」構造の存在を発見しました。これらの「クリスタル」の顔は、「男:女性:王:女王」などのおなじみの語彙の類推に似た、平行四辺形または台形で構成されています。

さらに驚くべきことは、これらの「結晶」構造が、線形判別分析技術を通じていくつかの無関係な干渉因子(単語の長さなど)を除去した後に明確になることです。

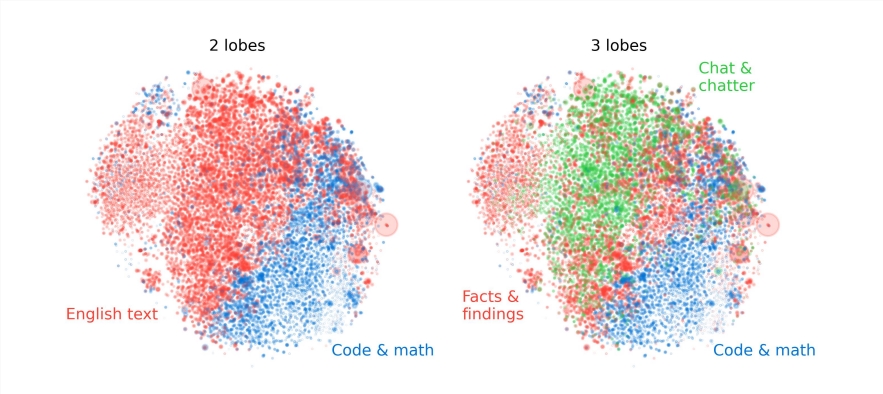

第二に、メソレベルで、研究者は、LLMの活性化空間が人間の脳の機能的分配と同様のモジュール構造を持っていることを発見しました。

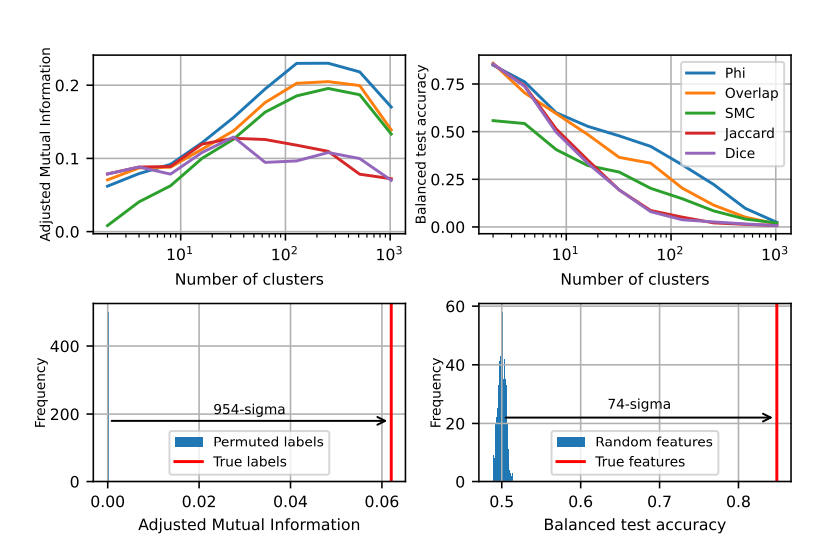

たとえば、数学とコードに関連する特徴が集まって、人間の脳の機能的な葉に似た「脳葉」を形成します。複数の指標による定量分析を通じて、研究者はこれらの「脳葉」の空間的局所性を確認しました。これは、共起機能もより空間的に濃縮されており、ランダム分布の期待をはるかに超えていることを示しています。

マクロレベルでは、研究者は、LLM特徴点クラウドの全体的な構造が等方性ではないが、電力法の固有値分布を示しており、この分布は中間層で最も明白であることを発見しました。

研究者はまた、さまざまなレベルでクラスタリングエントロピーを定量化し、中間層のクラスタリングエントロピーが低いことを発見し、特徴表現がより濃縮された一方で、初期層と後期層のクラスタリングエントロピーが高く、特徴表現が高いことを示しています。より分散しました。

この研究は、大規模な言語モデルの内部メカニズムを理解するための新しい視点を提供し、より強力でよりスマートなAIシステムの将来の発展のための基礎を築きます。

この研究は、AIと人間の脳の類似性を明らかにするだけでなく、AIテクノロジーの将来の開発のための新しい方向性を提供し、AIがよりスマートで効率的になることを示しています。