マルチモーダル大手言語モデル(MLLM)の急速な発展に伴い、画像関連のタスクは、特に視覚的な質問と回答、物語の生成、インタラクティブな編集の分野で、前例のないブレークスルーを案内しています。ただし、これらのテクノロジーの大幅な進歩にもかかわらず、きめ細かいビデオコンテンツの理解を達成することは、解決するのが難しい問題のままです。この課題には、言語の説明を使用したピクセルレベルのセグメンテーションと追跡だけでなく、特定のビデオプロンプトのビジュアルQ&Aなどの複雑なタスクも含まれます。

現在の最先端のビデオ認識モデルは、セグメンテーションおよび追跡タスクでうまく機能しますが、オープン言語の理解と対話機能にはまだ不十分です。ビデオMLLMSは、ビデオの理解とQ&Aタスクでうまく機能しますが、知覚タスクや視覚的な手がかりを処理することはできません。この制限により、より広い範囲のシナリオでの使用が制限されます。

既存のソリューションは、主にマルチモーダル大手言語モデル(MLLM)と参照セグメンテーションシステムの2つのカテゴリに分かれています。 MLLMSは当初、マルチモーダル融合法と特徴抽出器の改善に焦点を合わせ、LLAVAなどのLLMSでの指導チューニングのフレームワークに徐々に発展しました。最近、研究者は、Llava-Onevisionなどの画像、ビデオ、マルチイメージ分析を統合しようとしました。同時に、参照セグメンテーションシステムは、基本的な融合モジュールから統合されたセグメンテーションと追跡への変換も受けています。ただし、これらのソリューションには、知覚と言語理解能力の包括的な統合にはまだ欠点があります。

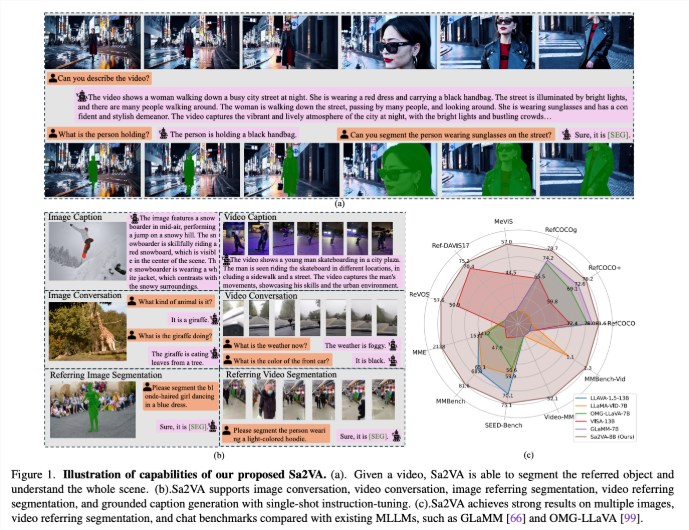

UC Merced、Bytedance Seed Team、Wuhan University、Peking Universityの研究者は、画像やビデオの集中的な基本的な理解を達成するために設計された画期的な統一モデルであるSA2VAを提案しました。このモデルは、1回限りの命令の調整を最小限に抑え、幅広い画像およびビデオタスクをサポートすることにより、既存のマルチモーダル大手言語モデルの制限を克服します。

SA2VAは、SAM-2をLlavaと革新的に統合して、テキスト、画像、ビデオを共有LLMトークンスペースに統合します。さらに、研究者は、72Kを超える複雑なビデオシナリオにオブジェクト式を含むREF-SAVと呼ばれる広範な自動アノテーションデータセットを開始しました。

SA2VAのアーキテクチャは、主にLlavaとSAM-2に似たモデルの2つの部分で構成されており、新しいデカップリングデザインを採用しています。 LLAVAのようなコンポーネントには、画像とビデオを処理する視覚エンコーダー、視覚投影レイヤー、およびテキストトークン予測用のLLMが含まれています。このシステムは、SAM-2が直接トークン交換なしで事前に訓練されたLLAVAモデルの隣で動作できるようにする一意のデカップリング方法を採用しているため、計算効率を維持し、さまざまな事前にトレーニングされたMLLMS接続でプラグインとプラグを解除できます。

研究結果は、SA2VAが引用セグメンテーションタスクで最先端の結果を達成したことを示しています。SA2VA-8Bモデルは、それぞれglamm-7bなどの以前のシステムを上回っています。対話能力の観点から、SA2VAは、それぞれMME、MMBench、および種子ベンチで2128、81.6、および75.1の優れた結果を達成しました。

さらに、ビデオベンチマークでのSA2VAのパフォーマンスは、前の状態であるOF-The-ART Visa-13Bを大幅に上回り、画像およびビデオ理解タスクにおける効率と有効性を示しています。

論文:https://arxiv.org/abs/2501.04001

モデル:https://huggingface.co/collections/bytedance/sa2va-model-zoo-677e3084d71b5f108d00e093

キーポイント:

SA2VAは、画像やビデオの詳細な理解を達成し、既存のマルチモーダルモデルの制限を克服する新しい統一されたAIフレームワークです。

このモデルは、引用セグメンテーションや対話機能など、いくつかのベンチマークで最先端の結果を達成し、優れたパフォーマンスを示しています。

SA2VAの設計は、デカップリング方法を通じて視覚と言語の理解機能を効果的に統合し、幅広い画像およびビデオタスクをサポートします。