人工知能技術の急速な発展に伴い、大手言語モデル(LLM)は、最新のアプリケーションでますます重要な役割を果たしています。チャットボット、コードジェネレーター、その他の自然言語処理ベースのタスクであろうと、LLMの機能がコアドライバーになりました。ただし、モデルスケールの継続的な拡大と複雑さの増加により、特に大規模なデータと複雑な計算を処理し、解決する必要があるボトルネックになる場合、推論プロセスの効率の問題が徐々に顕著になりました。緊急に。

LLMのコアコンポーネントとして、注意メカニズムはモデルの推論効率に直接影響します。ただし、FlashattentionやSparseattentionなどの従来の注意メカニズムは、多様なワークロード、動的入力モード、GPUリソースの制約に直面した場合、しばしばパフォーマンスが低下します。高いレイテンシ、メモリボトルネック、および低リソースの使用率により、LLM推論のスケーラビリティと応答速度が深刻に制限されています。したがって、効率的で柔軟なソリューションを開発することは、現在の研究の焦点となっています。

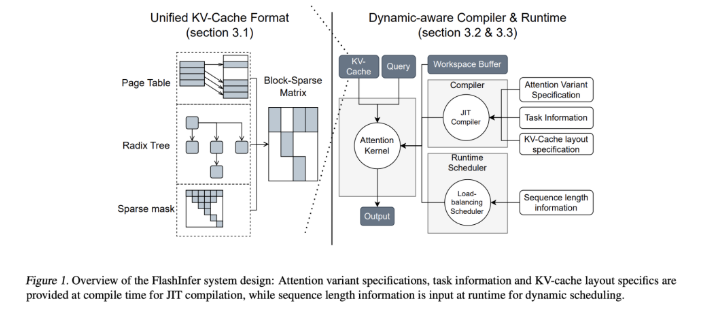

この課題に対処するために、ワシントン大学Nvidia、Perplexity AI、Carnegie Mellon Universityの研究チームは共同でFlashinferを開発しました。これは、LLM Reasoning専用に設計された人工知能ライブラリおよびカーネルジェネレーターであり、フラッシュアット、スパルティーチメント、ページェント、および高性能GPUコアを介したサンプリングなど、複数の注意メカニズムを最適化するように設計されています。 Flashinferの設計哲学は、柔軟性と効率性を強調し、LLM推論サービスの重要な課題に効果的に対応し、大規模な言語モデルで推論するための実用的なソリューションを提供します。

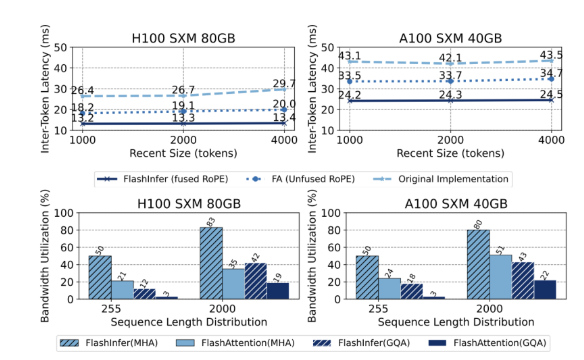

FlashInferのコアの技術的特徴には、次の側面が含まれます。まず、包括的な注意カーネルサポートを提供し、充填前、デコード、追加の注意などのさまざまなメカニズムをカバーし、シングルラインを大幅に改善します。リクエストおよびバッチサービスシナリオのパフォーマンス。第二に、グループ化されたクエリの注意(GQA)および融合した回転位置埋め込み(ロープ)の注意を通じて、FlashInferは、VLLMのページの注意の31倍速い長いプロンプトデコードで大幅なパフォーマンスの改善を達成します。さらに、FlashInferの動的負荷バランシングスケジューラは、入力の変更に応じて動的に調整し、GPUのアイドル時間を短縮し、リソースの効率的な使用を確保できます。 CUDAグラフとの互換性は、生産環境での適用性をさらに高めます。

パフォーマンスに関しては、FlashInferは、特に長いコンテキストの推論と並列生成タスクを扱う場合、複数のベンチマークでうまく機能し、遅延を大幅に削減します。 NVIDIA H100 GPUでは、FlashInferは並列生成タスクで13〜17%の速度向上を達成します。その動的なスケジューラと最適化されたコアは、帯域幅とフロップの使用率を大幅に改善し、不均一または均一なシーケンスの長さであろうとGPUリソースの効率的な利用を可能にします。これらの利点により、FlashinferはLLMサービスフレームワークの開発を促進するための重要なツールになります。

Open Sourceプロジェクトとして、FlashinferはLLMの推論の課題に効率的なソリューションを提供するだけでなく、研究コミュニティのさらなるコラボレーションとイノベーションを促進します。その柔軟な設計と統合機能により、AIインフラストラクチャのニーズの変化に適応し、新たな課題に対処する上でリーダーシップを上げることができます。 Open Sourceコミュニティの共同の努力を通じて、FlashInferはAIテクノロジーの将来の開発においてより重要な役割を果たすことが期待されています。

プロジェクトの入り口:https://github.com/flashinfer-ai/flashinfer

キーポイント:

FlashInferは、大規模な言語モデルの推論用に設計された新たにリリースされた人工知能ライブラリであり、効率を大幅に改善できます。

このライブラリは、複数の注意メカニズムをサポートし、GPUリソースの利用を最適化し、推論の遅延を減らします。

Open Sourceプロジェクトとして、Flashinferは研究者がAIインフラストラクチャの革新と開発を促進するために参加することを歓迎します。