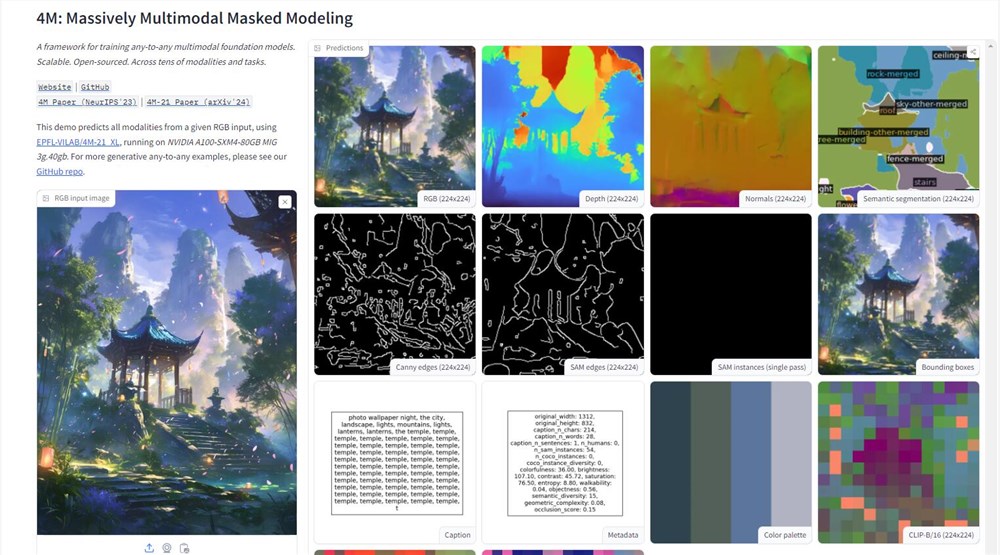

Appleは人工知能の分野で重要な一歩を踏み出し、抱き合っているフェイスプラットフォームで4Mモデルのデモンストレーションを明らかにしました。このマルチモーダルAIモデルは、テキスト、画像、3Dシーンなどのさまざまなデータ型を処理し、強力な情報処理機能を実証できます。画像をアップロードすることにより、ユーザーは、AppleのAIテクノロジーアプリケーションの大きなブレークスルーをマークする画像の深さマップ、ライン図面などの詳細情報を簡単に取得できます。

4Mモデルの技術的コアは、「大規模なマルチモーダルシールドモデリング」トレーニング方法にあります。この方法により、モデルは複数の視覚モダリティを同時に処理し、画像、セマンティック、幾何学的情報を統合トークンに変換し、それにより異なるモダリティ間のシームレスな接続を実現できます。この設計により、モデルの汎用性が向上するだけでなく、将来のマルチモーダルAIアプリケーションの新しい可能性も開きます。

Appleの動きは、R&D分野での一貫した機密性の伝統を破り、オープンソースのAIプラットフォームでの技術的強さを積極的に実証しました。 4Mモデルを開くことで、AppleはAIテクノロジーの高度な性質を実証するだけでなく、オリーブの枝を開発者コミュニティに拡張し、4M前後の繁栄した生態系を構築することを望んでいます。これは、よりスマートなSiriやより効率的なFinal Cut Proなど、Appleエコシステムでよりインテリジェントなアプリケーションの可能性を告げます。

ただし、4Mモデルの発売は、データプラクティスとAI倫理の課題ももたらしました。データ集約的なAIモデルとして、技術の進歩を促進しながらユーザーのプライバシーを保護する方法は、Appleが真剣に検討する必要がある問題になります。 Appleは常にこの課題に直面しているユーザーのプライバシー保護者と見なしてきました。

トレーニング方法に関しては、4Mは革新的なランダムに選択されたマーキング方法を採用しています。マーキングの一部を入力として、もう1つの部分をターゲットとして採用し、それによってトレーニングターゲットのスケーラビリティを実現します。この設計により、4Mは写真とテキストの両方をデジタルマーカーとして扱うことができ、モデルの柔軟性と適応性を大幅に改善できます。

4Mモデルのトレーニングデータは、世界最大のオープンソースデータセットの1つであるCC12Mからのものです。このデータセットにはデータが豊富ですが、ラベル情報は完全ではありません。この問題を解決するために、研究者は弱い監視された擬似ラベル法を採用し、使用したクリップ、MaskRCNN、およびその他の技術を使用してデータセットを包括的に予測し、予測結果をトークンに変換し、4Mのマルチモーダル互換性の強固な基礎を築きました。

広範な実験とテストの後、4Mは、特定のタスクの多数のトレーニングまたは微調整を必要とせずにマルチモーダルタスクを直接実行できることを証明しています。それは、AIにマルチモーダルのスイスアーミーナイフを与えるようなもので、さまざまな課題に柔軟に対処できるようになります。 4Mの発売は、AIの分野でのAppleの技術的強さを示しているだけでなく、AIアプリケーションの将来の開発の方向性も指摘しています。

デモアドレス:https://huggingface.co/spaces/epfl-vilab/4m