이것은 "Laang 우리는이 주제에 관심이있는 NLP 연구원들이 논문을 추가하거나 업데이트하도록 요청하도록 권장합니다 (기여 참조). 최신 업데이트를 보려면이 저장소를 시청하십시오!

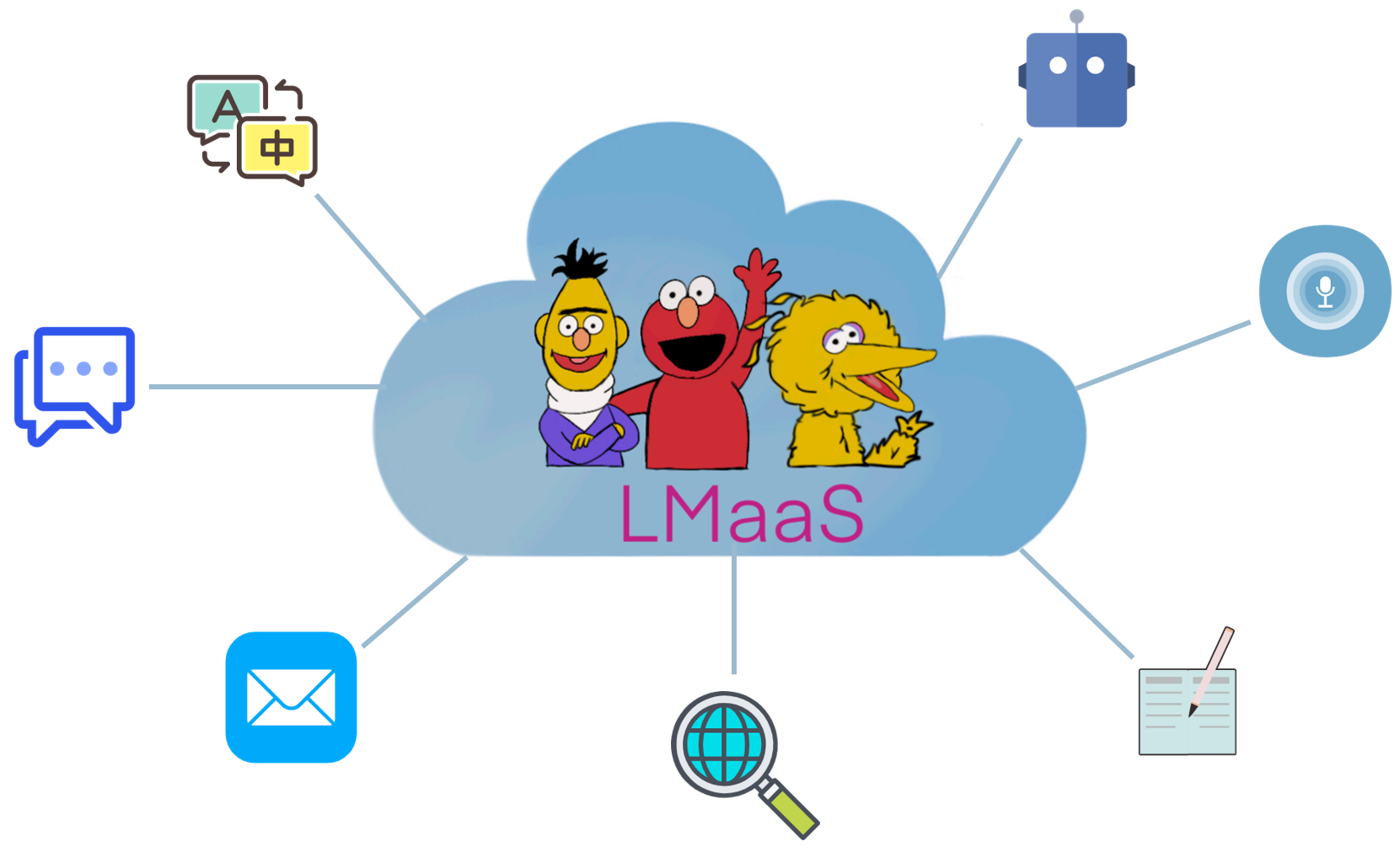

상업적인 이유와 고가의 튜닝 비용으로 인해 GPT-3과 같은 미리 훈련 된 대형 언어 모델 (LLM)은 일반적으로 오픈 소싱 모델 가중치 대신 서비스로 출시됩니다. 우리는이 시나리오를 " LANGUAGE-MODEL-as-A-SERVICE (LMAAS) "라고 부릅니다 (이 용어는 원래 ICML'2022 용지에서 사용됩니다). 이러한 시나리오에서 사용자는 추론 API를 통해 강력한 LLM에 액세스 할 수 있습니다. LLMS의 서비스는 많은 사용 사례에 힘을 발휘했습니다 (GPT-3 데모 참조). 미세 조정과 달리 LMAA는 단일 범용 LLM이 많은 차이 작업을 수행 할 수있게하므로 배포 효율이 높습니다. 그럼에도 불구하고, 매개 변수 및 그라디언트에 대한 액세스없이 작업을 대상으로 LLM을 조정하는 방법은 어려운 일입니다. LLM이 더 많은 청중에게 도움이되도록하기 위해, 우리는이 시나리오에 맞는 논문을 수집하여 향후 연구를 촉진합니다.

LMAA의 시나리오에 어떤 논문이 적합합니까? 우리는 주로 모델 매개 변수와 그라디언트에 액세스하지 않고 LLM을 다운 스트림 작업에 적응시키는 논문을 고려합니다. 미세 조정 된 LLM은 배포 후 서비스가 될 수 있지만 제한된 잠재 고객을위한 단일 작업을 해결하도록 제한됩니다. 우리의 범위에서 우리는 다양한 사용자를위한 범용 모델을 선호합니다.

기존 문헌에는 LMAA에 맞는 몇 가지 연구가 있습니다.

텍스트 프롬프트 와 텍스트 내 학습 간의 경계는 약간 흐려집니다. 이 repo에서 텍스트 프롬프트 카테고리에는 라벨이 붙은 샘플을 사용하지 않는 논문이 포함되어 있으며, 텍스트 내 학습 범주는 프롬프트에 레이블이있는 샘플을 포함하는 논문으로 구성됩니다.

참고 : 관련 (및 부분적으로 중복 된) 주제는 프롬프트 기반 학습 이며, 이는 각각 일부 템플릿 및 구두화로 입력 및 출력을 변환하여 범용 LLM을 사용하여 다운 스트림 작업을 해결하는 것을 목표로합니다. 그러나 프롬프트 기반 학습에서 대부분의 작업에는 모델 매개 변수 및 기울기에 대한 액세스가 필요하므로 범위에 맞지 않습니다. LMAA에 적합하지 않은 프롬프트 기반 학습 논문의 경우 또 다른 멋진 종이 목록 인 Prustpaper에 기여하는 것이 좋습니다.

미세 조정 작업 별 LLM과 비교할 때 LMAA는 다음과 같은 장점이 있습니다.

작업의 약어.

작업의 주요 특징.

작업의 주요 실험 설정.

지식 기반으로 언어 모델? EMNLP 2019

Fabio Petroni, Tim Rocktäschel, Patrick Lewis, Anton Bakhtin, Yuxiang Wu, Alexander H. Miller, Sebastian Riedel . [PDF] [코드]

언어 모델이 무엇을 알고 있는지 어떻게 알 수 있습니까? TACL 2020

Zhengbao Jiang, Frank F. Xu, Jun Araki, Graham Neubig . [PDF] [코드]

언어 모델은 소수의 학습자입니다. Neurips 2020

Tom B. Brown, Benjamin Mann, Nick Ryder, Melanie Subbiah, Jared Kaplan, Prafulla Dhariwal, Arvind Neelakantan, Pranav Shyam, Girish Sastry, Amanda Askell, Sandhini Agarwal, Ariel Herbert-Voss, Gretchen Krueger, Tom Henighan, Tom Henighan Ramesh, Daniel M. Ziegler, Jeffrey Wu, Clemens Winter, Christopher Hesse, Mark Chen, Eric Sigler, Mateusz Litwin, Scott Grey, Benjamin Chess, Jack Clark, Christopher Berner, Sam McCandlish, Alec Radford, Ilya Sutskever, Dario Amodei . [PDF]

데이터 세트 및 프롬프트 컬렉션에 대한 메타 조정으로 제로 샷 학습을위한 언어 모델을 조정합니다 . EMNLP 2021의 발견

Ruiqi Zhong, Kristy Lee, Zheng Zhang, Dan Klein . [PDF] [코드]

Finetuned Language 모델은 제로 샷 학습자입니다 . ICLR 2022

Jason Wei, Maarten Bosma, Vincent Y. Zhao, Kelvin Guu, Adams Wei Yu, Brian Lester, Nan du, Andrew M. Dai, Quoc V. Le . [PDF] [코드]

멀티 태스킹 프롬프트 교육은 제로 샷 작업 일반화를 가능하게합니다 . ICLR 2022

Victor Sanh, Albert Webson, Colin Raffel, Stephen H. Bach, Lintang Sutawika, Zaid Alyafeai, Antoine Chaffin, Arnaud Stiegler, Teven Le Scao, Arun Raja, Manan Dey, M Saiful Bari, Canwen Xu, Umish Thakker, Shanya Sharma, Eliza Szczechla, Taewoon Kim, Gunjan Chhablani, Nihal Nayak, Debajyoti Datta, Jonathan Chang, Mike Tian-Jian Jiang, Han Wang, Matteo Manica, Sheng Shen, Zheng Xin Yong, Harshit Pandey, Rachel Bawden, Thomas Wang, Trishala Neeraj, Jossho Rozen. , Andrea Santilli, Thibault Fevry, Jason Alan Fries, Ryan Teehan, Tali Bers, Stella Biderman, Leo Gao, Thomas Wolf, Alexander M. Rush . [PDF] [코드]

인간의 피드백으로 지침을 따르는 언어 모델 . 프리 프린트 2022.3

Long Ouyang, Jeff Wu, Xu Jiang, Diogo Almeida, Carroll L. Wainwright, Pamela Mishkin, Chong Zhang, Sandhini Agarwal, Katarina Slama, Alex Ray, John Schulman, Jacob Hilton, Fraser Kelton, Luke Miller, Maddie Simens, Amanda Askell, Amanda Askell. Peter Welinder, Paul Christiano, Jan Leike, Ryan 로우 . [PDF] [코드]

큰 언어 모델은 제로 샷 추론 자입니다 . 프리 프린트 2022.6

Takeshi Kojima, Shixiang Shane Gu, Machel Reid, Yutaka Matsuo, Yusuke Iwasawa . [PDF] [코드]

얼어 붙은 양방향 언어 모델을 통한 제로 샷 비디오 질문 . 프리 프린트 2022.6

Antoine Yang, Antoine Miech, Josef Sivic, Ivan Laptev, Cordelia Schmid . [PDF] [코드]

언어 모델은 일반적인 목적 인터페이스입니다 . 프리 프린트 2022.6

Yaru Hao, Haoyu Song, Li Dong, Shaohan Huang, Zewen Chi, Wenhui Wang, Shuming Ma, Furu Wei . [PDF] [코드]

대형 언어 코드 모델에 대한 저장소 레벨 프롬프트 생성. 프리 프린트 2022.6

Disha Shrivastava, Hugo Larochelle, Daniel Tarlow [PDF] [Code], 2022.6

이전 프롬프트를 무시하십시오 : 언어 모델의 공격 기술. 최고의 종이 상 @ Neurips ML 안전 워크숍 2022.

Fábio Perez, Ian Ribeiro [PDF] [Project], 2022.11

언어 모델은 소수의 학습자입니다. Neurips 2020

Tom B. Brown, Benjamin Mann, Nick Ryder, Melanie Subbiah, Jared Kaplan, Prafulla Dhariwal, Arvind Neelakantan, Pranav Shyam, Girish Sastry, Amanda Askell, Sandhini Agarwal, Ariel Herbert-Voss, Gretchen Krueger, Tom Henighan, Tom Henighan Ramesh, Daniel M. Ziegler, Jeffrey Wu, Clemens Winter, Christopher Hesse, Mark Chen, Eric Sigler, Mateusz Litwin, Scott Grey, Benjamin Chess, Jack Clark, Christopher Berner, Sam McCandlish, Alec Radford, Ilya Sutskever, Dario Amodei . [PDF]

사용하기 전에 교정 : 언어 모델의 소수의 성능 향상 . ICML 2021

Tony Z. Zhao, Eric Wallace, Shi Feng, Dan Klein, Sameer Singh . [PDF] [코드]

암시 적 베이지안 추론으로서 텍스트 내 학습에 대한 설명 . ICLR 2022

Michael Xie, Aditi Raghunathan, Percy Liang, Tengyu MA . [PDF] [코드]

사고의 사슬은 큰 언어 모델에서 추론을 유도합니다 . 프리 프린트 2022.1

Jason Wei, Xuezhi Wang, Dale Schuurmans, Maarten Bosma, Brian Ichter, Fei Xia, Ed Chi, Quoc Le, Denny Zhou . [PDF]

자연어 크라우드 소싱 지침을 통한 교차 작업 일반화 . ACL 2022

Swaroop Mishra, Daniel Khashabi, Chitta Baral, Hannaneh Hajishirzi . [PDF] [코드]

환상적으로 주문한 프롬프트와 찾을 수있는 곳 : 소수의 프롬프트 순서 민감도 극복 . ACL 2022

Yao Lu, Max Bartolo, Alastair Moore, Sebastian Riede, Pontus Stenetorp . [PDF]

소수의 샷 텍스트 분류를위한 시끄러운 채널 언어 모델 . ACL 2022

Sewon Min, Mike Lewis, Hannaneh Hajishirzi, Luke Zettlemoyer . [PDF] [코드]

언어 모델 내 텍스트 튜닝을 통한 메타 학습 . ACL 2022

Yanda Chen, Ruiqi Zhong, Sheng Zha, George Karypis . [PDF] [코드]

GPT-3에 대한 좋은 컨텍스트 예제는 무엇입니까? Deelio@ACL 2022

Jiachang Liu, Dinghan Shen, Yizhe Zhang, Bill Dolan, Lawrence Carin, Weizhu Chen . [PDF]

텍스트 내 학습을위한 프롬프트를 검색하는 법 학습 . NAACL 2022

Ohad Rubin, Jonathan Herzig, Jonathan Berant . [PDF] [코드]

Metaicl : 맥락에서 배우는 법을 배우는 것 . NAACL 2022

Sewon Min, Mike Lewis, Luke Zettlemoyer, Hannaneh Hajishirzi . [PDF] [코드]

자체 감독 훈련을 통해 텍스트에서 몇 가지 샷 학습을 향상시킵니다 . NAACL 2022

Mingda Chen, Jingfei du, Ramakanth Pasunuru, Todor Mihaylov, Srini Iyer, Veselin Stoyanov, Zornitsa Kozareva . [PDF]

자체 생성 텍스트 내 학습 : 시연 생성기로서 자동 복귀 언어 모델을 활용합니다 . LPLM@NAACL 2022

Hyuhng Joon Kim, Hyunsoo Cho, Junyeob Kim, Taeuk Kim, Kang Min Yoo, Sang-Goo Lee . [PDF]

시연의 역할 재고 : 텍스트 내 학습이 효과가있는 것은 무엇입니까? 프리 프린트 2022.2

Sewon Min, Xinxi Lyu, Ari Holtzman, Mikel Artetxe, Mike Lewis, Hannaneh Hajishirzi, Luke Zettlemoyer . [PDF] [코드]

소수의 대화 상태 추적에 대한 텍스트 내 학습. 프리 프린트 2022.3

Yushi Hu, Chia-Hsuan Lee, Tianbao Xie, Tao Yu, Noah A. Smith, Mari Ostendorf . [PDF] [코드]

자기 일관성은 언어 모델에서 사고 추론의 사슬을 향상시킵니다 . 프리 프린트 2022.3

Xuezhi Wang, Jason Wei, Dale Schuurmans, Quoc LE, Ed Chi, Denny Zhou . [PDF]

스타 : 추론을 가진 스스로 가르치는 추론을 부트 스트랩 추론 . 프리 프린트 2022.3

Eric Zelikman, Yuhuai Wu, Noah D. Goodman . [PDF]

1,600 개 이상의 언어 작업에 대한 텍스트 내 지침을 통한 일반화 벤치마킹 일반화 . 프리 프린트 2022.4

Yizhong Wang, Swaroop Mishra, Pegah Alipoormolabashi, Yeganeh Kordi, Amirreza Mirzaei, Anjana Arunkumar, Arjun Ashok, Arut Selvan Dhanasekaran, Atharva Naik, David Stap, Eshaan Pathak, Giannis Karamanolakis Ishani Mondal, Jacob Anderson, Kirby Kuznia, Krima Doshi, Maitreya Patel, Kuntal Kumar Pal, Mehrad Moradshahi, Mihir Parmar, Mirali Purohit, Neeraj Varshney, Phani Rohitha Kaza, Pulkit Verma, Ravhaj Singhaj Singhaj Singhaj Sampat, Savan Doshi, Siddhartha Mishra, Sujan Reddy, Sumanta Patro, Tanay Dixit, Xudong Shen, Chitta Baral, Yejin Choi, Noah A. Smith, Hannaneh Hajishirzi, Daniel Khashabi . [PDF] [코드]

언어 모델이 맥락에서 설명에서 배울 수 있습니까? . 프리 프린트 2022.4

Andrew K. Lampinen, Ishita Dasgupta, Stephanie Cy Chan, Kory Matthewson, Michael Henry Tessler, Antonia Creswell, James L. McClelland, Jane X. Wang, Felix Hill . [PDF]

그라운드 진실 레이블 문제 : 입력 라벨 시연을 심층적으로 살펴 봅니다 . 프리 프린트 2022.5

Junyeob Kim, Hyuhng Joon Kim, Hyunsoo Cho, Hwiyeol Jo, Sang-woo Lee, Sang-Goo Lee, Kang Min Yoo, Taeuk Kim . [PDF]

소수의 컨텍스트 학습에서 설명의 신뢰성 . 프리 프린트 2022.5

Xi Ye, Greg Durrett . [PDF]

가장 큰 프롬프트는 대형 언어 모델에서 복잡한 추론을 가능하게합니다 . 프리 프린트 2022.5

Denny Zhou, Nathanael Schärli, Le Hou, Jason Wei, Nathan Scales, Xuezhi Wang, Dale Schuurmans, Olivier Bousquet, Quoc Le, Ed Chi . [PDF]

Maieutic Prompting : 재귀적인 설명을 가진 논리적으로 일관된 추론 . 프리 프린트 2022.5

Jaehun Jung, Lianhui Qin, Sean Welleck, Faeze Brahman, Chandra Bhagavatula, Ronan Le Bras, Yejin Choi . [PDF]

언어 모델을 더 나은 추론 자로 만드는 발전 . 프리 프린트 2022.6

Yifei Li, Zeqi Lin, Shizhuo Zhang, Qiang Fu, Bei Chen, Jian-Guang Lou, Weizhu Chen . [PDF] [코드]

큰 언어 모델의 출현 능력 . 프리 프린트 2022.6

Jason Wei, Yi Tay, Rishi Bommasani, Colin Raffel, Barret Zoph, Sebastian Borgeaud, Dani Yogatama, Maarten Bosma, Denny Zhou, Donald Metzler, Ed H. Chi, Tatsunori Hashimoto, Oriol Vinyals, Percy Liang, Jeff Dean, Will DeAndus . [PDF]

언어 모델은 일반적인 목적 인터페이스입니다 . 프리 프린트 2022.6

Yaru Hao, Haoyu Song, Li Dong, Shaohan Huang, Zewen Chi, Wenhui Wang, Shuming Ma, Furu Wei . [PDF] [코드]

변압기는 텍스트에서 무엇을 배울 수 있습니까? 간단한 기능 수업에 대한 사례 연구 . 프리 프린트 2022.8

Shivam Garg, Dimitris Tsipras, Percy Liang, Gregory Valiant . [PDF] [코드]

증류 컨텍스트를 통해 학습 . 프리 프린트 2022.9

Charlie Snell, Dan Klein, Ruiqi Zhong . [PDF]

기호 언어로 언어 모델을 바인딩합니다 . 프리 프린트 2022.10

Zhoujun Cheng*, Tianbao Xie*, Peng Shi, Chengzu Li, Rahul Nadkarni, Yushi Hu, Caiming Xiong, Dragomir Radev, Mari Ostendorf, Luke Zettlemoyer, Noah A. Smith, Tao Yu . [PDF] [코드] [웹 사이트]

대형 언어 모델 미세 조정에서 텍스트 내 학습 능력을 보존합니다 . 프리 프린트 2022.11

Yihan Wang, Si SI, Daliang Li, Michal Lukasik, Felix Yu, Cho-Jui Hsieh, Inderjit S Dhillon, Sanjiv Kumar . [PDF]

텍스트 내 학습을 통한 알고리즘 추론 교육 . 프리 프린트 2022.11

Hattie Zhou, Azade Nova, Hugo Larochelle, Aaron Courville, Behnam Neyshabur, Hanie Sedghi . [PDF]

텍스트 내 학습은 어떤 학습 알고리즘입니까? 선형 모델에 대한 조사 . 프리 프린트 2022.11

Ekin Akyürek, Dale Schuurmans, Jacob Andreas, Tengyu MA, Denny Zhou . [PDF]

언어 모델을위한 블랙 박스 튜닝 . ICML 2022

Tianxiang Sun, Yunfan Shao, Hong Qian, Xuanjing Huang, Xipeng Qiu. [PDF] [코드]

미리 훈련 된 언어 모델에 대한 블랙 박스 프롬프트 학습 . TMLR 2023.2

Shizhe Diao, Xuechun Li, Yong Lin, Zhichao Huang, Tong Zhang . [PDF]

그립 : 대형 언어 모델을 유발하기위한 그라디언트가없는 편집 기반 명령 검색 . 프리 프린트 2022.3

Archiki Prasad, Peter Hase, Xiang Zhou, Mohit Bansal . [PDF] [코드]

제어 가능한 응답 생성을 향한 소수의 샷 . 프리 프린트 2022.6

Hsuan SU, Pohan Chi, Shih-Cheng Huang, Chung Ho Lam, Saurav Sahay, Shang-Tse Chen, Hung-Yi Lee . [PDF]

BBTV2 : 큰 언어 모델을 가진 그라디언트가없는 미래를 향해 . EMNLP 2022

Tianxiang Sun, Zhengfu HE, Hong Qian, Yunhua Zhou, Xuanjing Huang, Xipeng Qiu . [PDF] [코드]

RLPROMPT : 강화 학습으로 개별 텍스트 프롬프트 최적화 . EMNLP 2022

Mingkai Deng, Jianyu Wang, Cheng-Ping Hsieh, Yihan Wang, Han Guo, Tianmin Shu, Meng Song, Eric P. Xing, Zhiting Hu . [PDF] [코드]

클립 조정 : 보상이 혼합 된 파생 된 프롬프트 학습을 향해 . EMNLP 2022의 발견

Yekun Chai, Shuohuan Wang, Yu Sun, Hao Tian, Hua Wu, Haifeng Wang . [PDF]

온도 : 강화 학습을 통한 테스트 시간 프롬프트 편집 . 프리 프린트 2022.11

Tianjun Zhang, Xuezhi Wang, Denny Zhou, Dale Schuurmans, Joseph E. Gonzalez. [PDF] [코드]

프롬프트 부스트 : 10 개의 포워드 패스가있는 블랙 박스 텍스트 분류 . 프리 프린트 2022.12

Bairu Hou, Joe O'Connor, Jacob Andreas, Shiyu Chang, Yang Zhang . [PDF]

중국 몇 샷 학습을위한 모듈 식 프롬프트의 멀티 태스킹 사전 훈련 . ACL 2023

Tianxiang Sun, Zhengfu HE, Qin Zhu, Xipeng Qiu, Xuanjing Huang . [PDF]

그라디언트 하강이 파생 상자 최적화를 충족시킬 때 : 블랙 박스 시나리오에서 만들어진 일치 . ACL 2023

Chengcheng Han, Liqing Cui, Renyu Zhu, Jianing Wang, Nuo Chen, Qiushi Sun, Xiang Li, Ming Gao . [PDF]

프롬프트 기반 블랙 박스 튜닝 화려 : 세 가지 직교 관점에서 모델 일반화를 향상시킵니다 . LREC-Coling 2024

Qiushi Sun, Chengcheng Han, Nuo Chen, Renyu Zhu, Jingyang Gong, Xiang Li, Ming Gao . [PDF]

조정하거나 조정하지 않으려면? 사전 예방 적 표현을 다양한 작업에 적용합니다 . REPL4NLP@ACL 2019

Matthew E. Peters, Sebastian Ruder, Noah A. Smith . [PDF]

설명이 블랙 박스 모델을 교정하는 데 유용 할 수 있습니까? ACL 2022

Xi Ye, Greg Durrett . [PDF] [코드]

공동 훈련은 대형 언어 모델에 대한 신속한 학습을 향상시킵니다 . ICML 2022

헌터 랭, 모니카 아그라 왈, 윤 킴, 데이비드 Sontag . [PDF]

Y-Tuning : 라벨 표현 학습을 통한 대규모 미리 훈련 된 모델을위한 효율적인 튜닝 패러다임 . 프리 프린트 2022.2

Yitao Liu, Chenxin AN, Xipeng Qiu . [PDF]

LST : 매개 변수 및 메모리 효율적인 전송 학습을위한 사다리 측정 . Neurips 2022

Yi-Lin Sung, Jaemin Cho, Mohit Bansal . [PDF] [코드]

디코더 튜닝 : 디코딩으로서의 효율적인 언어 이해 . 프리 프린트 2022.12

Ganqu Cui, Wentao Li, Ning Ding, Longtao Huang, Zhiyuan Liu, Maosong Sun. [PDF]

사전에 미리 언어 모델로 데이터 세트를 생성합니다 . EMNLP 2021

Timo Schick, Hinrich Schütze . [PDF] [코드]

GPT3MIX : 텍스트 확대를 위해 대규모 언어 모델을 활용합니다 . EMNLP 2021의 발견

Kang Min Yoo, Dongju Park, Jaewook Kang, Sang-woo Lee, Woomyeong Park . [PDF] [코드]

상식 추론을위한 지식이 발생했습니다 . ACL 2022

Jiacheng Liu, Alisa Liu, Ximing Lu, Sean Welleck, Peter West, Ronan Le Bras, Yejin Choi, Hannaneh Hajishirzi . [PDF] [코드]

0은 데이터 세트 생성을 통한 효율적인 제로 샷 학습 . EMNLP 2022

Jiacheng Ye, Jiahui Gao, Qintong Li, Hang Xu, Jiangtao Feng, Zhiyong Wu, Tao Yu, Lingpeng Kong . [PDF] [코드]

Zerogen+: 효율적인 제로 샷 학습에서 셀프 가이드 고품질 데이터 생성 . 프리 프린트 2022.2

Jiahui Gao, Renjie PI, Yong Lin, Hang Xu, Jiacheng Ye, Zhiyong Wu, Xiaodan Liang, Zhenguo Li, Lingpeng Kong . [PDF]

Augesc : 정서적 지원 대화를위한 큰 언어 모델로 대화 확대 . ACL 2023의 결과

Chujie Zheng, Sahand Sabour, Jiaxin Wen, Zheng Zhang, Minlie Huang . [PDF]

언어 모델로 교육 데이터 생성 : 제로 샷 언어 이해를 향해 . Neurips 2022

Yu Meng, Jiaxin Huang, Yu Zhang, Jiawei Han [PDF] [코드]

?? 우선, 시간을내어 기여해 주셔서 감사합니다! ??

기여하기위한 단계 :

PaperNumber 수정하고 풀 요청을 제출하십시오. 논문을 추가하거나 변경해야한다고 생각하는 이유에 대해 간단한 설명을하는 것이 좋습니다.당신이 뭔가 잘못했다고 걱정하지 마십시오. 우리는 당신을 위해 고칠 것입니다. 여기서 멋진 일을 기여하고 홍보하십시오!

풀 요청을 제출 한 다음 기고자 외에도 Ohad Rubin과 Kang Min Yoo에게 추천 서류에 감사드립니다.