Meta Platforms는 일반 스마트폰과 태블릿에서 대규모 언어 모델을 안정적으로 운영할 수 있는 Llama 모델의 새로운 간소화된 버전인 Llama 3.21B 및 3B를 출시했습니다. Downcodes의 편집자는 이 획기적인 진전과 그 중요성을 자세히 설명할 것입니다.

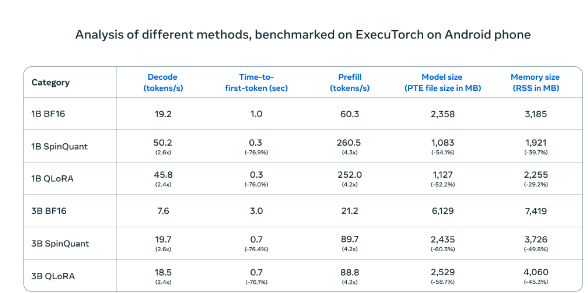

Meta Platforms은 오늘 Llama3.21B 및 3B 제품을 포함하여 Llama 모델의 새로운 간소화된 버전을 출시했습니다. 이를 통해 처음으로 일반 스마트폰과 태블릿에서 대규모 언어 모델의 안정적인 작동이 가능해졌습니다. 정량적 훈련 기술과 최적화 알고리즘을 혁신적으로 통합함으로써 새 버전은 원본 처리 품질을 유지하면서 파일 크기를 56% 줄이고, 실행 메모리 요구 사항을 41% 줄이며, 처리 속도를 원본 버전보다 4배까지 높입니다. 8,000자 텍스트입니다.

Android 휴대폰에서 테스트했을 때 Meta의 압축 AI 모델(SpinQuant 및 QLoRA)은 표준 버전보다 훨씬 빠르고 효율적이었습니다. 더 작은 모델은 더 적은 메모리를 사용하면서 4배 더 빠르게 실행됩니다.

OnePlus12 휴대폰의 실제 테스트에서 이 압축 버전은 표준 버전과 비슷한 성능을 보였으며 동시에 작동 효율성을 크게 향상시켜 모바일 장치의 컴퓨팅 성능 부족이라는 장기적인 문제를 효과적으로 해결했습니다. Meta는 개방형 협력 시장 전략을 채택하고 Qualcomm, MediaTek 등 주류 모바일 프로세서 제조업체와 심층적인 협력을 수행하기로 결정했습니다. 새 버전은 Llama 공식 웹사이트와 Hugging Face 플랫폼을 통해 동시에 출시되어 개발자에게 편리한 액세스를 제공할 예정입니다. 채널.

이 전략은 업계의 다른 거대 기업들과 극명한 대조를 이룹니다. Google과 Apple이 새로운 기술을 운영 체제와 긴밀하게 통합하기로 선택한 경우 Meta의 개방형 경로는 개발자에게 더 큰 혁신의 여지를 제공합니다. 이번 릴리스에서는 데이터 처리 모델이 중앙 집중식 서버에서 개인 터미널로 전환되었습니다. 로컬 처리 솔루션은 사용자 개인 정보를 더 잘 보호할 뿐만 아니라 더 빠른 응답 경험을 제공할 수 있습니다.

이러한 기술적 혁신은 개인용 컴퓨터의 대중화 과정과 유사한 큰 변화를 촉발할 수 있지만 장치 성능 요구 사항 및 개발자 플랫폼 선택과 같은 과제는 여전히 직면하고 있습니다. 모바일 장치의 성능이 지속적으로 향상됨에 따라 현지화된 처리 솔루션의 장점이 점차 나타날 것입니다. 메타는 열린 협력을 통해 산업 전체의 발전을 보다 효율적이고 안전한 방향으로 촉진하고 모바일 기기의 미래 애플리케이션 개발을 위한 새로운 길을 열어가고자 합니다.

Llama 모델의 단순화된 버전은 모바일 AI 애플리케이션에 새로운 가능성을 제공하며, 개방형 협력 전략도 업계로부터 배울 가치가 있습니다. 앞으로는 기술이 계속 성숙해지고 대중화되면서 국지화된 AI 처리가 주류 트렌드가 될 것입니다.