Salesforce AI 연구팀이 출시한 최신 다중 모달 언어 모델 BLIP-3-Video는 증가하는 비디오 데이터를 효율적으로 처리하기 위한 솔루션을 제공합니다. 이 모델은 영상이해의 효율성과 효과를 향상시키는 것을 목표로 하며, 자율주행, 엔터테인먼트 등 다양한 분야에서 널리 활용되어 사회 각계각층에 혁신을 가져오고 있습니다. 다운코드 에디터가 BLIP-3-Video의 핵심기술과 뛰어난 성능에 대해 자세히 설명해드립니다.

최근 Salesforce AI 연구팀은 새로운 다중 모달 언어 모델인 BLIP-3-Video를 출시했습니다. 영상 콘텐츠가 급증함에 따라 영상 데이터를 어떻게 효율적으로 처리할 것인가가 시급한 과제로 대두되고 있다. 이번 모델의 등장은 영상 이해의 효율성과 효과성을 높이는 것을 목표로 하며, 자율주행부터 엔터테인먼트까지 다양한 산업에 적합하다.

기존의 비디오 이해 모델은 비디오를 프레임별로 처리하고 많은 양의 시각적 정보를 생성하는 경우가 많습니다. 이 프로세스는 많은 컴퓨팅 리소스를 소비할 뿐만 아니라 긴 비디오를 처리하는 능력을 크게 제한합니다. 비디오 데이터의 양이 계속해서 증가함에 따라 이러한 접근 방식은 점점 비효율적이 되기 때문에 계산 부담을 줄이면서 비디오의 핵심 정보를 캡처하는 솔루션을 찾는 것이 중요합니다.

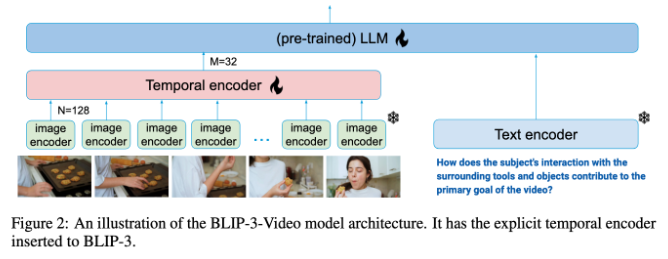

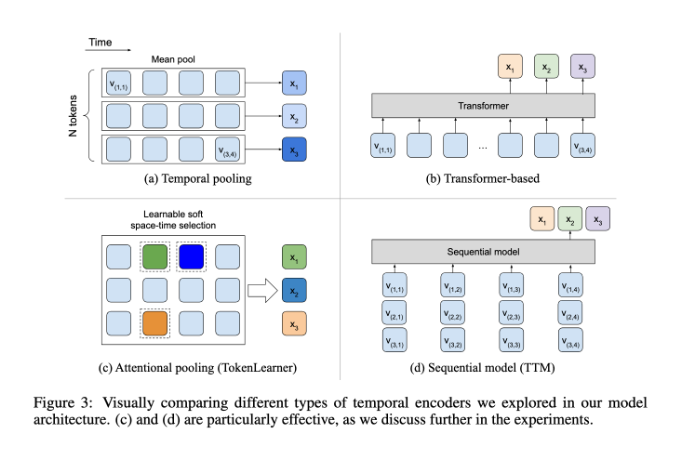

이런 점에서 BLIP-3-Video는 꽤 좋은 성능을 발휘합니다. 이 모델은 "시간 인코더"를 도입하여 비디오에 필요한 시각적 정보의 양을 16~32개의 시각적 마커로 줄이는 데 성공했습니다. 이 혁신적인 디자인은 계산 효율성을 크게 향상시켜 모델이 더 저렴한 비용으로 복잡한 비디오 작업을 완료할 수 있게 해줍니다. 이 시간 인코더는 각 프레임에서 가장 중요한 정보를 추출하고 이를 컴팩트한 시각적 마커 세트에 통합하는 학습 가능한 시공간 주의 풀링 메커니즘을 사용합니다.

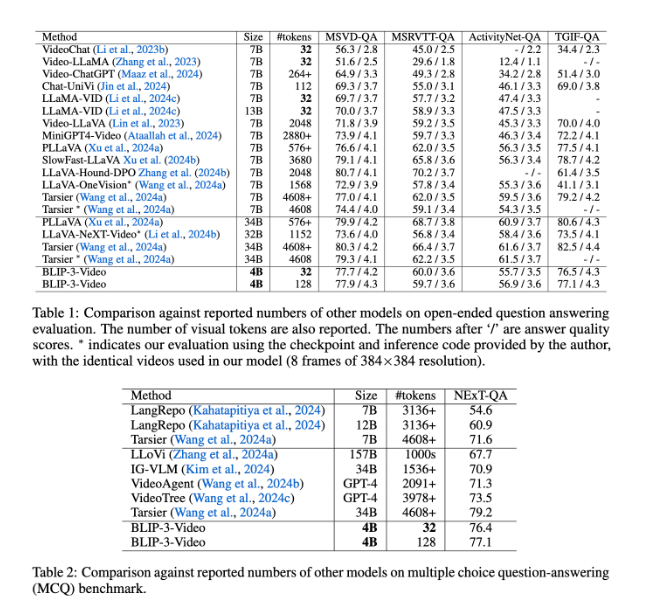

BLIP-3-Video도 매우 잘 작동합니다. 다른 대규모 모델과 비교함으로써, 연구에서는 비디오 질문 응답 작업에서 이 모델의 정확도가 상위 모델의 정확도와 비슷하다는 것을 발견했습니다. 예를 들어 Tarsier-34B 모델은 8개의 비디오 프레임을 처리하는 데 4608개의 마커가 필요한 반면, BLIP-3-Video는 77.7%의 MSVD-QA 벤치마크 점수를 달성하는 데 32개의 마커만 필요합니다. 이는 BLIP-3-Video가 높은 성능을 유지하면서도 자원 소모를 획기적으로 줄여준다는 것을 보여준다.

또한 객관식 질문 및 답변 작업에서 BLIP-3-Video의 성능은 과소평가될 수 없습니다. NExT-QA 데이터 세트에서는 모델이 77.1%의 높은 점수를 얻었고, TGIF-QA 데이터 세트에서도 77.1%의 정확도를 달성했습니다. 이 데이터는 복잡한 비디오 문제를 처리하는 데 있어 BLIP-3-Video의 효율성을 보여줍니다.

BLIP-3-Video는 혁신적인 타이밍 인코더를 통해 비디오 처리에 새로운 가능성을 열어줍니다. 이 모델의 출시는 비디오 이해의 효율성을 향상시킬 뿐만 아니라 향후 비디오 애플리케이션에 더 많은 가능성을 제공합니다.

프로젝트 입구: https://www.salesforceairesearch.com/opensource/xGen-MM-Vid/index.html

BLIP-3-Video는 효율적인 영상 처리 능력으로 미래 영상 기술 발전의 새로운 방향을 제시합니다. 영상 질의응답 및 객관식 질의응답 작업에서 탁월한 성능을 발휘하여 자원 절약 및 성능 향상에 있어 엄청난 잠재력을 보여줍니다. BLIP-3-Video가 더욱 다양한 분야에서 활약하며 영상기술의 발전을 도모해 나가기를 기대합니다.