Downcodes의 편집자는 Tongyi Qianwen 팀이 최근 최신 Qwen2.5-Coder 전체 모델 시리즈를 오픈 소스화했으며 이는 오픈 소스 대형 모델 분야에서 또 다른 이정표를 세웠다는 사실을 알게 되었습니다. Qwen2.5-Coder 시리즈 모델은 강력한 코딩 능력, 다양한 기능, 편리한 실용성으로 인해 많은 주목을 받았습니다. 코드 생성, 복구 및 추론에서 뛰어난 성능을 입증했으며 개발자에게 강력한 도구를 제공하여 오픈 코드의 추가 개발을 촉진했습니다. LLM. 이 모델 시리즈의 오픈 소스는 프로그래밍 분야에서 인공 지능 기술의 적용과 혁신을 크게 촉진할 것입니다.

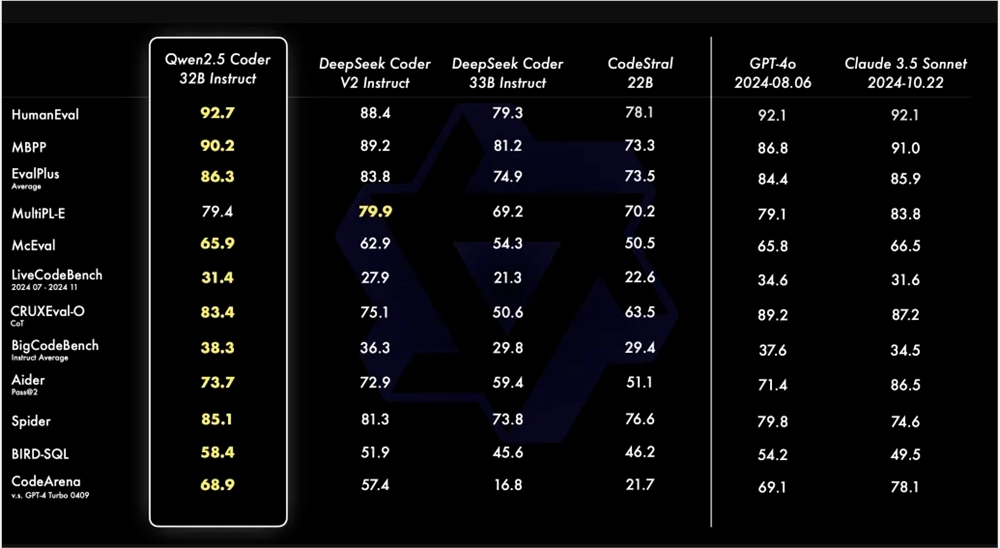

Tongyi Qianwen 팀은 최근 최신 Qwen2.5-Coder 시리즈를 오픈 소스화할 것이라고 발표했습니다. 이러한 움직임은 오픈 코드 LLM 개발을 촉진하는 것을 목표로 합니다. Qwen2.5-Coder는 그 강력함, 다양성, 실용성으로 주목을 받았습니다. Qwen2.5-Coder-32B-Instruct 모델은 코드 기능 측면에서 GPT-4o와 동등한 SOTA 수준에 도달하여 코드 생성, 코드 복구 및 코드 추론을 포함한 포괄적인 기능을 보여줍니다. 다중 코드 생성 벤치마크에서 최고의 성능을 달성했으며 Aider 벤치마크에서 GPT-4o와 비슷한 73.7점을 획득했습니다.

Qwen2.5-Coder는 40개 이상의 프로그래밍 언어를 지원하며 McEval에서 65.9점을 얻었으며 Haskell 및 Racket과 같은 언어가 특히 좋은 성능을 보였습니다. 이는 사전 훈련 단계에서 고유한 데이터 정리 및 매칭이 이루어졌기 때문입니다. 또한 Qwen2.5-Coder-32B-Instruct는 여러 프로그래밍 언어의 코드 복구 기능에서도 우수한 성능을 발휘하여 MdEval 벤치마크에서 75.2점을 획득하여 1위를 차지했습니다.

인간 선호도에 대한 Qwen2.5-Coder-32B-Instruct의 정렬 성능을 테스트하기 위해 내부 주석이 달린 코드 선호도 평가 벤치마크 Code Arena를 구축했습니다. 결과는 Qwen2.5-Coder-32B-Instruct가 우선 정렬에 이점이 있음을 보여줍니다.

Qwen2.5-Coder 시리즈는 이번에 0.5B/3B/14B/32B를 포함하여 4가지 크기의 오픈 소스 모델을 보유하고 있으며 다양한 개발자의 요구 사항을 충족하기 위해 6가지 주류 모델 크기를 포괄합니다. 공식은 Base와 Instruct라는 두 가지 모델을 제공합니다. 전자는 개발자가 모델을 미세 조정하는 기반 역할을 하고 후자는 공식적으로 조정된 채팅 모델 역할을 합니다. 모델 크기와 성능 사이에는 긍정적인 상관관계가 있으며 Qwen2.5-Coder는 모든 크기에서 SOTA 성능을 달성합니다.

Qwen2.5-Coder의 0.5B/1.5B/7B/14B/32B 모델은 Apache2.0 라이센스를 채택한 반면, 3B 모델은 연구 전용 라이센스입니다. 팀은 모든 데이터 세트에서 다양한 크기의 Qwen2.5-Coder의 성능을 평가하여 코드 LLM에 대한 스케일링의 효율성을 확인했습니다.

Qwen2.5-Coder의 오픈 소스는 개발자에게 강력하고 다양하며 실용적인 프로그래밍 모델 선택을 제공하여 프로그래밍 언어 모델의 개발 및 적용을 촉진하는 데 도움을 줍니다.

Qwen2.5-Coder 모델 링크:

https://modelscope.cn/collections/Qwen25-Coder-9d375446e8f5814a

즉, Qwen2.5-Coder의 오픈 소스는 개발자에게 강력한 도구를 제공하며, 뛰어난 성능과 광범위한 적용 가능성은 코드 생성 및 프로그래밍 분야의 발전을 크게 촉진할 것입니다. 우리는 Qwen2.5-Coder가 앞으로 더 많은 애플리케이션 시나리오에서 역할을 할 수 있기를 기대합니다.