다운코드 편집자는 최신 기술 정보를 제공합니다! 시애틀 스타트업 Moondream은 놀라운 컴팩트 시각적 언어 모델인 Moondream2를 출시했습니다. 이 모델은 작은 크기와 강력한 성능으로 업계에 큰 파장을 일으키고 있습니다. 이 오픈 소스 모델은 다양한 벤치마크 테스트에서 우수한 성능을 발휘했으며 일부 측면에서는 더 큰 매개변수로 경쟁사를 능가하여 스마트폰에서 로컬 이미지 인식에 대한 새로운 가능성을 가져왔습니다. Moondream2를 특별하게 만드는 요소와 그 뒤에 숨은 기술 혁신을 자세히 살펴보겠습니다.

최근 시애틀 스타트업인 Moondream은 Moondream2라는 컴팩트한 시각적 언어 모델을 출시했습니다. 작은 크기에도 불구하고 각종 벤치마크 테스트에서 좋은 성적을 거두며 많은 관심을 끌었다. 오픈 소스 모델인 Moondream2는 스마트폰에서 로컬 이미지 인식 기능을 활성화할 것을 약속합니다.

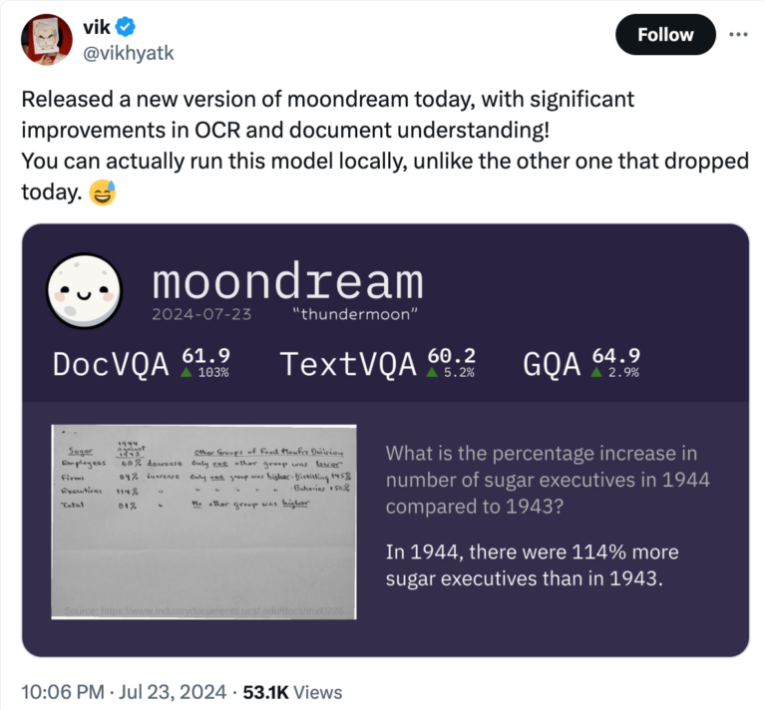

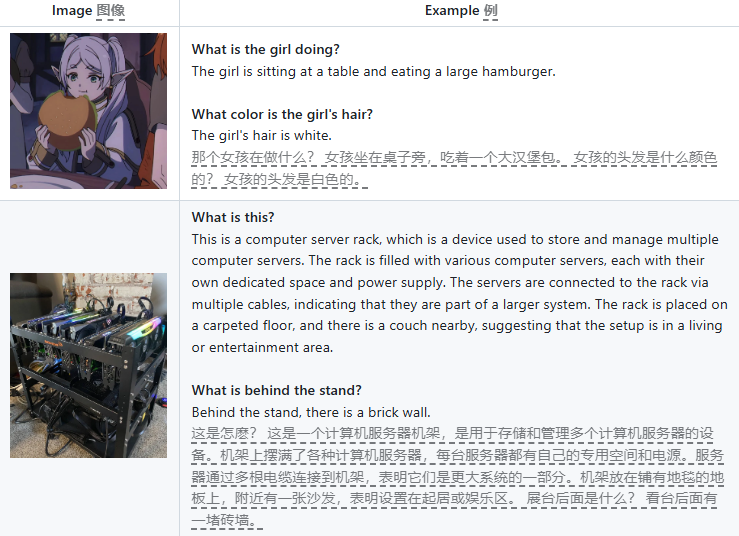

문드림2(Moondream2)는 지난 3월 공식 출시됐다. 이 모델은 텍스트와 이미지 입력을 처리할 수 있으며, 질문 답변, 텍스트 추출(OCR), 객체 계산, 항목 분류 등의 기능을 갖추고 있다. 출시 이후 Moondream 팀은 모델을 계속 업데이트하여 기본 성능을 지속적으로 개선해 왔습니다. 7월 릴리스에서는 특히 과거 경제 데이터 분석에서 OCR 및 문서 이해가 크게 향상되었습니다. DocVQA, TextVQA, GQA에서 모델 점수가 모두 60%를 넘으며 로컬에서 실행될 때 강력한 성능을 보여줍니다.

Moondream2의 주목할만한 특징은 컴팩트한 크기입니다. 매개변수가 16억 개에 불과하므로 클라우드 서버뿐만 아니라 로컬 컴퓨터, 스마트폰이나 단일 보드 컴퓨터와 같은 일부 저성능 장치에서도 실행할 수 있습니다.

작은 크기에도 불구하고 성능은 수십억 개의 매개변수를 사용하는 일부 경쟁 모델과 비슷하며 일부 벤치마크에서는 이러한 대형 모델보다 성능이 뛰어납니다.

모바일 장치의 시각적 언어 모델 비교에서 연구원들은 Moondream2의 매개변수가 1억 7천만 개에 불과하지만 성능은 7억 개의 매개변수 모델과 동일하며 성능은 SQA 데이터 세트보다 약간 열등하다는 점을 지적했습니다. 이는 소규모 모델의 성능이 우수하더라도 특정 상황을 이해하는 데 여전히 어려움을 겪고 있음을 보여줍니다.

모델 개발자인 Vikhyat Korrapati는 Moondream2가 SigLIP, Microsoft의 Phi-1.5 및 LLaVA 교육 데이터 세트와 같은 다른 모델을 기반으로 구축되었다고 말했습니다. 오픈 소스 모델은 이제 GitHub에서 무료로 다운로드할 수 있으며 Hugging Face에 데모 버전이 표시됩니다. 코딩 플랫폼에서도 Moondream2는 5,000개가 넘는 별 리뷰를 받으며 개발자 커뮤니티로부터 폭넓은 관심을 받았습니다.

이 성공은 투자자들의 관심을 끌었습니다. Moondream은 Felicis Ventures, Microsoft의 M12GitHub 펀드 및 Ascend가 주도하는 시드 라운드에서 450만 달러를 모금했습니다. 이 회사의 CEO인 Jay Allen은 수년간 Amazon Web Services(AWS)에서 근무했으며 성장하는 스타트업을 이끌고 있습니다.

Moondream2의 출시는 더 적은 리소스를 필요로 하면서 더 크고 오래된 모델과 유사한 성능을 제공하는 전문적으로 최적화된 일련의 오픈 소스 모델의 탄생을 의미합니다. Apple의 스마트 어시스턴트, Google의 Gemini Nano 등 일부 소규모 로컬 모델이 시장에 나와 있지만 이 두 제조업체는 여전히 더 복잡한 작업을 클라우드에 아웃소싱합니다.

허깅페이스:https://huggingface.co/vikhatk/moondream2

github:https://github.com/vikhat/moondream

Moondream2의 등장은 경량 AI 모델의 활발한 개발을 예고하여 현지화된 AI 애플리케이션에 대한 새로운 가능성을 제공합니다. 또한 오픈 소스 특성은 개발자 커뮤니티의 적극적인 참여를 촉진하고 AI 기술 개발에 새로운 활력을 불어넣습니다. 앞으로도 더욱 유사한 혁신을 기대합니다!