MIT의 새로운 연구에서 대규모 언어 모델(LLM)의 내부 구조와 인간 두뇌 사이의 놀라운 유사성이 밝혀져 인공 지능 분야에서 열띤 논쟁이 촉발되었습니다. Downcodes의 편집자는 이 연구의 획기적인 발견과 그것이 AI의 미래 발전에 미치는 중요성을 자세히 설명할 것입니다. 연구진은 LLM 활성화 공간에 대한 심층 분석을 통해 3단계 구조적 특징을 발견했습니다. 이러한 특징의 발견은 LLM의 작동 메커니즘을 더 잘 이해하고 미래 AI 기술 개발을 위한 새로운 방향을 제시하는 데 도움이 될 것입니다.

AI가 실제로 '뇌를 키우기' 시작했다?! MIT의 최신 연구에 따르면 LLM(대형 언어 모델)의 내부 구조는 놀랍게도 인간의 뇌와 유사합니다!

이 연구에서는 희소 오토인코더 기술을 사용하여 LLM의 활성화 공간에 대한 심층 분석을 수행했으며 놀라운 세 가지 수준의 구조적 특징을 발견했습니다.

첫째, 현미경 수준에서 연구자들은 "결정체"와 같은 구조의 존재를 발견했습니다. 이러한 "수정"의 면은 "남자:여자::왕:여왕"과 같은 친숙한 단어 비유와 유사한 평행사변형 또는 사다리꼴로 구성됩니다.

더욱 놀라운 점은 선형 판별 분석 기술을 통해 일부 관련 없는 간섭 요인(예: 단어 길이)을 제거한 후 이러한 "결정질" 구조가 더 명확해진다는 것입니다.

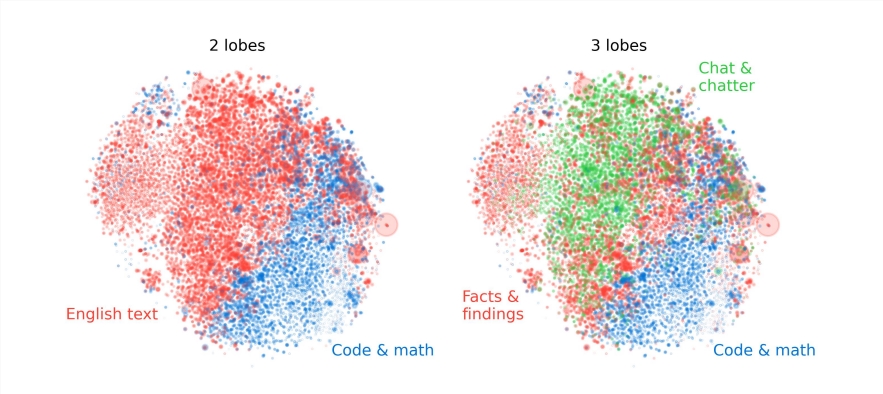

둘째, 메조 수준에서 연구자들은 LLM의 활성화 공간이 인간 두뇌의 기능적 분할과 유사한 모듈식 구조를 가지고 있음을 발견했습니다.

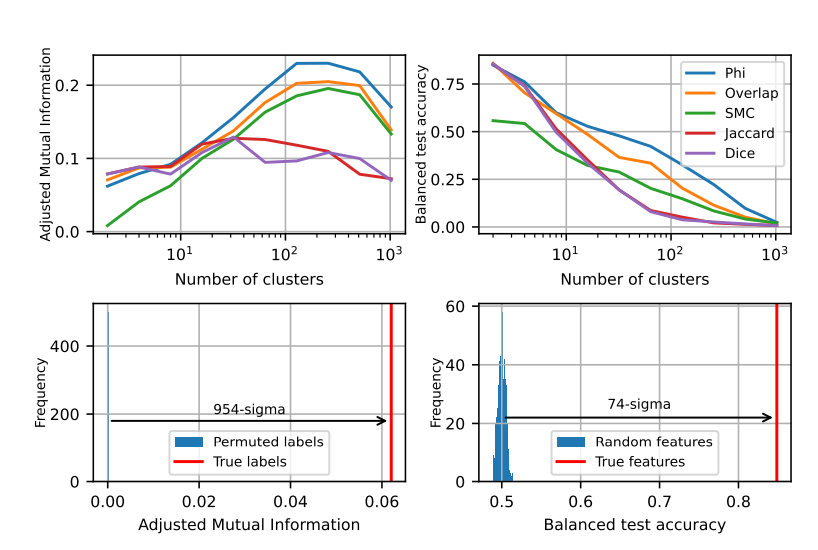

예를 들어 수학과 코딩과 관련된 기능은 함께 클러스터되어 인간 두뇌의 기능적 엽과 유사한 "엽"을 형성합니다. 연구진은 여러 지표의 정량적 분석을 통해 이러한 "엽"의 공간적 위치를 확인했으며, 동시에 발생하는 특징도 무작위 분포에서 예상되는 것보다 훨씬 더 공간적으로 클러스터되어 있음을 보여주었습니다.

거시적 수준에서 연구원들은 LLM 특징점 클라우드의 전체 구조가 등방성이 아니지만 거듭제곱 법칙 고유값 분포를 나타내며 이 분포는 중간 계층에서 가장 분명하다는 것을 발견했습니다.

또한, 연구진은 서로 다른 수준의 클러스터링 엔트로피를 정량적으로 분석한 결과, 중간 계층의 클러스터링 엔트로피가 낮을수록 특징 표현이 더 집중된 것을 알 수 있었고, 초기 및 후기 레이어의 클러스터링 엔트로피가 높아 특징이 나타남을 알 수 있었습니다. 대표성이 더욱 분산되었습니다.

이 연구는 대규모 언어 모델의 내부 메커니즘을 이해하는 데 새로운 관점을 제공하고, 향후 더욱 강력하고 지능적인 AI 시스템 개발을 위한 기반을 마련합니다.

이번 연구 결과는 대규모 언어 모델에 대한 우리의 이해를 심화시킬 뿐만 아니라, 인공지능의 미래 발전을 위한 새로운 방향을 제시하는 흥미로운 결과입니다. Downcodes의 편집자는 기술의 지속적인 발전으로 인공지능이 더 많은 분야에서 강력한 잠재력을 발휘하고 인류 사회에 더 나은 미래를 가져올 것이라고 믿습니다.