대규모 모델 훈련은 시간이 많이 걸리고 노동 집약적이다. 효율성을 높이고 에너지 소비를 줄이는 방법은 AI 분야의 핵심 문제가 되었다. Transformer 사전 훈련을 위한 기본 최적화 도구인 AdamW는 점차 커지는 모델에 대처할 수 없게 됩니다. Downcodes의 편집자는 중국 팀이 개발한 새로운 최적화 프로그램인 C-AdamW에 대해 설명합니다. "신중한" 전략을 통해 훈련 속도와 안정성을 보장하면서 에너지 소비를 크게 줄이고 대규모 모델 훈련에 큰 이점을 제공합니다. . 변화에 혁명을 일으키다.

AI의 세계에서는 기적을 이루기 위해 열심히 노력하는 것이 황금률인 것 같습니다. 모델이 클수록, 데이터가 많아지고, 컴퓨팅 성능이 강력해질수록 지능의 성배에 더 가까워지는 것 같습니다. 그러나 이러한 급속한 발전 뒤에는 비용과 에너지 소비에 대한 큰 압박도 존재합니다.

AI 훈련을 보다 효율적으로 만들기 위해 과학자들은 모델의 매개변수를 지속적으로 최적화하고 궁극적으로 최상의 상태에 도달하도록 안내하는 코치와 같은 보다 강력한 최적화 프로그램을 찾고 있었습니다. Transformer 사전 훈련을 위한 기본 최적화 도구인 AdamW는 수년 동안 업계 벤치마크였습니다. 그러나 점점 더 커지는 모델 규모에 직면하여 AdamW도 그 기능을 감당할 수 없는 것처럼 보이기 시작했습니다.

에너지 소비를 줄이면서 훈련 속도를 높일 수 있는 방법은 없을까요? 걱정하지 마세요. 중국 팀이 비밀 무기 C-AdamW를 가지고 왔습니다!

C-AdamW의 정식 이름은 Cautious AdamW이고 중국 이름은 Cautious AdamW입니다. 매우 불교적인 느낌이 들지 않나요? 네, C-AdamW의 핵심 아이디어는 행동하기 전에 두 번 생각하는 것입니다.

모델의 매개변수가 항상 뛰어다니고 싶어하는 활기 넘치는 어린이 그룹과 같다고 상상해 보세요. AdamW는 헌신적인 교사와 같으며 학생들을 올바른 방향으로 안내하려고 노력합니다. 그러나 때로는 아이들이 너무 흥분해서 엉뚱한 방향으로 달려가 시간과 에너지를 낭비하는 경우도 있습니다.

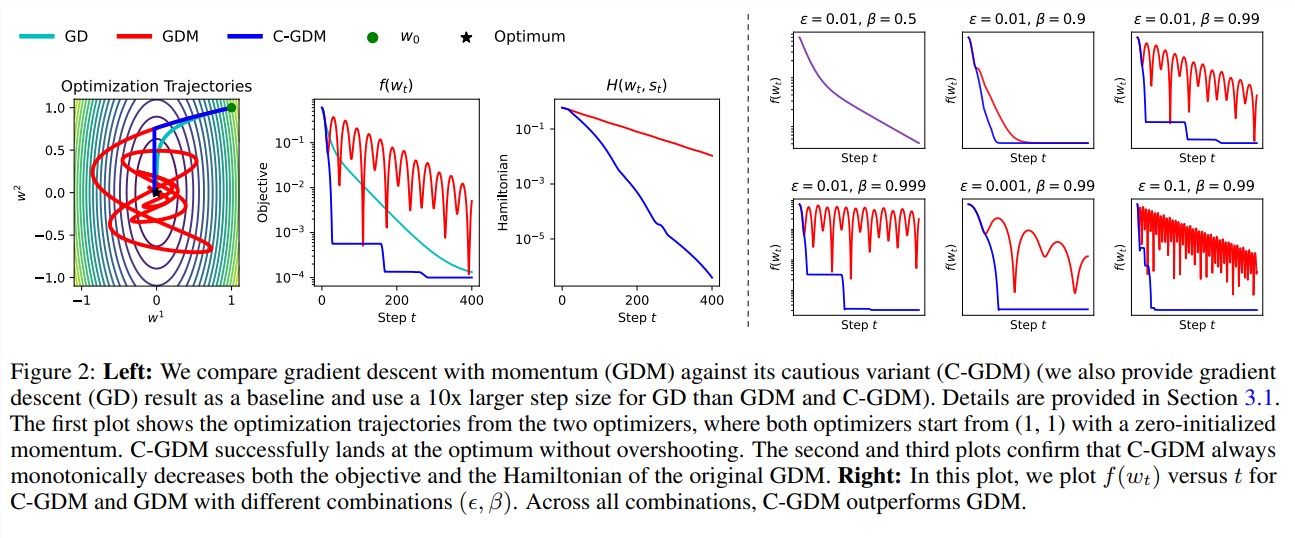

이때 C-AdamW는 업데이트 방향이 올바른지 정확하게 식별할 수 있는 한 쌍의 날카로운 눈을 가진 현명한 장로와 같습니다. 방향이 틀리면 C-AdamW는 모델이 잘못된 길로 더 이상 내려가는 것을 방지하기 위해 단호하게 정지를 요청합니다.

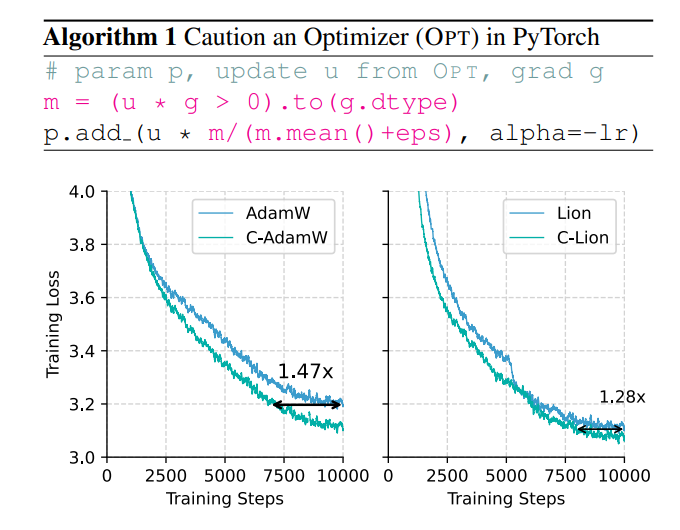

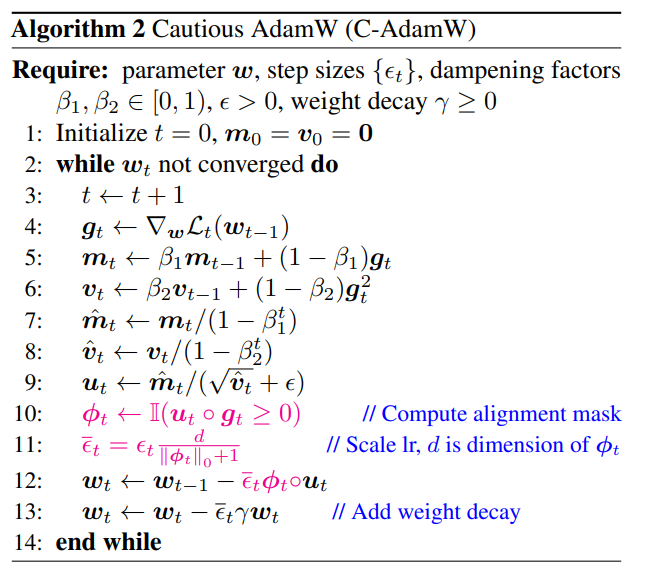

이러한 신중한 전략은 각 업데이트가 손실 함수를 효과적으로 감소시켜 모델 수렴 속도를 높일 수 있도록 보장합니다. 실험 결과 C-AdamW는 Llama 및 MAE 사전 훈련에서 훈련 속도를 1.47배로 증가시키는 것으로 나타났습니다!

더 중요한 것은 C-AdamW가 추가 계산 오버헤드가 거의 필요하지 않으며 기존 코드를 한 줄로 간단히 수정하여 구현할 수 있다는 것입니다. 이는 개발자가 C-AdamW를 다양한 모델 훈련에 쉽게 적용하고 속도와 열정을 누릴 수 있다는 것을 의미합니다!

C-AdamW의 가장 큰 장점은 Adam의 해밀턴 함수를 유지하고 Lyapunov 분석에 따른 수렴 보장을 파괴하지 않는다는 것입니다. 이는 C-AdamW가 더 빠를 뿐만 아니라 안정성도 보장되어 훈련 충돌과 같은 문제가 발생하지 않는다는 것을 의미합니다.

물론 불교도라고 해서 진취적이지 않다는 뜻은 아닙니다. 연구팀은 C-AdamW의 성능을 더욱 향상시키기 위해 더욱 풍부한 ф 함수를 계속 탐색하고 매개변수 공간이 아닌 특징 공간에 마스크를 적용할 것이라고 밝혔습니다.

C-AdamW는 딥러닝 분야에서 새로운 인기를 누리며 대규모 모델 훈련에 혁명적인 변화를 가져올 것으로 예상됩니다!

논문 주소: https://arxiv.org/abs/2411.16085

GitHub:

https://github.com/kyleliang919/C-Optim

C-AdamW의 출현은 대규모 모델 훈련 효율성 및 에너지 소비 문제를 해결하기 위한 새로운 아이디어를 제공합니다. 높은 효율성, 안정성 및 사용하기 쉬운 특성으로 인해 응용 분야가 매우 유망해졌습니다. 앞으로 C-AdamW가 더 많은 분야에 적용되어 AI 기술의 지속적인 발전을 촉진할 수 있을 것으로 기대된다. 다운코드 편집자는 관련 기술 발전에 계속 주의를 기울일 것이므로 계속 지켜봐 주시기 바랍니다!