실시간으로 AI와 상호 작용하는 것은 인공 지능 분야, 특히 다중 모드 정보를 통합하고 대화의 유창함을 유지하는 데 있어 주요 과제입니다. 기존의 많은 AI 시스템은 여전히 실시간 대화 유창성, 상황별 이해, 다중 모드 이해가 부족하여 실제 적용이 제한됩니다. Downcodes의 편집자는 이러한 문제를 해결하기 위해 설계된 오픈 소스 다중 모드 모델 시리즈인 Fixie AI가 출시한 Ultravox v0.4.1을 소개합니다.

인공지능을 적용할 때 AI와의 실시간 상호작용을 어떻게 달성하는가는 항상 개발자와 연구자가 직면한 주요 과제였습니다. 그 중에서 다중 모드 정보(예: 텍스트, 이미지, 오디오)를 통합하여 일관된 대화 시스템을 형성하는 것은 특히 복잡합니다.

GPT-4와 같은 고급 대규모 언어 모델의 일부 진전에도 불구하고 많은 AI 시스템은 여전히 실시간 대화 유창성, 상황 인식 및 다중 모드 이해를 달성하는 데 어려움을 겪고 있어 실제 적용에서의 효율성이 제한됩니다. 또한 이러한 모델의 컴퓨팅 요구 사항으로 인해 광범위한 인프라 지원 없이는 실시간 배포가 매우 어렵습니다.

이러한 문제를 해결하기 위해 Fixie AI는 AI와의 실시간 대화를 가능하게 하도록 설계된 일련의 다중 모드 오픈 소스 모델인 Ultravox v0.4.1을 출시했습니다.

Ultravox v0.4.1은 다양한 입력 형식(예: 텍스트, 이미지 등)을 처리할 수 있는 기능을 갖추고 있으며 GPT-4와 같은 폐쇄 소스 모델에 대한 대안을 제공하는 것을 목표로 합니다. 이 버전은 언어 능력뿐만 아니라 다양한 미디어 유형에 걸쳐 유창하고 상황을 인식하는 대화를 가능하게 하는 데 중점을 둡니다.

오픈 소스 프로젝트인 Fixie AI는 Ultravox를 사용하여 전 세계 개발자와 연구원이 고객 지원부터 엔터테인먼트까지 다양한 애플리케이션에 적합한 가장 진보된 대화 기술에 동등하게 액세스할 수 있기를 희망합니다.

Ultravox v0.4.1 모델은 최적화된 변환기 아키텍처를 기반으로 하며 여러 유형의 데이터를 병렬로 처리할 수 있습니다. 이러한 모델은 교차 모드 주의(cross-modal attention)라는 기술을 사용하여 다양한 소스의 정보를 동시에 통합하고 해석할 수 있습니다.

이는 사용자가 AI에 이미지를 보여주고, 관련 질문을 하고, 실시간으로 정보를 바탕으로 답변을 얻을 수 있음을 의미합니다. Fixie AI는 Hugging Face에서 이러한 오픈 소스 모델을 호스팅하여 개발자가 쉽게 액세스하고 실험할 수 있도록 하며, 실제 애플리케이션에서 원활한 통합을 촉진하기 위한 자세한 API 문서를 제공합니다.

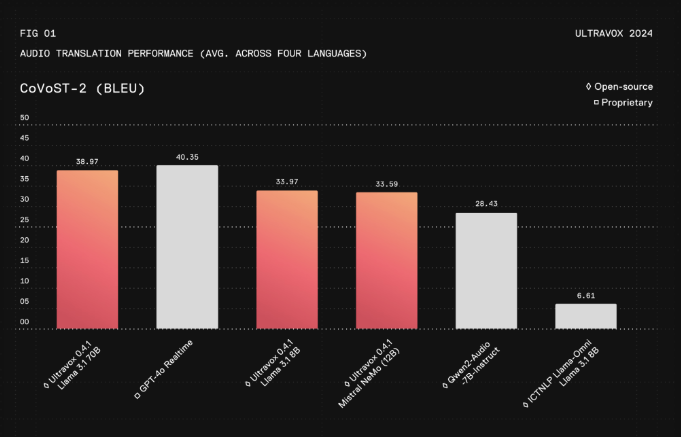

최근 평가 데이터를 바탕으로 Ultravox v0.4.1은 응답 대기 시간을 크게 줄이고 주요 상용 모델보다 약 30% 더 빠르면서도 비슷한 정확성과 상황별 이해를 유지합니다. 이 모델의 교차 모달 기능은 의료 분야의 포괄적인 분석을 위해 이미지와 텍스트를 결합하거나 교육 분야에서 풍부한 대화형 콘텐츠를 제공하는 등 복잡한 사용 사례에서 탁월한 성능을 발휘합니다.

Ultravox의 개방성은 커뮤니티 중심의 개발을 가능하게 하고 유연성을 향상시키며 투명성을 촉진합니다. Ultravox는 이 모델을 배포하는 데 필요한 계산 부담을 줄여 특히 소규모 기업과 독립 개발자가 고급 대화형 AI에 더 쉽게 접근할 수 있도록 하여 이전에 리소스 제약으로 인해 생성된 장벽을 허물었습니다.

프로젝트 페이지: https://www.ultravox.ai/blog/ultravox-an-open-weight-alternative-to-gpt-4o-realtime

모델: https://huggingface.co/fixie-ai

전체적으로 Ultravox v0.4.1은 강력하고 쉽게 액세스할 수 있는 실시간 다중 모드 대화 AI 모델을 개발자에게 제공합니다. 그 오픈 소스 특성과 효율적인 성능은 인공 지능 분야의 발전을 촉진할 것으로 예상됩니다. 자세한 내용은 프로젝트 페이지와 Hugging Face를 방문하세요.