ChatGPT, Wenxinyiyan 등 AI 제품의 기술이 궁금하세요? 그들은 모두 LLM(대형 언어 모델)에 의존합니다. Downcodes의 편집자는 간단하고 이해하기 쉬운 방식으로 LLM의 작동 원리를 이해할 수 있도록 안내합니다. 2학년 수학 수준만 가지고 있어도 쉽게 이해할 수 있습니다! 신경망의 기본 개념부터 시작하여 모델 트레이닝, 고급 기법, GPT, Transformer 아키텍처 등 핵심 기술을 점진적으로 설명함으로써 LLM에 대한 명확한 이해를 돕습니다.

ChatGPT, Wen Xinyiyan 등의 고급 AI에 대해 들어보셨나요? 그 뒤에 있는 핵심 기술은 '대형 언어 모델'(LLM)입니다. 복잡하고 이해하기 어렵다고 생각하시나요? 걱정하지 마세요. 수학 2학년 수준이라도 이 글을 읽고 나면 LLM의 운영 원리를 쉽게 이해할 수 있습니다!

신경망: 숫자의 마법

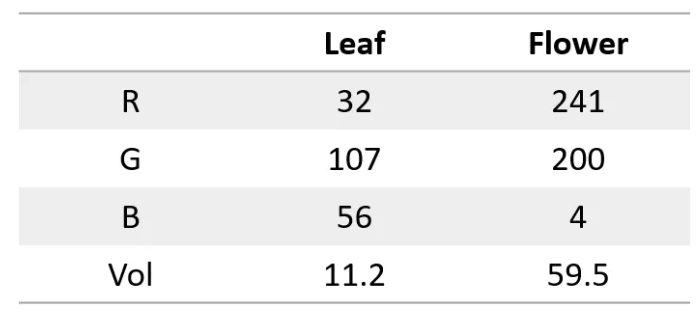

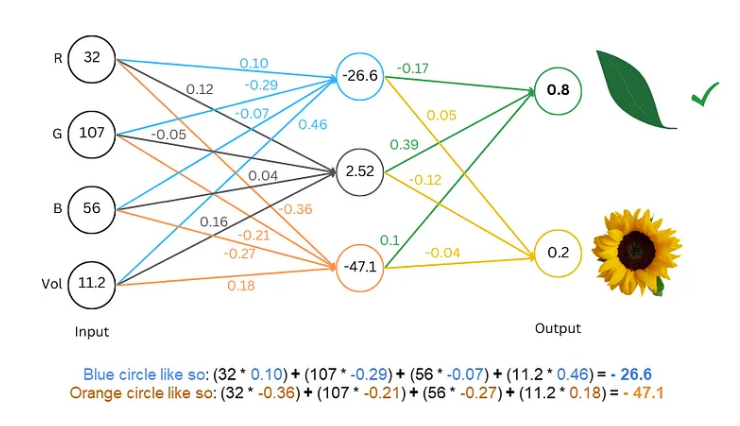

먼저, 신경망은 슈퍼컴퓨터와 같아서 숫자만 처리할 수 있다는 점을 알아야 합니다. 입력과 출력은 모두 숫자여야 합니다. 그렇다면 어떻게 텍스트를 이해하게 만들 수 있을까요?

비결은 단어를 숫자로 변환하는 것입니다. 예를 들어, a=1, b=2 등과 같이 각 문자를 숫자로 나타낼 수 있습니다. 이러한 방식으로 신경망은 텍스트를 "읽을" 수 있습니다.

모델 훈련: 네트워크가 언어를 "학습"하도록 합니다.

디지털 텍스트의 다음 단계는 모델을 훈련하고 신경망이 언어 규칙을 "학습"하도록 하는 것입니다.

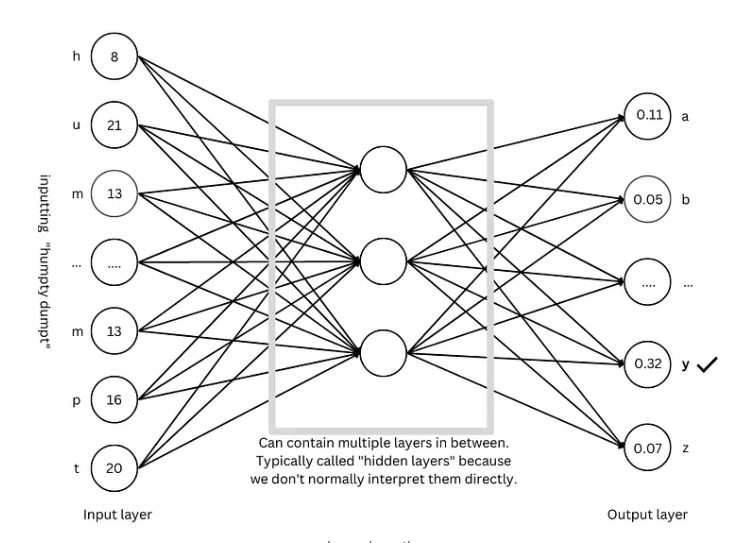

훈련 과정은 추측 게임을 하는 것과 같습니다. 네트워크에 "Humpty Dumpty"와 같은 일부 텍스트를 표시하고 다음 문자가 무엇인지 추측하도록 요청합니다. 추측이 정확하면 보상을 주고, 틀리면 페널티를 줍니다. 끊임없이 추측하고 조정함으로써 네트워크는 점점 더 정확하게 다음 문자를 예측할 수 있으며 결국 "Humpty Dumpty sat on a wall"과 같은 완전한 문장을 생성할 수 있습니다.

고급 기술: 모델을 더욱 "스마트"하게 만듭니다.

모델을 더욱 "스마트"하게 만들기 위해 연구자들은 다음과 같은 많은 고급 기술을 발명했습니다.

단어 임베딩: 문자를 표현하기 위해 단순한 숫자를 사용하는 대신, 숫자 집합(벡터)을 사용하여 각 단어를 표현하므로 단어의 의미를 더 완벽하게 설명할 수 있습니다.

하위 단어 분할기: "cat"을 "cat" 및 "s"로 분할하는 것과 같이 단어를 더 작은 단위(하위 단어)로 분할하여 어휘를 줄이고 효율성을 향상시킬 수 있습니다.

Self-attention 메커니즘: 모델이 다음 단어를 예측할 때 우리가 읽을 때 문맥을 기반으로 단어의 의미를 이해하는 것처럼 문맥에 있는 모든 단어를 기반으로 예측의 가중치를 조정합니다.

잔여 연결: 너무 많은 네트워크 계층으로 인한 훈련 어려움을 피하기 위해 연구자들은 네트워크를 더 쉽게 배울 수 있도록 잔여 연결을 발명했습니다.

다중 헤드 주의 메커니즘: 여러 주의 메커니즘을 병렬로 실행함으로써 모델은 다양한 관점에서 컨텍스트를 이해하고 예측의 정확성을 향상시킬 수 있습니다.

위치 인코딩: 모델이 단어의 순서를 이해할 수 있도록 연구자는 읽을 때 단어의 순서에 주의를 기울이는 것처럼 단어 임베딩에 위치 정보를 추가합니다.

GPT 아키텍처: 대규모 언어 모델을 위한 "청사진"

GPT 아키텍처는 현재 가장 널리 사용되는 대규모 언어 모델 아키텍처 중 하나이며 모델의 설계와 교육을 안내하는 "청사진"과 같습니다. GPT 아키텍처는 위에서 언급한 고급 기술을 교묘하게 결합하여 모델이 언어를 효율적으로 학습하고 생성할 수 있도록 합니다.

Transformer Architecture: 언어 모델의 "혁명"

Transformer 아키텍처는 최근 몇 년 동안 언어 모델 분야에서 획기적인 발전을 이루었습니다. 이는 예측의 정확성을 향상시킬 뿐만 아니라 훈련의 어려움을 줄여 대규모 언어 모델 개발의 기반을 마련합니다. GPT 아키텍처도 Transformer 아키텍처를 기반으로 발전했습니다.

참조: https://towardsdatascience.com/understanding-llms-from-scratch-using-middle-school-math-e602d27ec876

다운코드 편집자의 설명이 대규모 언어 모델의 작동 원리를 이해하는 데 도움이 되기를 바랍니다. 물론 LLM 기술은 아직 개발 중입니다. 이 기사는 빙산의 일각에 불과합니다. 점점 더 심층적인 콘텐츠를 배우고 탐구해야 합니다.