OpenAI의 최신 AI 모델 'o1-preview'(이전 코드명 'Strawberry')가 뜨거운 논의를 불러일으켰습니다. OpenAI는 박사과정생 못지않은 성능을 자랑했지만, 실제 테스트에서는 실망스러운 오류를 보였다. 다운코드 편집자는 기대가 크지만 문제가 있는 AI 모델에 대해 심층적으로 이해하여 해당 AI 모델이 어느 수준에 도달했는지와 사용자의 실제 피드백을 확인할 수 있도록 안내합니다.

최근 OpenAI는 이전에 코드명 "Strawberry"이고 공식적으로 "o1-preview"로 명명된 매우 기대되는 AI 모델을 출시했습니다.

OpenAI는 새로운 모델이 물리학, 화학, 생물학 분야의 어려운 벤치마크 작업에서 박사 과정 학생과 마찬가지로 성능을 발휘할 것이라고 약속합니다. 그러나 예비 테스트 결과에 따르면 이 AI는 인간 과학자나 프로그래머를 대체하려는 목표와는 아직 거리가 멀다.

소셜 미디어에서 많은 사용자가 "OpenAI o1" AI와 상호 작용한 경험을 공유했으며, 그 결과 모델이 여전히 기본 작업에서 제대로 수행되지 않는 것으로 나타났습니다.

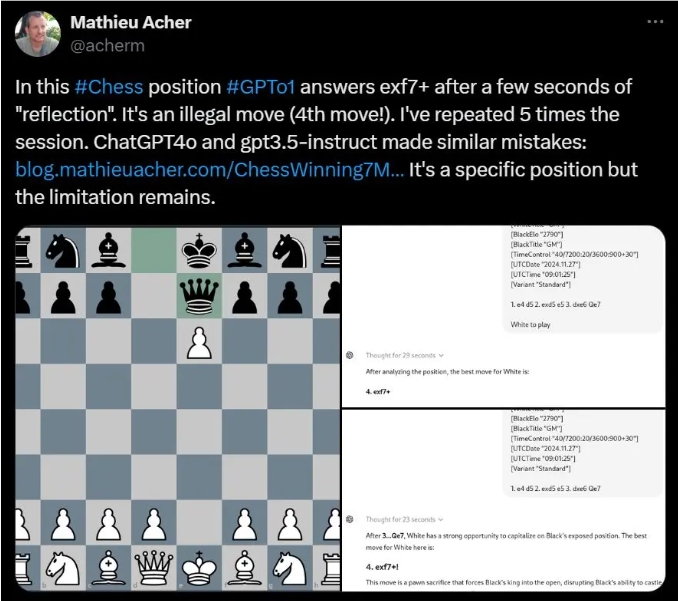

예를 들어, INSA Rennes의 연구원인 Mathieu Acher는 OpenAI o1이 특정 체스 퍼즐을 풀 때 불법적인 움직임을 자주 제안한다는 사실을 발견했습니다.

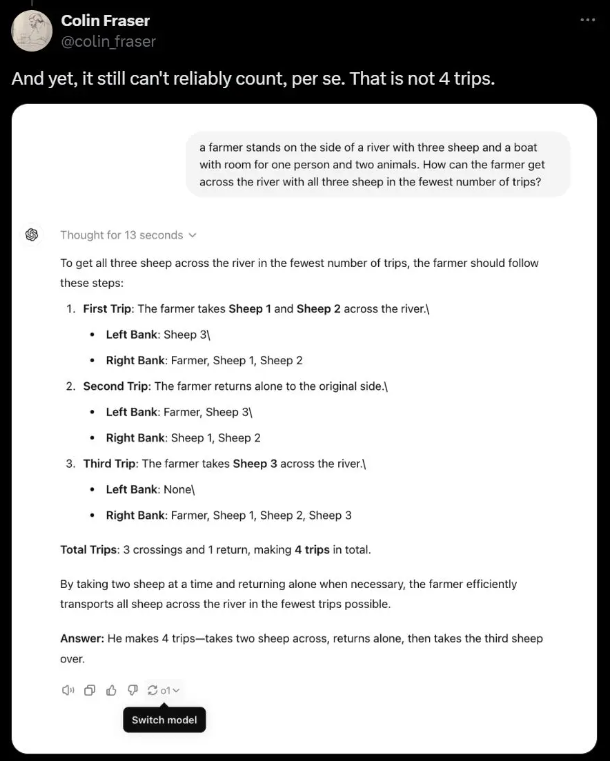

메타 AI 과학자 콜린 프레이저(Colin Fraser)는 농부들이 양을 강 건너편으로 운반하는 간단한 단어 퍼즐에서 AI가 실제로 정답을 포기하고 대신 비논리적인 넌센스를 제공했다고 지적했습니다.

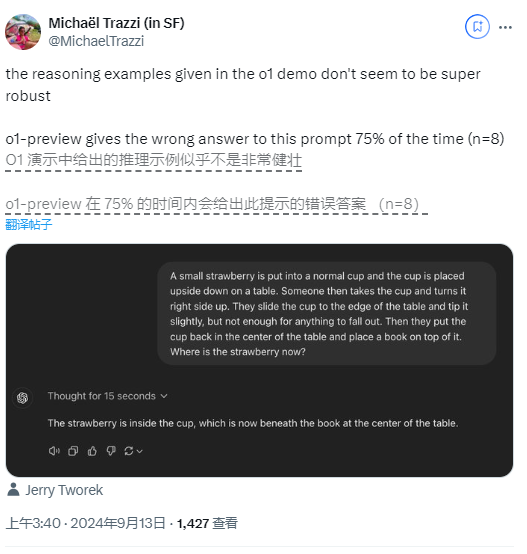

OpenAI가 시연으로 사용한 논리 퍼즐에서도 딸기와 관련된 질문으로 인해 사용자는 서로 다른 답변을 얻었고, 한 사용자는 해당 모델의 오류율이 75%에 달했다고 밝혔습니다.

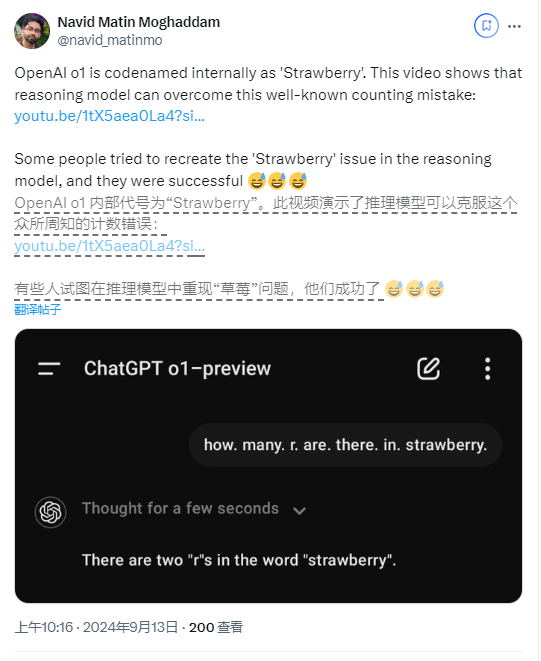

그뿐만 아니라, 일부 사용자들은 새 모델이 '딸기'라는 단어에 'R' 문자가 나타나는 횟수를 세는 데 실수까지 한다고 보고했습니다.

OpenAI는 출시 당시 초기 모델이라 웹 브라우징, 파일 업로드 등의 기능이 아직 없다고 밝혔지만, 이런 기본적인 오류는 여전히 놀랍습니다.

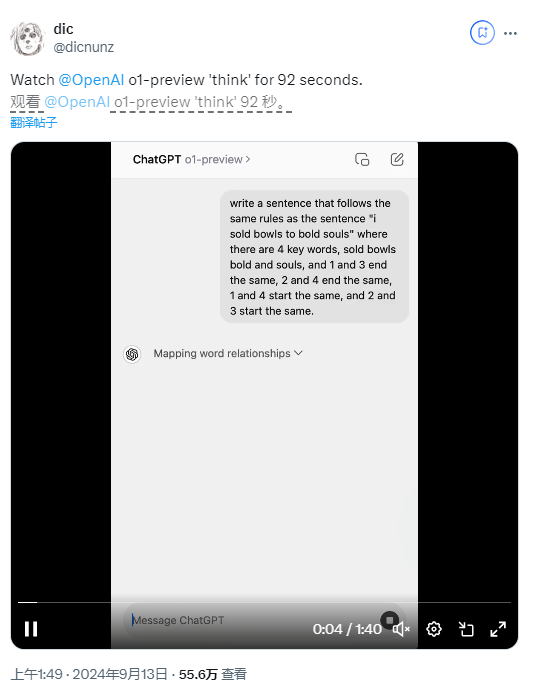

개선을 위해 OpenAI는 새 모델에 "사고 체인" 프로세스를 도입하여 OpenAI o1을 이전 GPT-4o 모델과 크게 다르게 만들었습니다. 이 접근 방식을 사용하면 AI가 답에 도달하기 전에 계속해서 생각할 수 있지만 이로 인해 응답 시간도 길어집니다.

일부 사용자는 모델이 단어 퍼즐에 대한 답을 제공하는 데 실제로 92초가 걸렸지만 결과는 여전히 잘못되었음을 발견했습니다.

OpenAI의 연구 과학자인 Noam Brown은 현재의 응답 속도는 느리지만 향후 버전은 더 오래 생각하고 획기적인 문제에 대한 새로운 통찰력을 제공할 것으로 기대한다고 말했습니다.

그러나 유명한 AI 평론가인 게리 마커스(Gary Marcus)는 이에 대해 회의적이며 장기적인 처리가 반드시 초월적인 추론 능력으로 이어지는 것은 아니라고 믿습니다. 그는 AI 기술이 지속적으로 발전하고 있음에도 불구하고 여전히 실생활 연구와 실험은 필수라고 강조했다.

실제 사용에서 OpenAI의 새로운 AI 모델의 성능은 모든 면에서 여전히 실망스럽다고 볼 수 있으며, 이는 향후 AI 기술 발전에 대한 논의를 촉발하기도 했습니다.

가장 밝은 부분:

최근 OpenAI는 복잡한 작업에서 박사 과정 학생과 비교할 수 있다고 주장하는 새로운 AI 모델 "Strawberry"를 출시했습니다.

많은 사용자들은 AI가 불법적인 움직임을 생각해내고 간단한 퍼즐에 잘못 대답하는 등 기본적인 작업에서 실수를 자주 한다는 것을 발견했습니다.

OpenAI는 모델이 아직 개발 중이지만 오랫동안 생각해도 추론 능력이 향상되지 않을 수 있으며 많은 기본 문제가 해결되지 않은 상태로 남아 있음을 인정합니다.

전체적으로 OpenAI의 'o1-preview' 모델은 AI 기술 개발의 잠재력을 보여주지만 실제 적용에는 많은 단점도 노출하고 있습니다. 앞으로도 AI 모델 개발은 기대되는 목표를 진정으로 달성하기 위해 기술 개선과 실제 적용 사이의 균형을 유지해야 합니다. Downcodes의 편집자는 계속해서 AI 분야의 동향에 주목하고 더욱 흥미로운 보고서를 여러분께 전해드릴 것입니다.