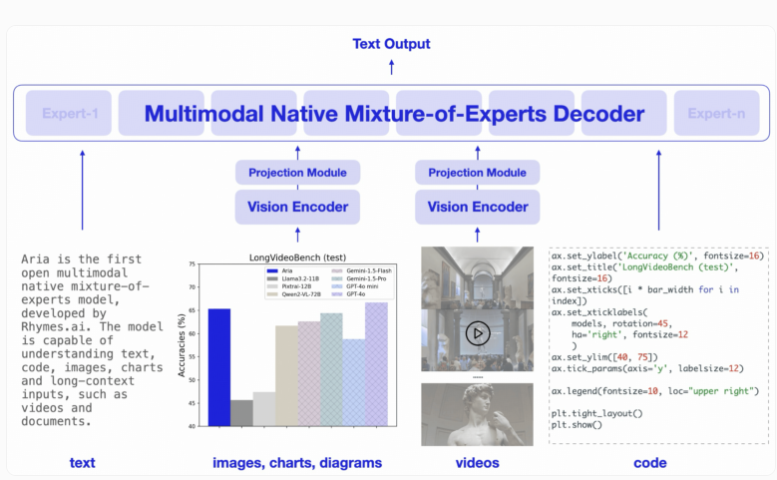

도쿄에 본사를 둔 스타트업 Rhymes AI는 오픈 소스 다중 모드 하이브리드 전문가(MoE) 모델인 첫 번째 인공 지능 모델인 Aria를 출시했습니다. Downcodes의 편집자는 Aria가 텍스트, 코드, 이미지, 비디오 등 다양한 입력을 처리하는 데 탁월한 성능을 발휘하며 그 성능이 일부 잘 알려진 비즈니스 모델을 능가한다는 사실을 알게 되었습니다. Aria는 고유한 MoE 아키텍처를 사용하여 여러 전문 전문가를 통해 계산 효율성을 높이고 최대 249억 개의 매개변수와 64,000개의 토큰으로 구성된 다중 모드 컨텍스트 창을 갖추고 있어 더 긴 입력 데이터를 처리할 수 있습니다. Rhymes AI는 또한 AMD와 협력하여 모델 성능을 최적화하고 AMD 하드웨어 기반 BeaGo 검색 애플리케이션을 출시했습니다.

Aria는 텍스트, 코드, 이미지, 비디오를 포함한 다양한 입력 형식에 걸쳐 탁월한 이해 및 처리 기능을 제공하도록 설계되었습니다. 기존 Transformer 모델과 달리 MoE 모델은 피드포워드 계층을 여러 전문 전문가로 대체합니다. 각 입력 토큰을 처리할 때 라우팅 모듈은 활성화할 전문가의 하위 집합을 선택하여 계산 효율성을 높이고 토큰당 활성화 매개변수 수를 줄입니다.

Aria의 디코더는 텍스트 토큰당 35억 개의 매개변수를 활성화할 수 있으며, 전체 모델에는 249억 개의 매개변수가 있습니다. 시각적 입력을 처리하기 위해 Aria는 다양한 길이, 크기 및 종횡비의 시각적 입력을 시각적 토큰으로 변환할 수 있는 4억 3,800만 개의 매개변수를 갖춘 경량 시각적 인코더도 설계했습니다. 또한 Aria의 다중 모드 컨텍스트 창은 64,000개의 토큰에 도달하므로 더 긴 입력 데이터를 처리할 수 있습니다.

훈련 측면에서 Rhymes AI는 먼저 사전 훈련을 위해 텍스트 데이터를 사용한 다음 다중 모드 데이터를 도입하고 긴 시퀀스 훈련을 거쳐 마지막으로 미세 조정하는 4단계로 나뉩니다.

이 과정에서 Aria는 사전 학습을 위해 총 6조 4천억 개의 텍스트 토큰과 4천억 개의 다중 모드 토큰을 사용했습니다. 데이터는 Common Crawl 및 LAION과 같은 잘 알려진 데이터 세트에서 가져온 것이며 일부 합성 개선이 수행되었습니다.

관련 벤치마크 테스트에 따르면 Aria는 여러 다중 모드, 언어 및 프로그래밍 작업에서 Pixtral-12B 및 Llama-3.2-11B와 같은 모델보다 성능이 뛰어나며 활성화 매개 변수가 적기 때문에 추론 비용이 더 낮습니다.

또한 Aria는 자막이 포함된 동영상이나 여러 페이지로 구성된 문서를 처리할 때 뛰어난 성능을 발휘하며, 긴 동영상과 문서를 이해하는 능력이 GPT-4o mini, Gemini1.5Flash 등 다른 오픈 소스 모델을 능가합니다 .

사용 편의성을 위해 Rhymes AI는 Apache2.0 라이선스에 따라 GitHub에 Aria의 소스 코드를 출시하여 학술 및 상업적 사용을 지원합니다. 동시에 단일 GPU에서 여러 데이터 소스 및 형식에 맞게 Aria를 미세 조정할 수 있는 교육 프레임워크도 제공합니다. Rhymes AI는 모델 성능을 최적화하기 위해 AMD와 협력하고 AMD 하드웨어에서 실행되어 사용자에게 보다 포괄적인 텍스트 및 이미지 AI 검색 결과를 제공할 수 있는 검색 애플리케이션을 시연했다는 점은 언급할 가치가 있습니다.

가장 밝은 부분:

Aria는 세계 최초의 오픈 소스 다중 모드 하이브리드 전문가 AI 모델입니다.

Aria는 텍스트, 이미지, 비디오 등 다양한 입력을 처리할 때 많은 동료 모델보다 성능이 뛰어납니다.

? Rhymes AI는 AMD와 협력하여 모델 성능을 최적화하고 다양한 기능을 지원하는 BeaGo 검색 애플리케이션을 출시합니다.

전체적으로 Aria 모델의 오픈 소스와 고성능은 인공 지능 분야에 새로운 혁신을 가져왔고 개발자와 연구원에게 강력한 도구를 제공했습니다. 다중 모드 기능과 높은 계산 효율성은 향후 응용 분야에서 큰 잠재력을 제공합니다. 다운코드 편집자는 Aria가 더 많은 분야에 응용되고 발전할 수 있기를 기대합니다.