Downcodes의 편집자는 Zhiyuan Research Institute에서 출시한 최신 다중 모드 세계 모델인 Emu3에 대해 알아보도록 안내합니다! Emu3는 텍스트, 이미지 및 비디오의 세 가지 양식에서 획기적인 이해 및 생성 기능을 달성하는 고유한 "다음 토큰 예측" 기능을 사용합니다. 고품질 이미지와 부드럽고 자연스러운 비디오를 생성할 수 있을 뿐만 아니라 정확한 이미지 이해 및 비디오 예측도 수행할 수 있으며, 그 성능은 잘 알려진 많은 오픈 소스 모델을 능가합니다. Emu3의 오픈 소스 특성은 다중 모드 AI 개발에 새로운 활력을 불어넣습니다. 기술 혁신과 그 뒤에 있는 미래 잠재력을 살펴보겠습니다.

Zhiyuan Research Institute는 차세대 다중 모드 세계 모델 Emu3을 공식 출시했습니다. 이 모델의 가장 큰 특징은 텍스트, 이미지 및 비디오의 세 가지 모드로 다음 토큰을 예측할 수 있다는 것입니다.

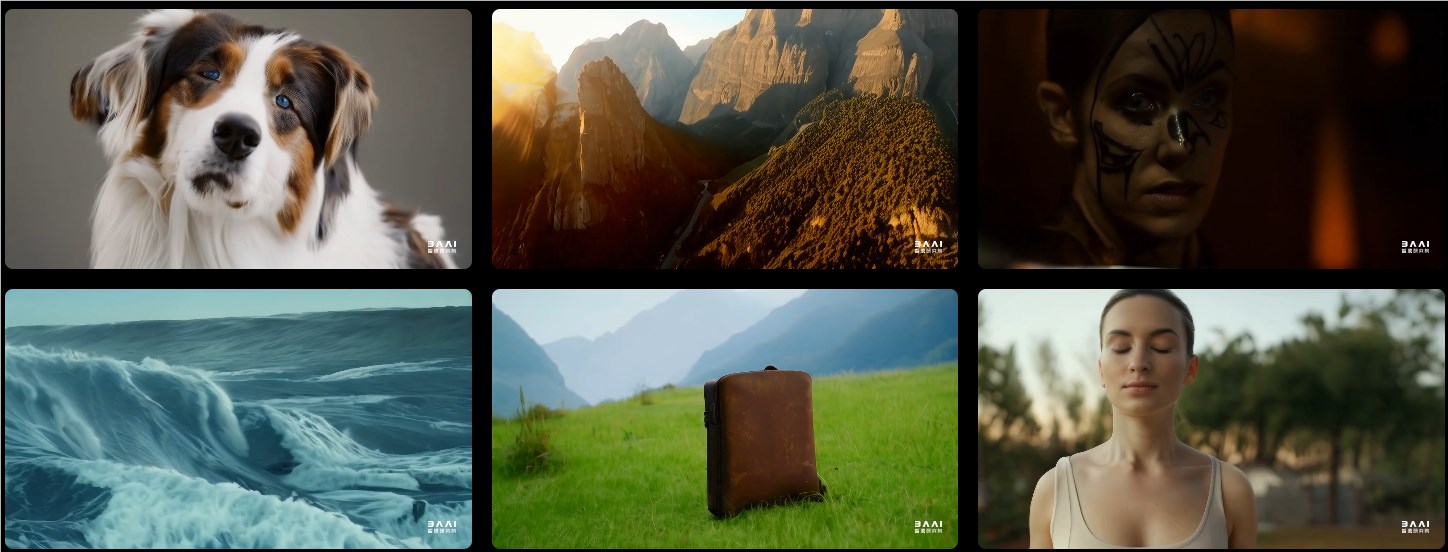

이미지 생성 측면에서 Emu3는 시각적 토큰 예측을 기반으로 고품질 이미지를 생성할 수 있습니다. 이는 사용자가 유연한 해상도와 다양한 스타일을 기대할 수 있음을 의미합니다.

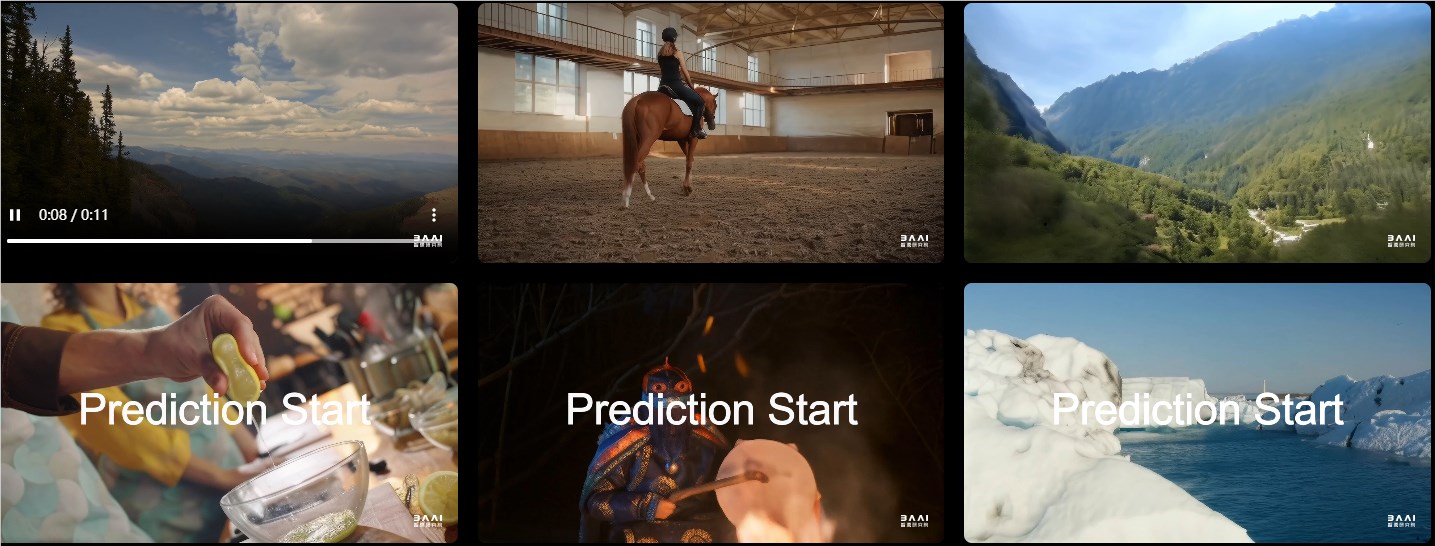

비디오 생성 측면에서 Emu3는 노이즈를 통해 비디오를 생성하는 다른 모델과 달리 순차적 예측을 통해 직접 비디오를 생성하는 완전히 새로운 방식으로 작동합니다. 이러한 기술 발전으로 인해 비디오 생성이 더욱 부드럽고 자연스러워졌습니다.

이미지 생성, 비디오 생성 및 시각적 언어 이해와 같은 작업에서 Emu3의 성능은 SDXL, LLaVA 및 OpenSora와 같은 잘 알려진 많은 오픈 소스 모델의 성능을 능가합니다. 그 뒤에는 비디오와 이미지를 개별 토큰으로 변환할 수 있는 강력한 시각적 토크나이저가 있습니다. 이 디자인은 텍스트, 이미지 및 비디오의 통합 처리를 위한 새로운 아이디어를 제공합니다.

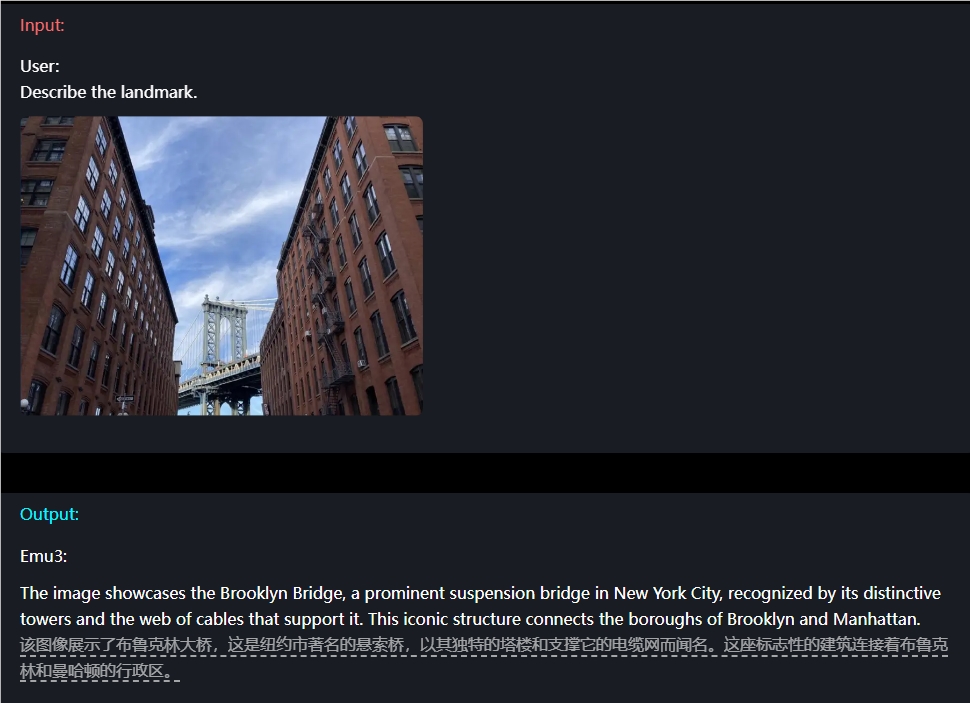

예를 들어, 이미지 이해 측면에서 사용자는 단순히 질문만 입력하면 Emu3가 이미지 내용을 정확하게 설명할 수 있습니다.

Emu3에는 비디오 예측 기능도 있습니다. 비디오가 제공되면 Emu3는 기존 콘텐츠를 기반으로 다음에 무슨 일이 일어날지 예측할 수 있습니다. 이를 통해 환경, 인간 및 동물 행동을 시뮬레이션하는 강력한 기능을 입증할 수 있어 사용자가 보다 현실적인 대화형 경험을 경험할 수 있습니다.

게다가 Emu3의 디자인 유연성도 신선합니다. 생성된 콘텐츠가 사용자 기대에 더 부합하도록 인간의 선호도에 따라 직접 최적화될 수 있습니다. 더욱이 Emu3는 오픈 소스 모델로서 기술 커뮤니티에서 열띤 토론을 불러일으켰습니다. 많은 사람들은 이 성과가 멀티모달 AI의 개발 패턴을 완전히 바꿀 것이라고 믿습니다.

프로젝트 URL: https://emu.baai.ac.cn/about

논문: https://arxiv.org/pdf/2409.18869

가장 밝은 부분:

Emu3는 다음 토큰 예측을 통해 다중 모드 이해와 텍스트, 이미지 및 비디오 생성을 실현합니다.

여러 작업에서 Emu3의 성능은 잘 알려진 많은 오픈 소스 모델의 성능을 능가하여 강력한 기능을 입증했습니다.

Emu3의 유연한 디자인과 오픈 소스 기능은 개발자에게 새로운 기회를 제공하며 다중 모드 AI의 혁신과 개발을 촉진할 것으로 예상됩니다.

Emu3의 출현은 멀티모달 AI 분야에서 새로운 이정표를 세웠습니다. 강력한 성능, 유연한 디자인 및 오픈 소스 기능은 의심할 여지 없이 AI의 미래 개발에 큰 영향을 미칠 것입니다. Emu3가 더 많은 분야에서 활용되어 인류에게 더 많은 편리함과 놀라움을 선사할 수 있기를 기대합니다!