오늘날 AI 기술의 급속한 발전과 함께 리소스가 제한된 장치에서 실행할 수 있는 능력으로 인해 소규모 언어 모델(SLM)이 많은 주목을 받고 있습니다. Nvidia 팀은 최근 Llama 3 모델의 압축을 기반으로 한 뛰어난 소형 언어 모델인 Llama-3.1-Minitron4B를 출시했습니다. 모델 가지치기 및 증류 기술을 활용하여 성능면에서 더 큰 모델과 경쟁하는 동시에 효율적인 교육 및 배포 이점을 제공하여 AI 애플리케이션에 새로운 가능성을 제공합니다. Downcodes의 편집자는 귀하에게 이 기술적 혁신에 대한 심층적인 이해를 제공할 것입니다.

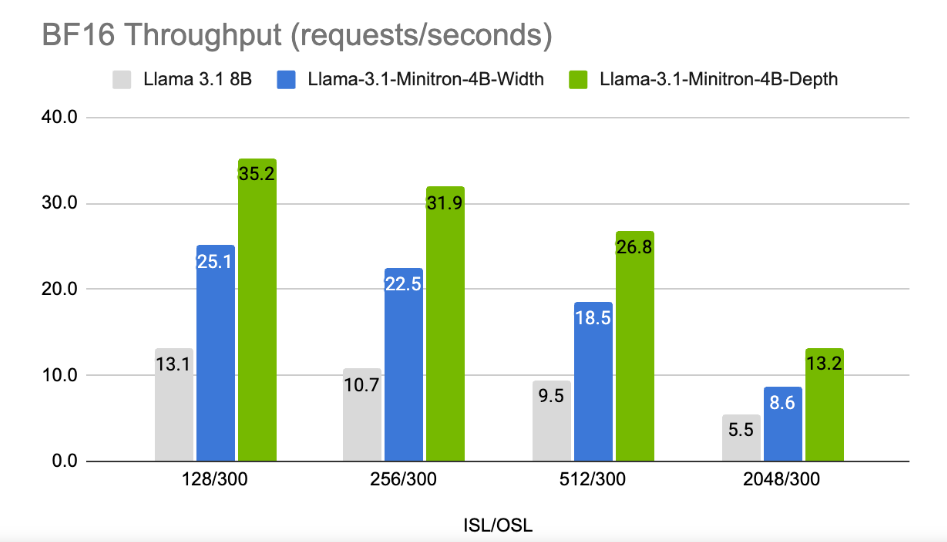

기술 회사가 장치에서 인공 지능을 추구하는 시대에 리소스가 제한된 장치에서 실행할 수 있는 SLM(Small Language Model)이 점점 더 많이 등장하고 있습니다. 최근 Nvidia 연구팀은 최첨단 모델 가지치기 및 증류 기술을 사용하여 Llama3 모델의 압축 버전인 Llama-3.1-Minitron4B를 출시했습니다. 이 새로운 모델은 성능면에서 더 큰 모델과 비교할 수 있을 뿐만 아니라 동일한 크기의 더 작은 모델과 경쟁하는 동시에 교육 및 배포 측면에서 더 효율적입니다.

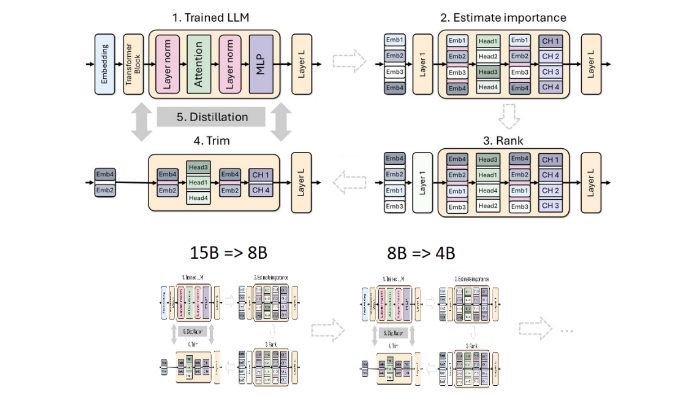

가지치기와 증류는 더 작고 효율적인 언어 모델을 만드는 두 가지 핵심 기술입니다. 가지치기는 전체 레이어를 제거하는 "깊이 가지치기"와 뉴런 및 주의 헤드와 같은 특정 요소를 제거하는 "폭 가지치기"를 포함하여 모델의 중요하지 않은 부분을 제거하는 것을 의미합니다. 반면, 모델 증류는 대규모 모델(예: "교사 모델")의 지식과 기능을 더 작고 단순한 "학생 모델"로 이전합니다.

증류에는 크게 두 가지 방법이 있는데, 첫 번째는 학생 모델이 교사 모델의 입력과 반응을 학습할 수 있도록 하는 "고전적 지식 증류"입니다. 학생 모델에는 학습 교사 모델의 내부 활성화도 필요합니다.

이전 연구에서 엔비디아 연구진은 가지치기(pruning)와 증류(distillation)를 통해 Nemotron15B 모델을 8억 개의 매개변수 모델로 줄이는 데 성공했고, 최종적으로는 4억 개의 매개변수로 더 줄였습니다. 이 프로세스는 유명한 MMLU 벤치마크에서 성능을 16% 향상시킬 뿐만 아니라 처음부터 훈련하는 것보다 필요한 훈련 데이터가 40배 적습니다.

이번에 Nvidia 팀은 동일한 방법을 사용하여 Llama3.18B 모델을 기반으로 4억 개의 매개변수 모델을 만들었습니다. 먼저, 훈련 데이터와 증류된 데이터 세트 간의 분포 차이에 대처하기 위해 940억 개의 토큰이 포함된 데이터 세트에서 정리되지 않은 8B 모델을 미세 조정했습니다. 그런 다음 깊이 가지치기와 너비 가지치기의 두 가지 방법을 사용하여 최종적으로 두 가지 버전의 Llama-3.1-Minitron4B를 얻었습니다.

연구원들은 NeMo-Aligner를 통해 정리된 모델을 미세 조정하고 지시 따르기, 역할극, 검색 증강 생성(RAG) 및 함수 호출에 대한 기능을 평가했습니다.

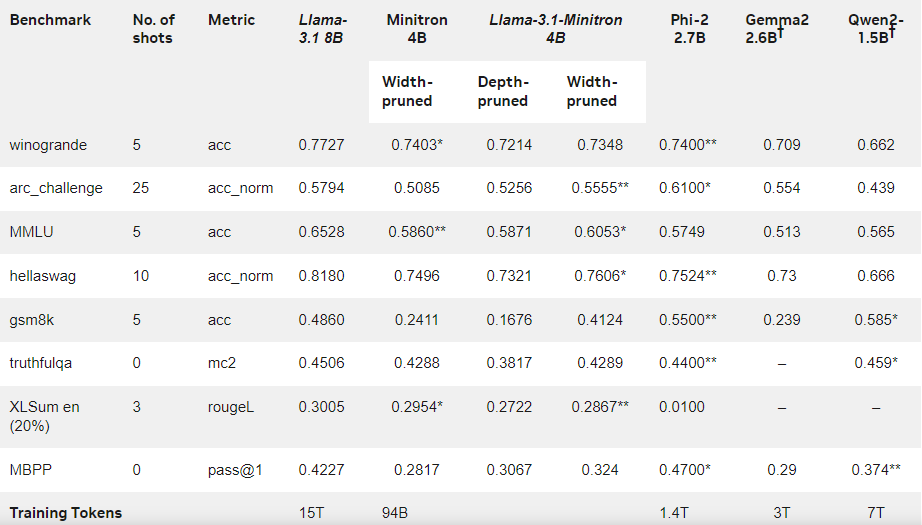

결과는 적은 양의 훈련 데이터에도 불구하고 Llama-3.1-Minitron4B의 성능이 여전히 다른 소형 모델에 가깝고 잘 수행된다는 것을 보여줍니다. 모델의 폭을 줄인 버전이 Hugging Face에 출시되어 상업적 사용이 가능해 더 많은 사용자와 개발자가 효율성과 뛰어난 성능의 혜택을 누릴 수 있도록 돕습니다.

공식 블로그: https://developer.nvidia.com/blog/how-to-prune-and-distill-llama-3-1-8b-to-an-nvidia-llama-3-1-minitron-4b-model /

가장 밝은 부분:

Llama-3.1-Minitron4B는 효율적인 훈련 및 배포 기능을 갖춘 가지치기 및 증류 기술을 기반으로 Nvidia에서 출시한 소규모 언어 모델입니다.

이 모델의 훈련 과정에 사용되는 마커의 양은 처음부터 훈련하는 것보다 40배 줄어들지만 성능은 크게 향상됩니다.

? 사용자의 상업적 사용 및 개발을 용이하게 하기 위해 Hugging Face에 너비 가지치기 버전이 출시되었습니다.

전체적으로 Llama-3.1-Minitron4B의 등장은 소규모 언어 모델 개발에 새로운 이정표를 세웠습니다. 효율적인 성능과 편리한 배포 방법은 더 많은 개발자와 사용자에게 좋은 소식을 전하고 AI 기술의 대중화와 적용을 가속화할 것입니다. Downcodes의 편집자는 앞으로도 더욱 유사한 혁신을 기대합니다.